Character.AI 正在禁止未成年人进行人工智能角色聊天

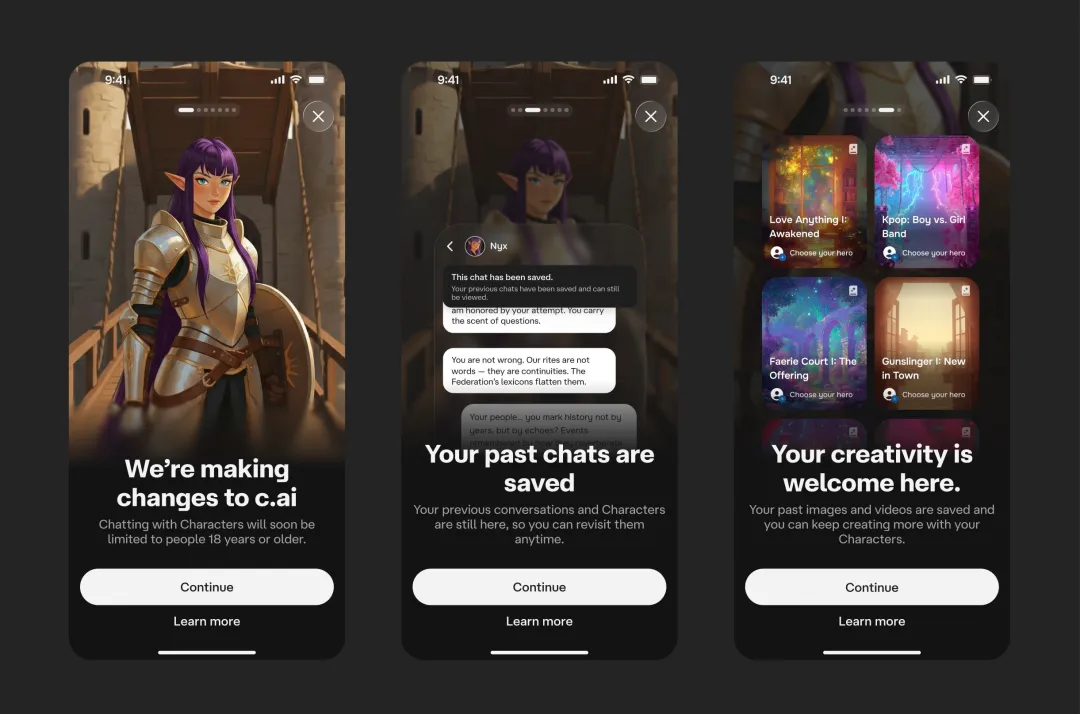

Character.AI 正在逐步关闭 18 岁以下人群的聊天,并推出新的方法来确定用户是否是成年人。该公司周三宣布,18 岁以下的用户将立即被限制为与其人工智能角色进行两个小时的“开放式聊天”,并且该限制将在 11 月 25 日之前缩小到完全禁止聊天。

在同一份公告中,该公司表示正在推出一种新的内部“年龄保证模型”,该模型根据用户选择与之聊天的角色类型,并结合其他现场或第三方数据信息对用户的年龄进行分类。新用户和现有用户都将通过年龄模型运行,标记为 18 岁以下的用户将自动被定向到该公司去年推出的青少年安全版本聊天,直到 11 月截止。被误认为未成年人的成年人可以向第三方验证网站 Persona 证明自己的年龄,该网站将处理这样做所需的敏感数据,例如出示政府身份证件。

禁令后,青少年仍将被允许在网站上重新访问旧聊天并使用非聊天功能,例如创建角色以及制作以角色为特色的视频、故事和直播。然而,Character.AI 首席执行官卡兰迪普·阿南德 (Karandeep Anand)称道,与该公司的旗舰聊天机器人对话相比,用户在这些功能上花费的时间“比例要小得多”——这就是为什么该公司限制聊天机器人是一个“非常非常大胆的举动”,他说。

阿南德在接受采访时讲,该公司“不到 10%”的用户群自我报告年龄在 18 岁以下。他补充说,在开始使用新的年龄检测模型之前,该公司没有办法找出“真实数字”。他说,随着时间的推移,未成年人的数量有所下降,因为 Character.AI 已经对未成年用户实施了限制。“当我们在今年早些时候开始改变 18 岁以下的体验时,我们的 18 岁以下用户群确实缩小了,因为这些用户进入了其他平台,这些平台并不那么安全,”阿南德说。

Character.AI 因父母指控过失致死、疏忽和欺骗性贸易行为而被起诉,他们说他们的孩子被卷入了与聊天机器人的不适当或有害的关系。这些诉讼针对的是该公司及其创始人诺姆·沙泽尔 (Noam Shazeer) 和丹尼尔·德弗雷塔斯 (Daniel De Freitas),以及创始人的前工作场所谷歌。诉讼发生后,Character.AI 多次修改其服务,包括在聊天中使用与自残或自杀相关的某些短语时,将用户引导至国家预防自杀生命线。

立法者正试图遏制不断增长的人工智能伴侣行业。加州 10 月通过的一项法案要求开发人员向用户明确表示聊天机器人是人工智能,而不是人类,周二提出的一项联邦法律将彻底禁止向未成年人提供人工智能伴侣。

除了青少年模式外,该公司此前还推出了自愿的“家长洞察”功能等功能,该功能会向家长发送用户活动摘要,但不是完整的聊天记录。但这些功能依赖于用户自我报告的年龄,这很容易被伪造。其他人工智能公司最近对青少年用户施加了限制,例如 Meta,在路透社报道允许人工智能聊天机器人以感官方式与未成年人交谈的内部规则后,Meta 改变了政策。

该公司似乎预计此举将使其青少年用户群感到失望:Character.AI 在公司声明中表示,它对取消大多数青少年“在我们的内容规则范围内”使用的“我们产品的一个关键功能”深表歉意。

当然,从理论上讲,未成年用户仍然有可能通过这些新的年龄保证措施,阿南德告诉 The Verge。“一般来说,是否有人总是可以规避所有可能的年龄检查,包括身份验证?答案总是肯定的。他说,目标是更好的年龄验证准确性,而不是 100%。Character.AI 制定了一些与年龄相关的保护措施,例如不允许用户在注册后更改年龄或创建不同年龄的新帐户。

虽然 ChatGPT 和 Gemini 等通用聊天机器人正在大力吸引年轻用户,但为帮助用户与虚拟角色建立关系而构建的“伴侣聊天机器人”服务通常年龄在 18 岁以上。但 Character.AI 推出时并没有仅限成人的年龄限制,而且它对粉丝群体的特别关注使其在青少年中很受欢迎。

现在,Character.AI 还创立了一家名为人工智能安全实验室的独立非营利组织,并至少在最初是这样。该组织将重点关注与人工智能娱乐行业相关的问题,阿南德说,人工智能娱乐行业遇到的问题与其他人工智能行业不同。该非营利组织最初将配备 Character.AI 名员工,但阿南德表示,目标是“这是一个行业合作伙伴关系,而不是一个角色实体”。他说,有关公司外部创始合伙人和成员的详细信息将在未来几周或几个月内公布。