IBM发布适用于移动设备和浏览器的小型开源Granite 4模型

IBM公司今天宣布推出Granite 4 Nano,这是一系列极小的生成式人工智能模型,专为在边缘设备、设备上或浏览器中运行而设计。

公司表示,这些模型在体积上表现出极高的性能,是公司迄今为止最小的模型。

Granite 4.0 Nano系列包括四个指令模型及其基础模型,参数在15亿到3.5亿之间。参数是大型语言模型在训练过程中学习的内部值,用于理解用户文本查询的上下文并生成答案。

较大的LLM需要更高的计算能力和能量,导致运营成本增加。它们还需要专用硬件,如强大的图形处理单元和大量的机器内存。小型LLM所需的计算和内存要少得多,这意味着它们可以在消费级硬件上运行,如笔记本电脑、PC和移动设备。

在权衡之下,模型的准确性和上下文知识可能会有所减少,以减小其体积。但通过先进的压缩技术,可以在较小的体积中打包大量的知识和能力。

非常小的LLM增强了隐私和安全性,提供离线访问推理的能力,并允许完全控制和定制。通过避免将敏感数据传输到云服务器,本地LLM也可以是成本效益的,因为它们不产生云费用。

这些模型包括Granite 4.0 H 1B和350M,1.5亿和3.5亿参数模型,具有模型家族的混合架构和两种传统的基于变压器的版本,设计用于在混合工作负载可能没有优化支持的情况下兼容。

Granite 4模型具有专门的架构由IBM开发,结合了额外的算法与大多数LLM所依赖的变压器设计。变压器使用注意力算法通过关注输入中最重要的部分来理解和生成文本。IBM将变压器与基于Mamba神经网络架构的处理组件结合,这比传统变压器更具硬件效率。

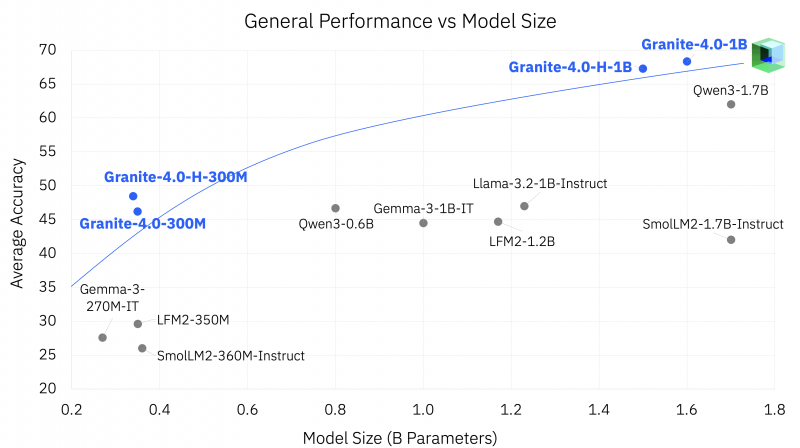

在亚亿到接近1亿参数模型设计市场中竞争激烈,开发者专注于性能和能力。竞争对手包括阿里巴巴集团的Qwen模型,Liquid AI Inc.的液体基础模型和由谷歌公司设计的Gemma模型。

IBM表示,Granite Nano模型在各种基准测试中在一般知识、数学、编码和安全性方面表现优于几个类似大小的模型。此外,Nano模型在代理工作流中表现优于竞争对手,包括在IFEval(指令跟随评估)和伯克利的功能调用排行榜v3中的指令跟随和工具调用。

Granite 4.0 H 1B在IFEval的准确性上达到78.5的最高分,相比之下,Quen3 1.7B为73.1,Gemma 3 1B得分为59.3。在工具调用中,同一模型在伯克利排行榜上获得54.8分,而Quen3为52.2,Gemma 3为16.3。

IBM在开源Apache 2.0许可证下发布了所有Granite 4 Nano模型,该许可证非常宽松。许可证允许广泛的商业使用,并包括对研究的特殊考虑。