AI 编码工具在经验丰富的开发者实地研究中表现不佳

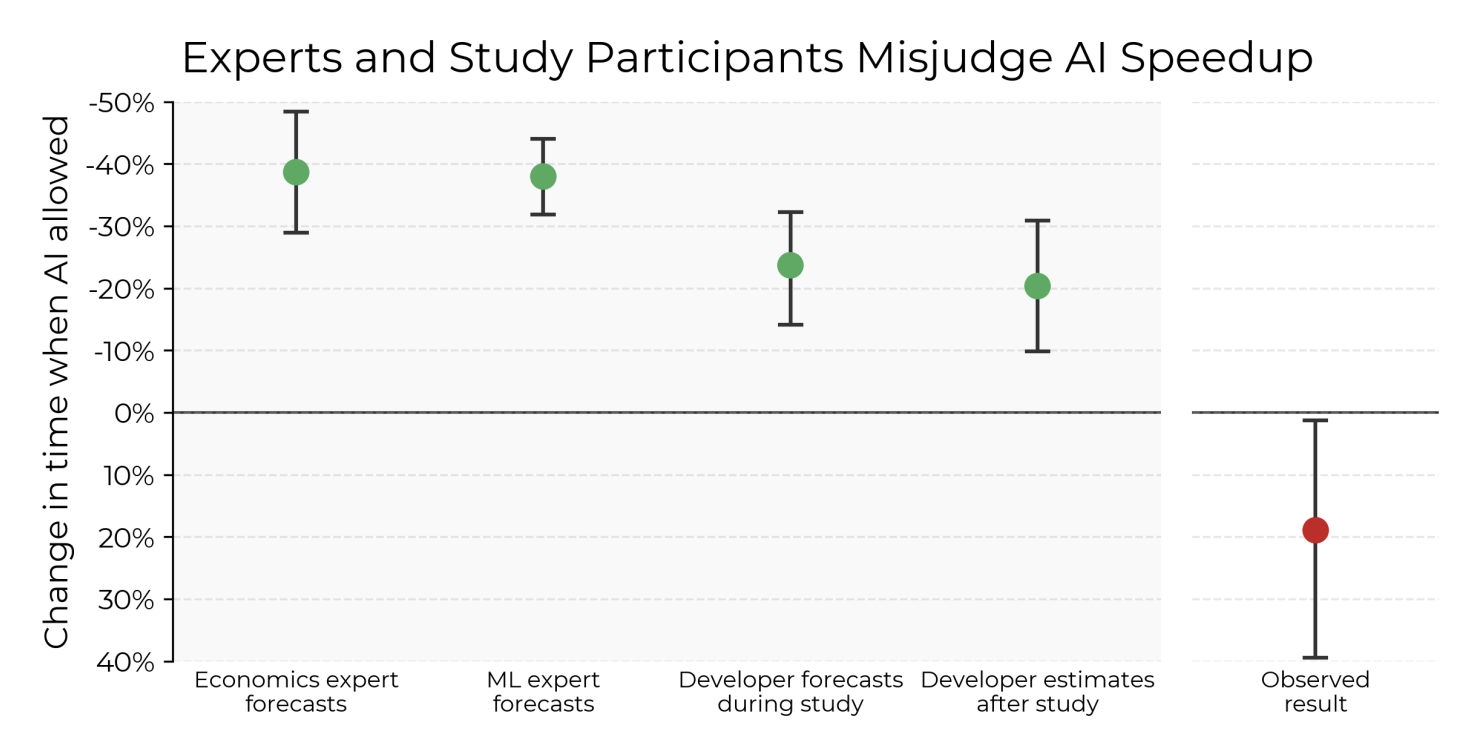

A最近的研究挑战了AI工具加速软件开发的普遍看法。研究人员在METR进行了一项随机对照试验,参与者是使用AI增强开发工具(如Claude 3.5和Cursor Pro)的经验丰富的开源开发者。与预期相反,他们发现AI辅助编程导致任务完成时间增加了19%,即使开发者认为他们的工作速度更快。研究结果揭示了AI的预期承诺与其实际影响之间的潜在差距。

为了在现实条件下评估AI的影响,研究人员设计了一项基于生产级环境的随机对照试验(RCT)。他们没有使用合成基准,而是招募了有经验的贡献者来完成成熟开源代码库中的实际任务。

参与者是16名专业开发者,他们在被分配的项目上平均有五年的经验。代码库包括从他们自己的代码库中提取的现实的、'愤怒中'的问题:非常大(超过110万行代码)、成熟的开源项目。

在246个任务中,每位开发者被随机分配到最多两小时的会话中,使用或不使用AI辅助。那些有权限的使用了Cursor Pro,这是一款集成了Claude 3.5/3.7 Sonnet支持的代码编辑器。对照组被明确禁止使用AI工具。

研究收集了客观和主观指标,包括任务持续时间、代码质量和开发者的感知。在每个任务之前和之后,开发者和外部专家预测AI对生产力的可能影响。

核心结果既引人注目又出乎意料:使用AI辅助的开发者完成任务的时间比不使用AI的开发者长19%。这与参与者和专家的任务前预期相矛盾,他们曾预测平均加速约40%。

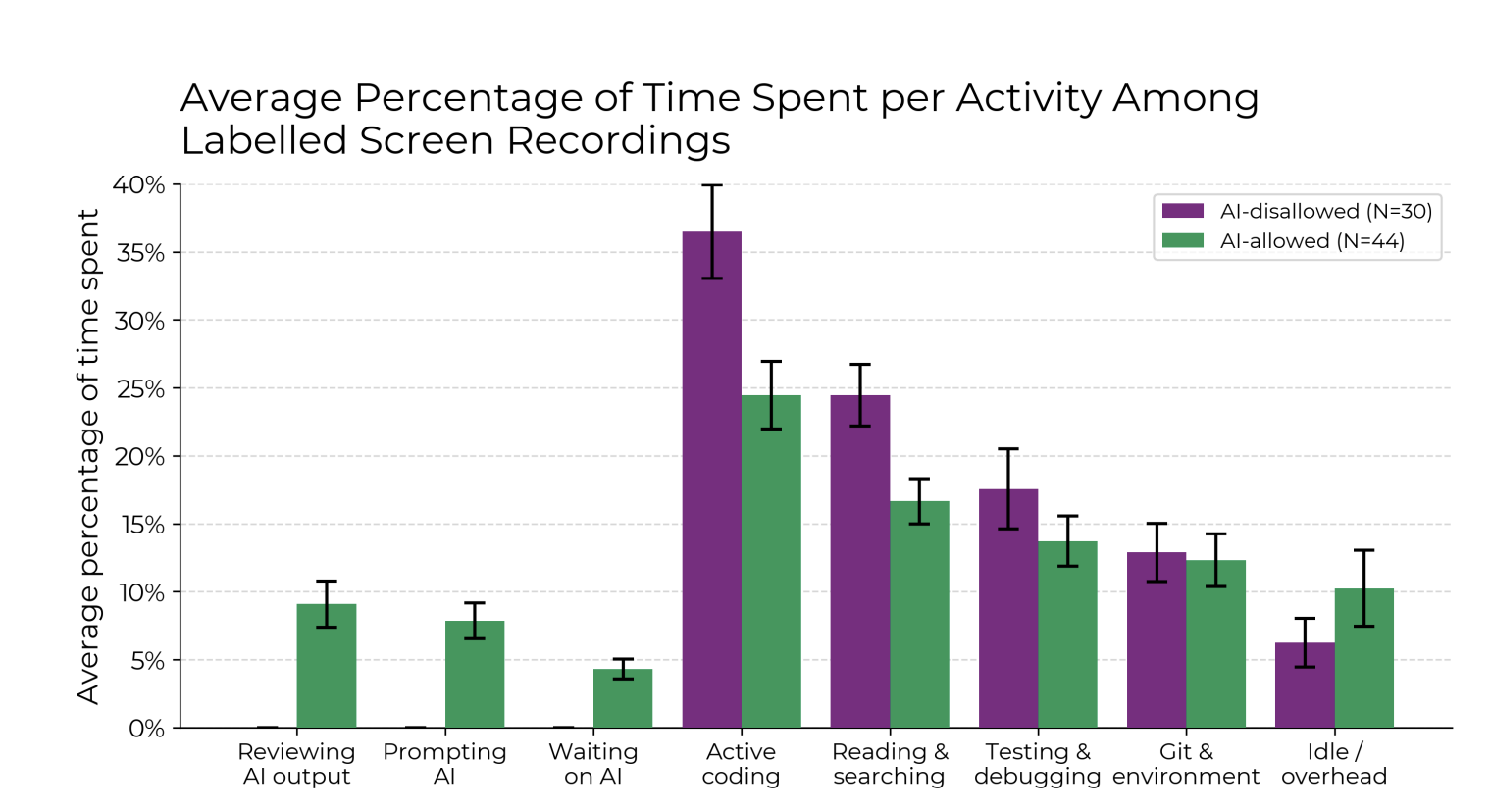

作者将减速归因于多种因素,包括花费在提示、审查AI生成建议以及将输出与复杂代码库集成的时间。通过140多个小时的屏幕录制,他们识别出了导致减速的五个关键因素。这些摩擦可能抵消了代码生成带来的任何初步收益,揭示了感知生产力与实际生产力之间的显著脱节。

研究人员将这种现象称为'感知差距'——AI工具引入的摩擦微妙到在当下不易察觉,但累积起来却减慢了实际输出。感知与结果之间的对比强调了研究的重要性,不仅要基于用户情感,还要基于严格的测量来评估AI工具。

作者警告不要过度泛化他们的发现。虽然研究显示在这种特定环境下AI工具导致了可测量的减速,但他们强调许多导致因素是特定于他们设计的。开发者在大型、成熟的开源代码库中工作——这些项目有严格的审查标准和不熟悉的内部逻辑。任务被限制在两小时内,限制了探索,所有AI交互都通过单一工具链进行。

重要的是,作者强调未来的系统可能会克服这里观察到的挑战。改进的提示技术、代理支架或领域特定的微调可能会在测试的环境中释放出真正的生产力提升。

随着AI能力的快速进步,作者将他们的发现框定为快速变化的环境中的一个数据点,而不是对AI工具有用性的判决——这仍然需要严格的、现实世界的评估。