谷歌LLM突破:实现无限长文本处理能力

谷歌的研究人员最新发表了一篇论文,宣称大型语言模型(LLM)现已具备处理无限长度文本的能力。论文中介绍了一种名为“Infini-attention”的技术,该技术通过调整语言模型的配置,使其“上下文窗口”得以扩展,同时保持内存和计算需求不变。

所谓的上下文窗口,其实就是模型能够同时处理的文本片段长度。比如说,如果你和ChatGPT的聊天内容超出了它的上下文窗口范围,那么它的性能就会大打折扣,甚至可能会忘记聊天开始时的内容。

目前,许多组织都在尝试通过插入特定的文档和知识来定制他们的LLMs应用。因此,增加上下文长度就成了改进模型性能、获取竞争优势的关键。

谷歌研究团队进行的实验表明,使用Infini-attention技术的模型在处理超过一百万个文本片段时,依然能够保持出色的性能,而且无需增加额外的内存。从理论上讲,这种优势可以延续到更大的文本长度。

那么,什么是Infini-attention呢?

LLMs中常用的深度学习架构Transformer在内存占用和计算时间方面存在“二次复杂性”的问题。这意味着,如果输入大小从1000个文本片段增加到2000个,那么处理这些输入所需的内存和计算时间将不仅仅是翻倍,而是会增加到四倍。

这种二次关系主要源于Transformer中的自注意力机制,它会将输入序列中的每个元素与其他所有元素进行比较。

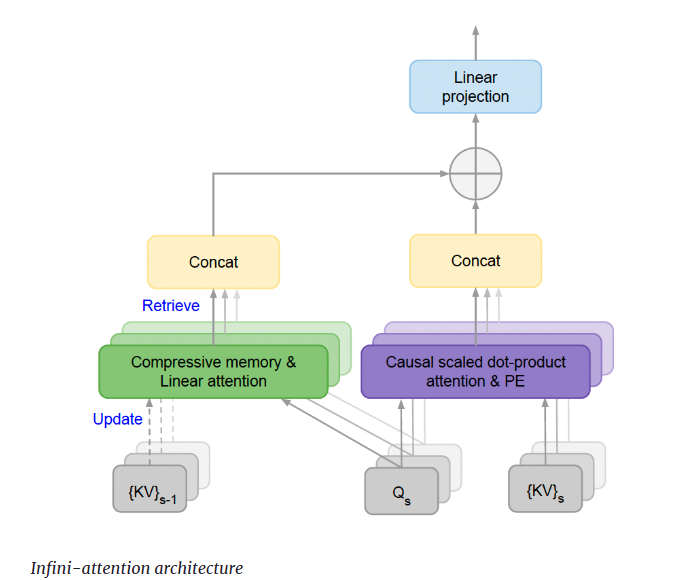

近年来,研究人员已经开发出多种技术来降低扩展LLMs上下文长度的成本。这篇论文将Infini-attention描述为“长期压缩记忆和局部因果注意力”,旨在有效建模长程和短程的上下文依赖关系。

具体来说,Infini-attention保留了Transformer块中的经典注意力机制,并增加了一个“压缩记忆”模块来处理更长的输入。当输入超过模型的上下文长度时,模型会将旧的注意力状态存储在压缩记忆组件中,这个组件通过维持一定数量的记忆参数来提高计算效率。最终,Infini-attention会综合压缩记忆和局部注意力上下文来得出输出结果。

研究人员写道:“通过对Transformer注意力层进行这种微妙但关键的修改,并结合持续的预训练和微调,现有的LLMs能够自然地扩展到处理无限长的上下文。”

那么,Infini-attention在实际应用中表现如何呢?

研究人员在测试LLMs处理超长输入序列的基准上,对使用Infini-attention的Transformer进行了测试。在长上下文语言建模任务中,Infini-attention不仅保持了较低的困惑度分数(衡量模型连贯性的指标),而且相比其他长上下文Transformer模型,还减少了114倍的内存需求。

在“密码检索”测试中,Infini-attention能够成功找回插入到长达一百万个文本片段的长文本中的随机数。同时,在总结长达五十万个文本片段的任务中,它也优于其他长上下文技术。

据论文介绍,这些测试是在拥有10亿和80亿参数的LLMs上进行的。不过,谷歌并未公开这些模型或代码,因此其他研究人员暂时无法验证这些结果。不过,报道的结果与Gemini的性能报告相似,Gemini的上下文长度也能达到数百万个文本片段。

长上下文LLMs的应用前景十分广阔。目前,前沿的人工智能实验室都在这一领域展开研究和竞争。例如,Anthropic的Claude 3支持最多20万个文本片段,而OpenAI的GPT-4的上下文窗口则达到了128,000个文本片段。

具有无限上下文的LLMs的一个显著优势在于能够创建定制化的应用。目前,为特定应用定制LLMs需要采用诸如微调或检索增强生成(RAG)等技术。虽然这些技术非常实用,但它们往往需要复杂的工程工作。

理论上,拥有无限上下文的LLM可以允许你将所有文档插入到提示中,并让模型根据每个查询选择最相关的部分。此外,你还可以通过提供一系列示例来定制模型,以提升其在特定任务上的性能,而无需进行微调。

然而,这并不意味着无限上下文将完全取代其他技术。它将降低应用开发的门槛,使开发者和组织能够快速创建出应用的原型,而无需投入巨大的工程努力。最终,组织将需要优化他们的LLM管道,以降低成本、提高速度和准确性。