使用Patchscopes理解LLM幻觉问题

2024年04月15日 由 samoyed 发表

481

0

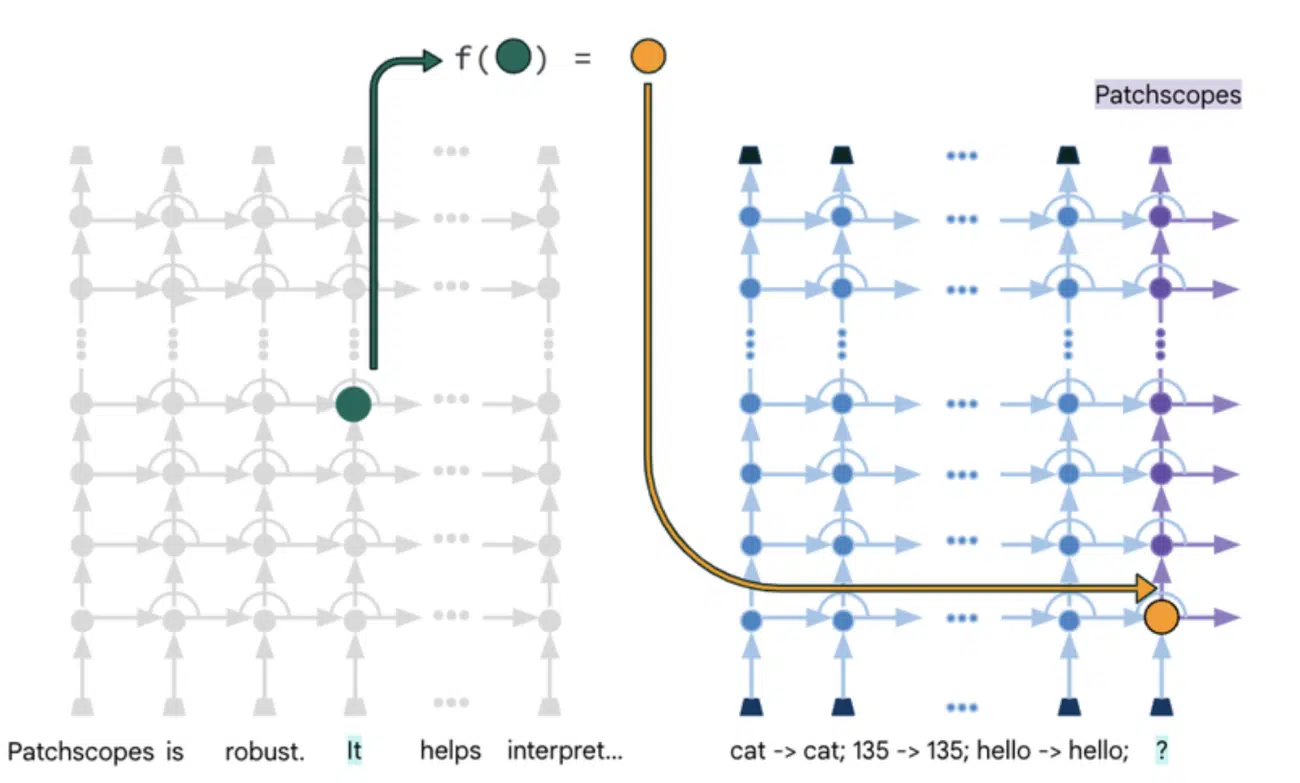

Google Research 最近发布了一篇关于 Patchscopes 的论文,这是一个旨在整合多种过去技术以解释大型语言模型内部机制的框架。它旨在理解 LLM 的行为和与人类价值观的一致性。

这篇论文由 Google 研究人员 Asma Ghandeharioun、Avi Caciularu、Adam Pearce、Lucas Dixon 和 Mor Geva 撰写,Patchscopes 利用 LLM固有的语言技能为其隐藏的内部表达提供直观、自然语言解释。它甚至提供了有关其内部工作原理的解释,解决了以往解释方法的局限性。

幻觉问题的理解?

尽管Patchscopes的初步应用范围仅限于自然语言领域和自回归Transformer模型,但潜在的应用范围更广。

研究人员相信,Patchscopes 可能用于检测和纠正模型幻觉,探索多模态表达(包括图像和文本),以及研究模型如何在复杂情境中形成预测。

可以用四个步骤来解释 Patchscopes 的配置:设置(The Setup)、目标(The Target)、补丁(The Patch)和展示(The Reveal)。向模型展示一个标准提示,然后提供一个旨在提取特定隐藏信息的次要提示。在源提示上执行推断,将隐藏表示注入目标提示中,模型处理增强后的输入,揭示其对上下文的理解。

这篇论文只是触及了这个框架所创造的机会的表面,还需要进一步的研究来理解其在不同领域的适用性。

文章来源:https://analyticsindiamag.com/patchscopes-could-be-an-answer-to-understanding-llm-hallucinations/

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消