DBRX简介:最新开源LLM

开源生成式人工智能领域正经历着巨大的发展势头。创新不仅来自 HuggingFace、Mistral 或 AI21 等初创公司,也来自 Meta 等大型人工智能实验室。主要是在收购 MosaicML 之后,Databricks 已成为从不同角度探索开源生成式人工智能的技术公司之一。几天前,Databricks 开源了 DBRX,这是一个大型通用 LLM,在不同的基准测试中表现出了惊人的性能。

DBRX 基于 Mixtral 使用的专家混合(MoE)方法,这种方法似乎越来越成为基于转换器架构的标准。Databricks 同时发布了基准模型 DBRX Base 和经过微调的结构模型 DBRX Instruct。从最初的报道来看,Databricks 的优势似乎在于数据集和训练过程的质量,尽管这方面的细节很少。

架构

DRRX 是一个大型语言模型,基于转换器的纯解码器框架运行,专门用于预测序列中的下一个标记。它建立在一个复杂的专家混合(MoE)结构之上,拥有 1320 亿个参数,但对于任何给定的输入,它只能使用 360 亿个参数。该模型是在一个包含 12 万亿个标记的数据集(其中包括文本和代码)上通过训练得到的。与同时代的 Mixtral 和 Grok-1 不同的是,DBRX 采用了一种更加细致入微的方法,它拥有 16 个较小的专家,其中 4 个被选中执行任务。这种方法大大增加了潜在专家组合的数量,准确地说,是它们的 65 倍,从而提高了模型的质量。Base 采用了旋转位置编码、门控线性单元和分组查询关注等先进技术来提高性能,并使用了 GPT-4 标记化器。

用于 DBRX 培训的数据集是经过精心编制的,与该组织以前开发的模型所使用的数据相比,相信其代币对代币的效果要高出一倍。这一新数据集得益于全面的数据处理和管理工具,促进了优化的培训方案,通过对数据组合进行战略性调整,显著提高了模型质量。

训练

DBRX 的开发历时三个月,依靠通过 3.2Tbps Infiniband 网络连接的 3072 个英伟达 H100 GPU。在此期间,包括数据集研究和扩展实验在内的大量准备工作达到了顶峰,所有这些都是语言模型开发持续演进的一部分。值得注意的是,与传统模型相比,Base 的 MoE 变体的训练大大提高了计算效率。

这一效率突破是该模型训练管道全面进步的一部分,与十个月前相比,现在的计算效率提高了近四倍。这种效率的提高是通过架构创新、优化技术以及更高质量训练数据的使用共同实现的。

在 DBRX 的整个开发过程中,数据管理、处理和模型训练都使用了一套专有工具,以确保无缝集成的工作流程。这些工具允许在大量 GPU 上进行广泛的探索、数据清理和高效的模型训练,最终简化了模型完善和部署流程。

推理

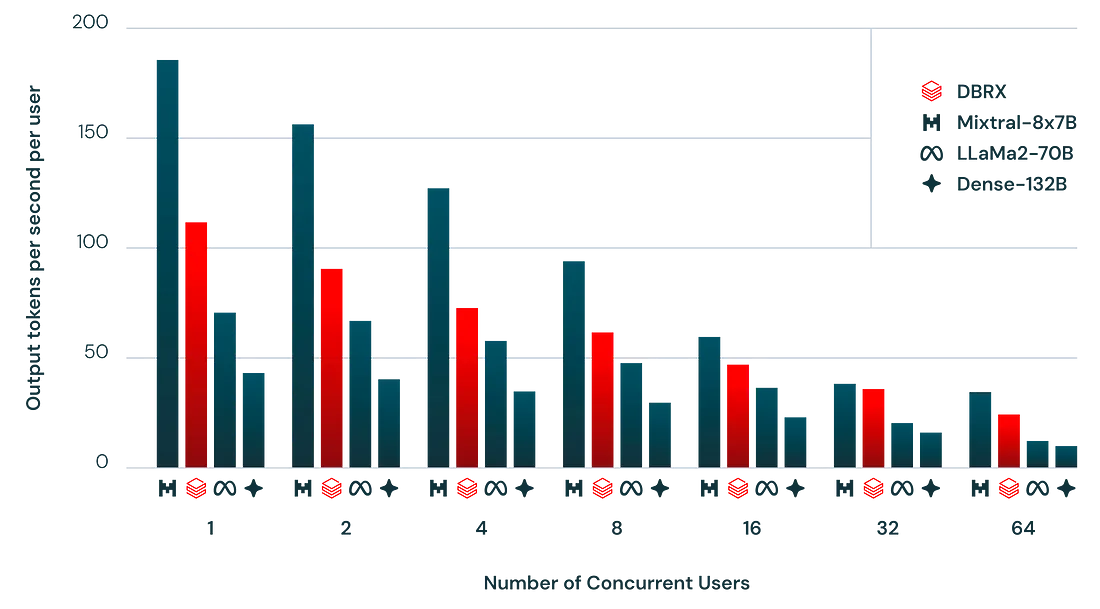

DBRX 的架构在模型质量和推理效率之间实现了微妙的平衡,在这方面优于密集模型。例如,尽管 DBRX 模型规模较小,但由于其有效使用了主动参数,推理吞吐量是同类模型的两倍。该模型在各种基准测试中提供了增强的性能指标,为质量和效率设定了新标准。

DBRX Instruct

DBRX 还有一个专为执行指令任务而设计的专门版本,称为 DBRX Instruct。该版本共享 MoE 架构,采用有针对性的培训方法,在需要短暂交互的应用中表现出色。

评估

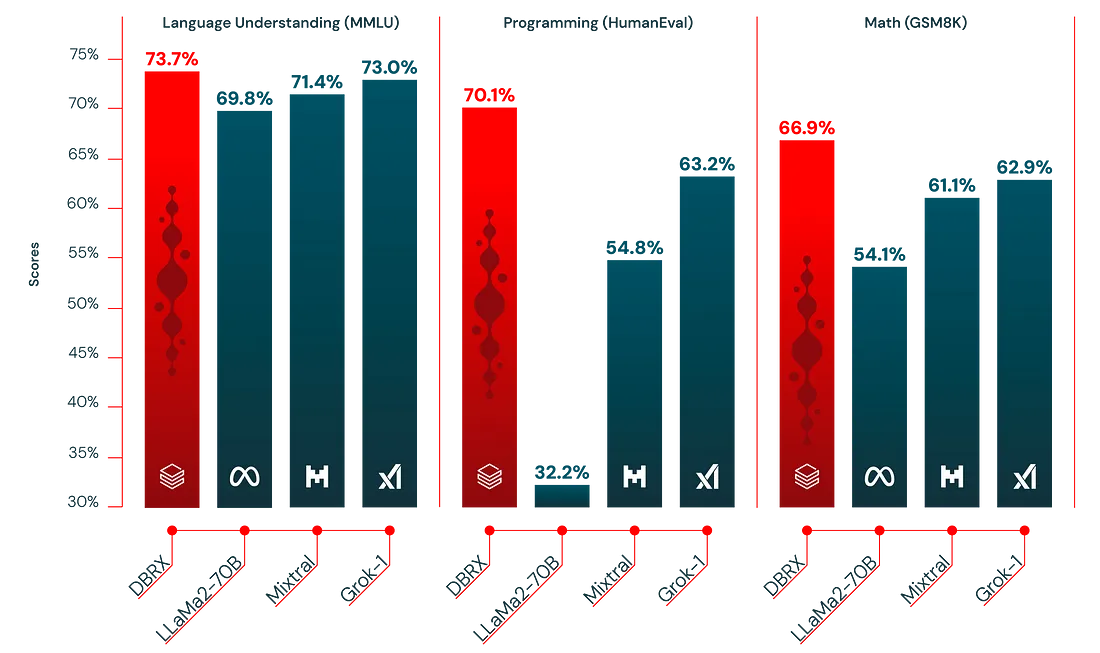

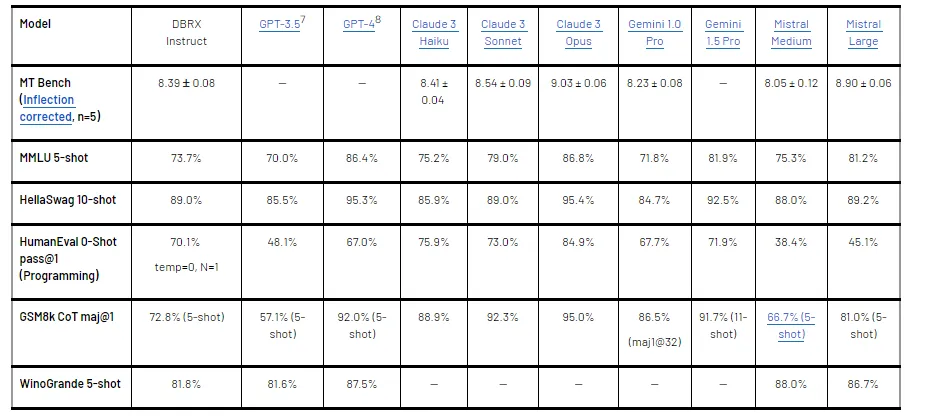

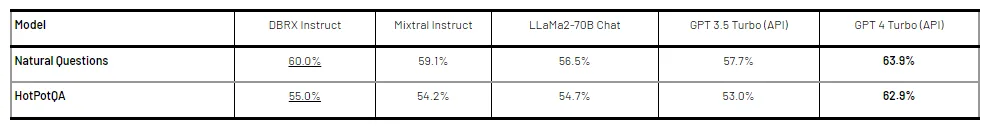

DBRX 及其指令跟随变体对照开源模型和商业模型进行了严格的评估,在包括常识、常识推理以及编程和数学等专业领域在内的一系列指标上都表现出了卓越的性能。

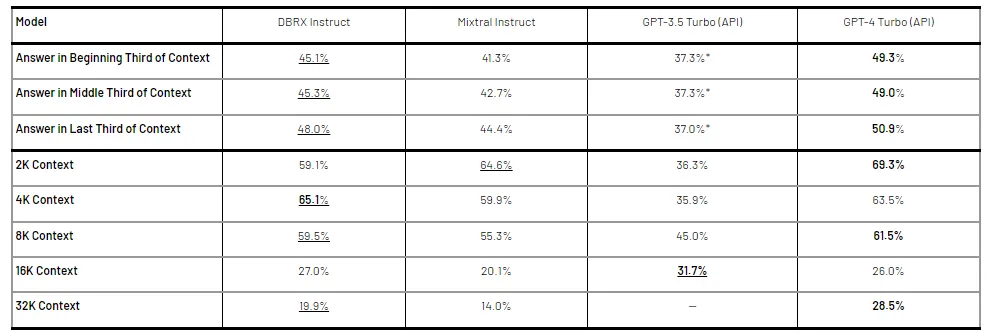

该模型在处理长语境查询方面表现出了非凡的能力,让人们深入了解了它在各个领域的能力和潜在应用。

RAG 是 DBRX 的另一个优势领域

使用 DBRX

DBRX 和 DBRX Instruct 可通过 HuggingFace 平台实施,确保用户可直接进行集成。这些模型的运行需要大量内存,但正如实际示例所展示的那样,它们是处理复杂语言理解和生成任务的强大工具集。

from transformers import AutoTokenizer, AutoModelForCausalLM

import torch

tokenizer = AutoTokenizer.from_pretrained("databricks/dbrx-instruct", trust_remote_code=True, token="hf_YOUR_TOKEN")

model = AutoModelForCausalLM.from_pretrained("databricks/dbrx-instruct", device_map="cpu", torch_dtype=torch.bfloat16, trust_remote_code=True, token="hf_YOUR_TOKEN")

input_text = "What does it take to build a great LLM?"

messages = [{"role": "user", "content": input_text}]

input_ids = tokenizer.apply_chat_template(messages, return_dict=True, tokenize=True, add_generation_prompt=True, return_tensors="pt")

outputs = model.generate(**input_ids, max_new_tokens=200)

print(tokenizer.decode(outputs[0]))

DBRX 代表着 Databricks LLM 堆栈的重大升级。DBRX 与他们的企业发行版一起,将成为新一轮生成式人工智能浪潮中最重要的开源 LLM 模型之一。