大型语言模型 (LLM) 可以用来标记数据吗?

本文旨在提供一份简单易懂的摘要,介绍有关使用 LLM对数据进行标注的研究。我们将介绍目前关于使用 LLM对文本数据进行标注的观点,以及在你自己的项目中需要考虑的事项。

为什么要使用 LLM 进行标注?

高质量的标注数据为在不同任务中训练和评估机器学习模型奠定了基础。目前,标注数据集最常见的方法是雇用群众工作者(例如 Amazon Mechanical Turk),或领域专家。

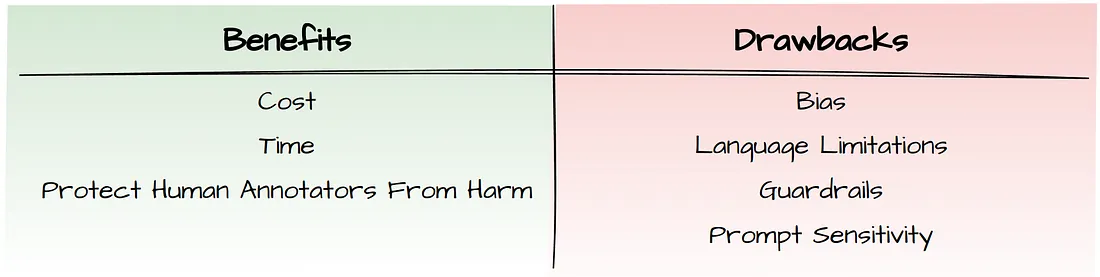

这些方法可能相当昂贵和耗时,这就是为什么现在很多人都想知道 LLM 能否很好地处理数据标注工作。预算有限的企业可以通过建立满足其特殊需求的专业模型来从中获益。在医学等较为敏感的领域,通过让专家审核和纠正 LLM 标签,而不是从头开始,有可能加快贴标过程。

不同研究的当前观点

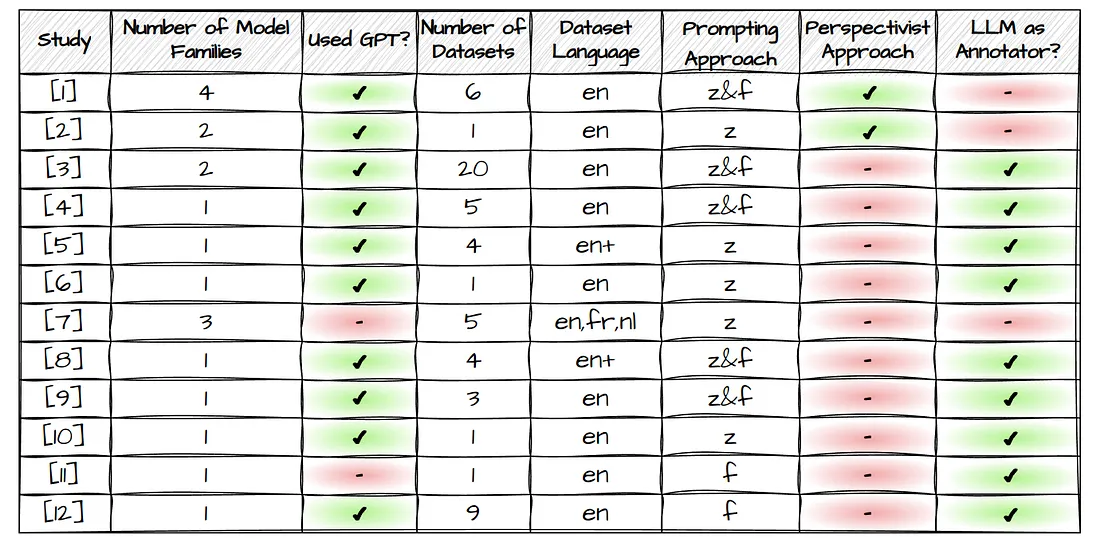

关于 LLM 作为标注者的潜力,不同研究的观点存在一定分歧。一些研究对 LLM 的能力持乐观态度,而另一些研究则持怀疑态度。下表概述了 12 项研究的方法和结果。

表1

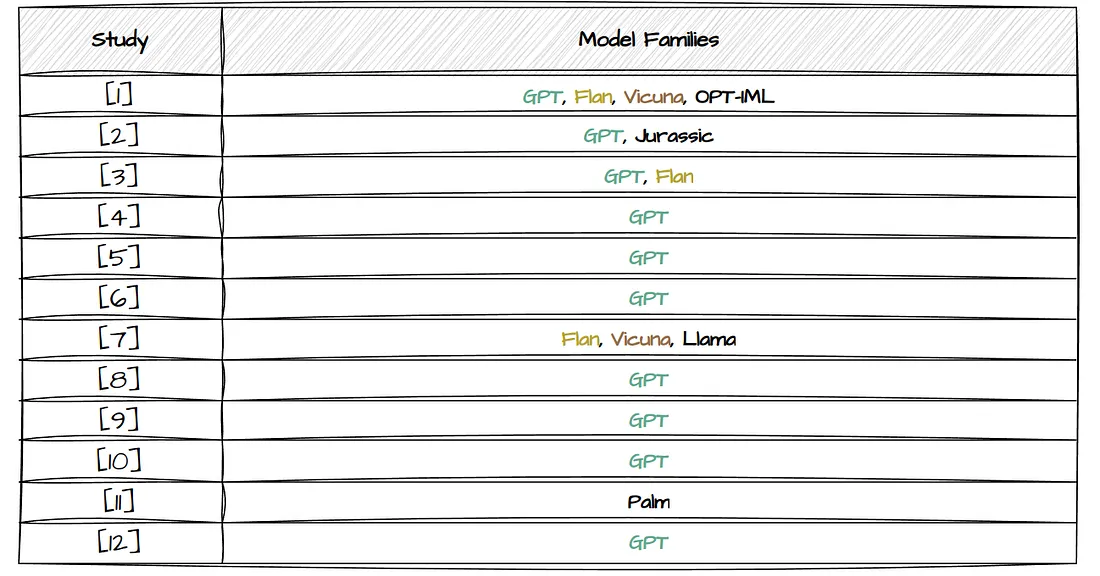

模型²

模型族的数量表明,大多数研究只测试了一个模型族,而当我们查看他们使用的模型时,我们可以发现,除了 2 项研究外,几乎所有研究都使用了 GPT。研究[7]是唯一一项只专注于探索开源 LLM 的研究。

表2

数据集

表 1 的第三列列出了用于标注的数据集数量。不同的研究探索了不同的任务,因此也探索了不同的数据集。大多数研究探讨了不止一个数据集的性能。研究[3]通过测试 20 个不同数据集的 LLM 分类性能脱颖而出。下表 3 列出了使用哪些数据集的更多细节,可以帮助你找到与你最相关的研究。

表3

如果一开始手头没有标注数据: 查看与你的使用案例类似的任务的现有标签数据集,并使用 LLM 对数据进行标注。通过详细研究错误和潜在问题,将 LLM 生成的标签与人工标签进行比较。这样,你就能知道 LLM 在你的任务中的表现如何,以及节省的时间和成本是否合理。

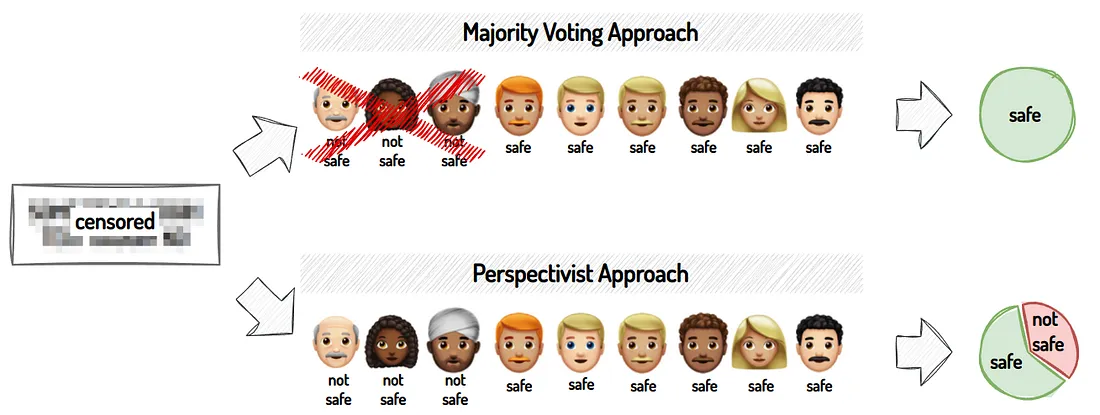

透视法

透视法简单地说就是认识到没有一种 "正确 "的方法可以理解数据集或解决问题。不同的视角可以揭示不同的见解或解决方案。传统上,大多数数据集都是采用多数投票法进行标注的,这意味着最常选择的标签被视为基本事实:

在表 1 中,根据研究采用的是多数投票还是视角思维,对贴标签方法进行了分类。我们可以看到,大多数研究都采用了多数投票法进行标注。

LLM 作为注释器?

最后一栏总结了每项研究的结果,打勾表示倾向于认为 LLM 可以在标注过程中有所帮助。有些人对 LLM 的潜力相当乐观,并建议将其取代人类注释员,而另一些人则认为 LLM 更像是一种辅助工具,而不是人类注释员的替代品。无论如何,即使在这些前景乐观的研究中,也有一些任务的 LLM 表现不够理想。

此外,有三项研究(其中两项采用的是视角主义方法)认为 LLM 不适合标记数据。另一项研究(未包含在表格中)采用了不同的方法,表明目前通过单一奖励函数对 LLMs 进行排列的方法无法捕捉到不同人类子群之间偏好的多样性,尤其是少数群体的观点。

使用LLM作为注释者时的注意事项

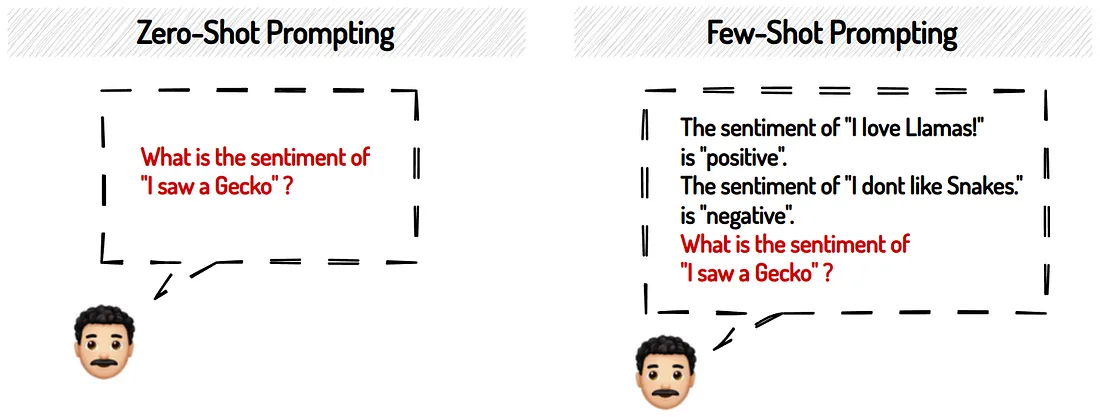

提示: 零次与少量次

从 LLM 中获得有意义的回答可能是一个挑战。那么,如何才能最好地提示 LLM 标注数据呢?从表 1 中我们可以看到,上述研究探讨了零次提示或少量提示,或者两者兼而有之。零次提示希望 LLM 在没有看到提示中的任何示例的情况下给出答案。而少量提示则在提示本身中包含多个示例,从而让 LLM 知道想要的回答是什么样的:

对于哪种方法能取得更好的效果,研究的观点不尽相同。有些人在他们的任务中采用少量提示,有些人则采用零提示。因此,你可能需要探索哪种方法最适合你的特定使用案例和模式。

提示: 敏感性

LLM 对提示语的细微修改都很敏感。改变提示中的一个单词就会影响到回答。如果你想在一定程度上考虑到这种可变性,你可以采用研究[3]中的方法。首先,他们让任务专家提供初始提示。然后,他们使用 GPT 生成另外 4 个含义相似的提示,并对所有 5 个提示的结果进行平均。或者,你也可以探索放弃手写提示,尝试用签名来代替手写提示,让 DSPy 为你优化提示,如图所示 :

模型选择

你应该选择哪种模型来标记数据集?有几个因素需要考虑。让我们简要谈谈一些关键的考虑因素:

- 开源与闭源:你是选择最新的性能最好的模型?还是开源定制对你更重要?你需要考虑的因素包括预算、性能要求、定制和所有权偏好、安全需求以及社区支持要求。

- 防护栏: LLM 设有防护栏,以防止它们响应不良或有害内容。如果你的任务涉及敏感内容,模型可能会拒绝为你的数据贴标签。此外,LLM 在防护措施的强度上也各不相同,因此应该对它们进行探索和比较,以找到最适合你的任务的 LLM。

- 模型大小: LLM 有不同的尺寸,更大的模型可能性能更好,但也需要更多的计算资源。如果你喜欢使用开源 LLM,但计算资源有限,可以考虑量化。就闭源模型而言,目前较大的模型每次提示的成本较高。但是,大就一定好吗?

模型偏差

根据研究,较大的指令调整³模型显示出更优越的标注性能。不过,该研究并未对结果中的偏差进行评估。另一项研究表明,偏差往往会随着规模和模糊语境的增加而增加。有几项研究还警告说,LLM 有左倾倾向,而且准确代表少数群体(如老年人或代表性不足的宗教)意见的能力有限。总而言之,目前的 LLM 显示出相当大的文化偏见,并对少数群体的个人观点抱有成见。根据你的任务及其目标,这些都是你在项目的每个时间线中需要考虑的问题。

模型参数: 温度

表 1 中的大多数研究都经常提到的一个参数是温度参数,它可以调整 LLM 输出的 "创造性"。研究[5]和[6]同时对较高和较低的温度进行了实验,发现在不影响准确性的情况下,较低温度下 LLM 的响应一致性更高;因此,他们建议在注释任务中使用较低的温度值。

语言限制

如表 1 所示,大多数研究都是在英语数据集上测量 LLM的标注性能。研究[7]探讨了法语、荷兰语和英语任务,发现非英语语言的性能大幅下降。目前,LLM在英语中表现较好,但也有其他方法将其优势扩展到非英语用户。

人类推理与行为(自然语言解释)

除了简单地要求 LLM 提供一个标签外,我们还可以要求它为所选标签提供一个解释。其中一项研究[10]发现,GPT 返回的解释即使不比人类的解释更清晰,也能与人类的解释相媲美。不过,卡内基梅隆大学和谷歌公司的研究人员也强调,LLM 尚不能模拟人类的决策,在选择中也不会表现出类似人类的行为。他们发现,经过指令调整的模型更无法表现出类似人类的行为,因此认为在注释过程中,不应使用 LLM 来替代人类。在此阶段,我也要提醒大家注意自然语言解释的使用。

- 对于预算有限且任务相对客观的人来说,LLM 是一个不错的选择。在主观任务中,对正确标签的看法可能会大相径庭,这时就要小心了!

- 避免使用 LLM 模拟人类推理和行为。

- 对于更关键的任务(如医疗保健),你可以使用 LLM 让人类纠正已标记的数据,从而加快标记过程;但不要让人类完全脱离标记过程!

- 严格评估你的结果是否存在偏差和其他问题,并考虑错误的代价是否值得它们可能带来的麻烦。