DeepMind推出AI事实核查工具SAFE,准确度超人类

谷歌旗下DeepMind研究团队最近发布了一项令人瞩目的新发现:一个名为“搜索增强型事实评估器”(SAFE)的人工智能系统在评估大型语言模型生成信息的准确性方面,表现甚至超越了人类事实核查员。

这篇名为《大型语言模型中的长篇事实性》的论文已在预印本服务器arXiv上发表,详细阐述了SAFE的工作机制。SAFE能够将大型语言模型生成的文本分解成一个个单独的事实,并通过谷歌搜索来确定每个陈述的准确性。

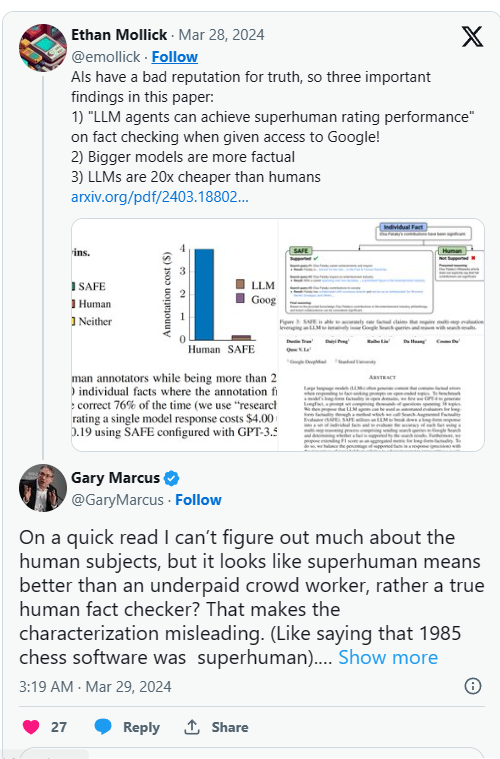

这一“超人”般的表现引起了业界的广泛讨论。研究人员在对比SAFE与16000个事实数据集中的人类标注者的评估结果时发现,SAFE与人类评分的匹配率高达72%。更值得一提的是,在SAFE与人类标注者存在分歧的100个样本中,SAFE的判断在76%的情况下被证实是正确的。

然而,对于论文中提到的“超人”表现,一些专家表达了质疑。知名人工智能研究员加里·马库斯在推特上指出,这里的“超人”可能只是相对于薪酬不高的众包工人而言,而非真正的人类事实核查员。他认为这种描述具有误导性,并强调应将SAFE与专家级的人类事实核查员进行基准测试,才能得出更准确的结论。

不过,SAFE的一个显著优势在于成本。研究人员发现,使用这种人工智能系统进行事实核查的成本比使用人类事实核查员低约20倍。随着语言模型生成的信息量不断增加,一种经济高效且可扩展的验证方式变得愈发重要。

DeepMind团队还利用SAFE评估了13个顶级语言模型在四个系列上的事实准确性,这些模型在名为LongFact的新基准上进行了测试。结果显示,较大的模型通常产生的事实错误较少。但即便如此,表现最好的模型也产生了大量虚假陈述,这凸显了过度依赖语言模型的风险,而SAFE这样的自动事实核查工具在缓解这些风险方面起着关键作用。

尽管SAFE的代码和LongFact数据集已在GitHub上开源,允许其他研究人员进行深入研究和开发,但关于研究中使用的人类基线仍需更多透明度。了解众包工人的背景和核查过程的具体细节,对于准确评估SAFE的能力至关重要。

随着科技巨头纷纷开发更强大的语言模型,用于搜索、虚拟助手等各种应用,自动核实这些系统输出的能力变得尤为重要。SAFE等工具代表了在建立信任和问责制方面迈出的重要一步。