Nvidia推出搭载16颗GPU的HGX-2,加速人工智能训练

2018年05月30日 由 浅浅 发表

649924

0

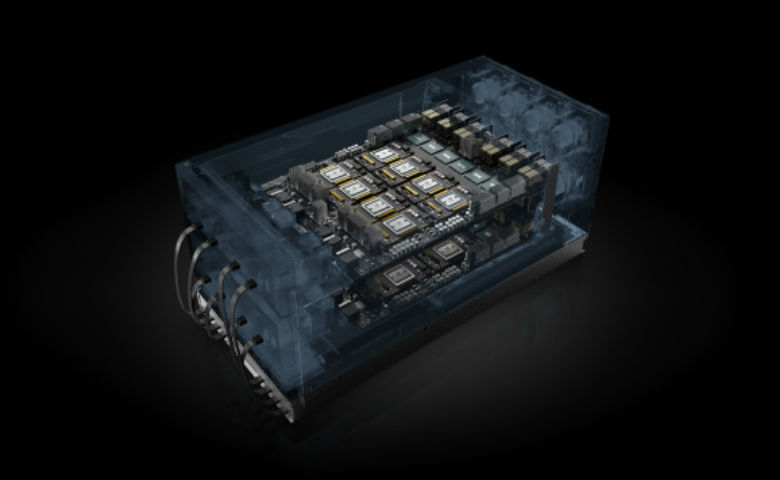

Nvidia今天推出了搭载16颗Tesla V100图形处理单元(GPU)芯片的云服务器平台HGX-2,提供了半个TB的GPU内存和两千万亿次的计算能力。GPU通过使用NVSwitch互连共同作用。HGX-2主板可处理训练AI模型和高性能计算。

HGX-2已经实现了Nvidia认为是破纪录的AI训练速度。根据Nvidia的声明,GPU服务器可以在ResNet-50训练基准测试中每秒处理15,500个图像,并且能够替换多达300个仅限CPU的服务器。

联想等服务器厂商和富士康等制造商计划在今年晚些时候将基于HGX-2的系统推向市场。今天Nvidia在GTC台湾活动上宣布了这一消息。

第一个使用HGX-2制造的系统是DGX-2,它于3月份在GTC首次亮相。当时,该公司报告说,深度学习计算平台的硬件和软件改进使得六个月内深度学习工作负载的性能提高了10倍。

随着企业,研究人员和其他人员增加对AI解决方案的使用,用于训练显着神经网络的计算能力也在不断增加。最近的OpenAI研究发现,自2012年以来,培训知名系统所需的计算能力每3.5个月翻一番。像Nvidia这样的GPU越来越多地用于训练和部署像照片和视频这样的未标记数据。

“在计算需求猛增的时候,CPU规模变化却放缓了,”首席执行官Jensen Huang表示。“配备Tensor核心GPU的NVIDIA HGX-2为业界提供了一个强大的多功能计算平台,融合了HPC和AI,以解决全球的巨大挑战。”

此外,Nvidia还推出了不同类别的服务器,将GPU加速服务器映射到不同的特定工作负载,其中包括用于AI培训的HGX-T,用于推理的HGX-I以及用于超级计算服务器的SCX。每种GPU都有不同的GPU和CPU比率组合,以优化特定任务的性能。

HGX-2的推出是继去年发布的HGX-1之后推出的,该产品由八颗GPU驱动。HGX-1参考架构已被用于GPU服务器,如Facebook的Big Basin和微软的Project Olympus。

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消