本地运行Llama 3模型:详细指南

Meta已经发布了其开放权重大型语言模型家族中的最新一代——Llama 3。目前,它提供了8B和70B两种参数大小的版本,同时提供了预训练和指令调优两种选择。

其中,指令调优版本是专门针对聊天/对话用例进行微调的,而预训练版本则是基础模型。请注意,8B参数模型大约占用4GB的存储空间,而70B版本则大约占用40GB。

在本文中,我们将为您提供一个详细的指南,帮助您在本地运行这些模型。

选项一:使用Ollama

支持平台:MacOS、Ubuntu、Windows(预览版)

Ollama是让您在本地运行Llama 3的最简单方法之一。您只需在此处下载应用程序,然后在命令行界面(CLI)中运行以下命令之一。

ollama run llama3这将会下载Llama 3的8B指令模型。

您可以选择性地提供一个标签,但如果不提供,则会默认为最新版本。标签用于标识特定版本。例如,您可以运行:

ollama run llama3:70b-textollama run llama3:70b-instruct恭喜,您现在可以通过CLI访问该模型了。

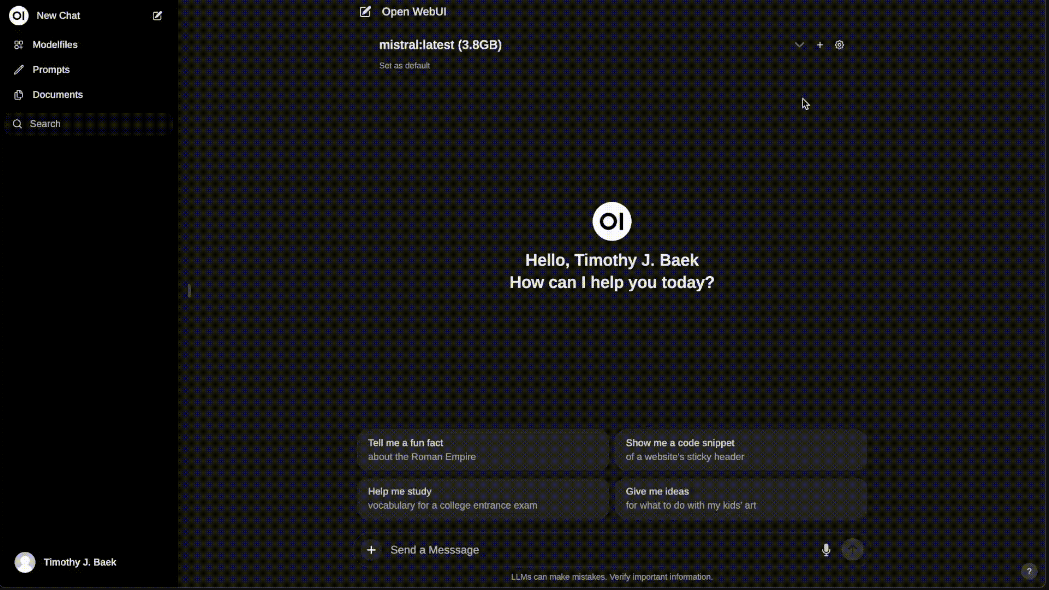

如果您想要一个类似ChatGPT的聊天机器人用户界面,那么您需要做更多的工作。一个不错的选择是Open WebUI项目:

您可以在此处下载OpenWebUI(前称Ollama WebUI)。它是一个功能丰富且友好的自托管Web UI。我建议您使用Docker,并使用以下命令设置容器:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main安装完成后,您可以访问Open WebUI。

注意:您还可以查看Chatbot Ollama或Chatbot UI。

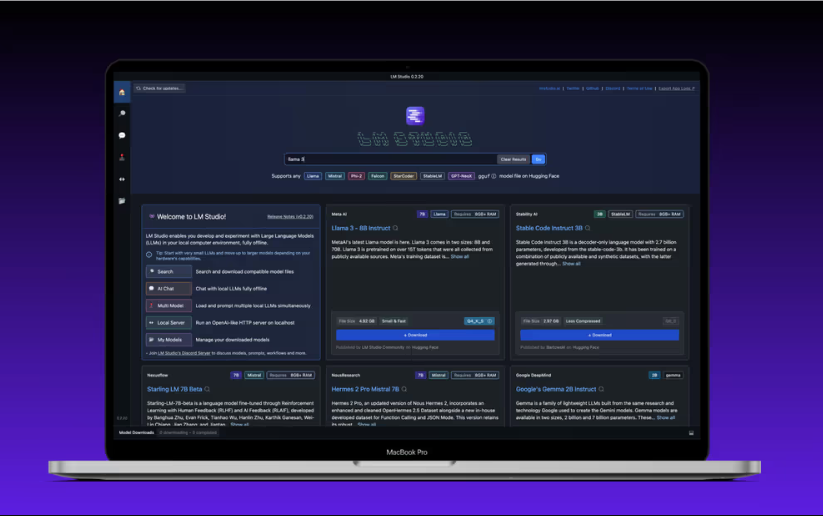

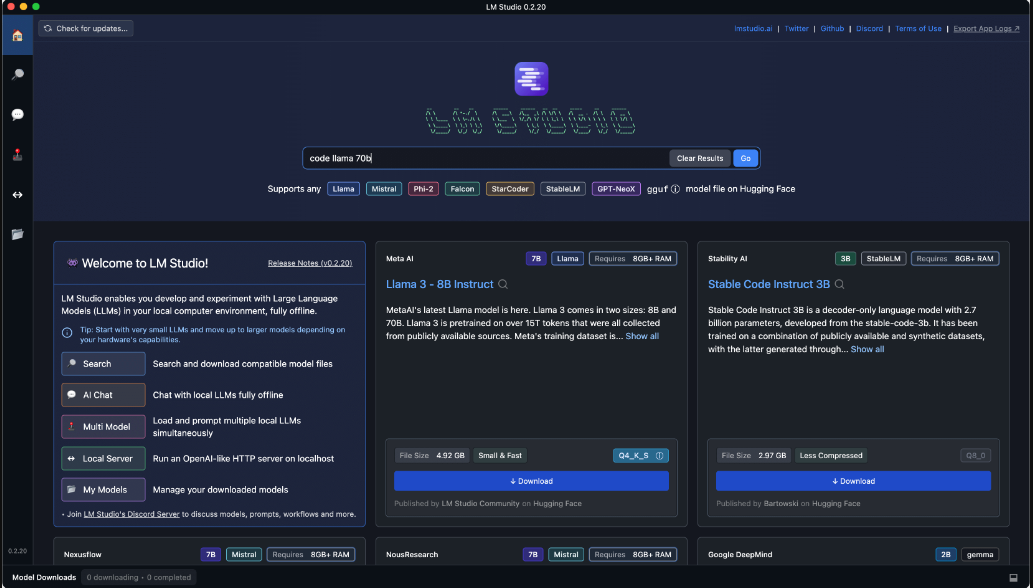

选项二:使用LM Studio

支持平台:MacOS、Ubuntu、Windows

LM Studio得以实现要归功于llama.cpp项目,并支持Hugging Face上的任何ggml Llama、MPT和StarCoder模型。您可以在此处下载应用程序,并留意系统要求。

注意:LM Studio内置了聊天界面和其他功能。

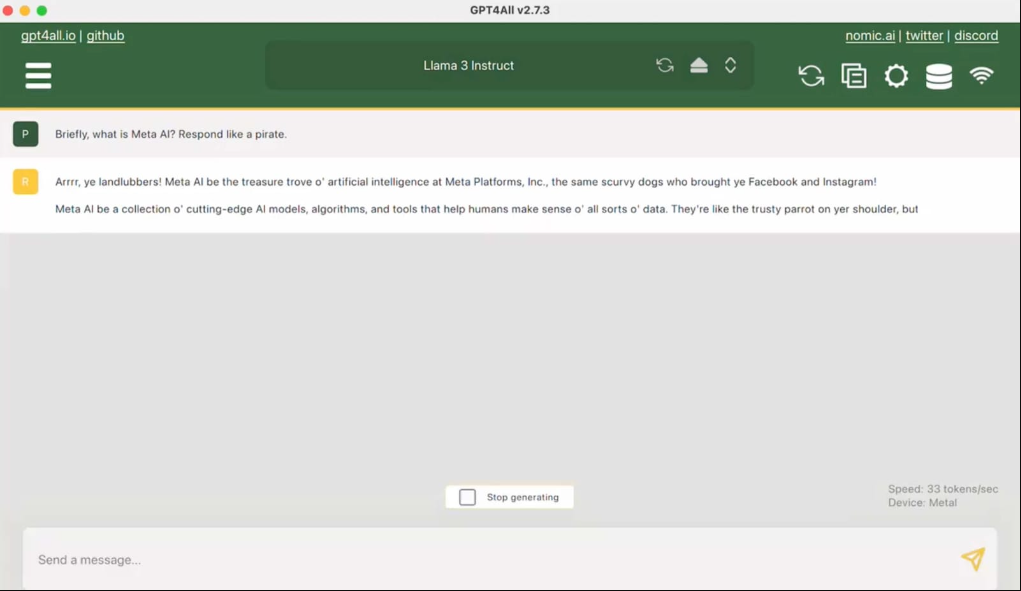

选项三:GPT4All

支持平台:MacOS、Ubuntu、Windows

您只需下载应用程序并按照常规方式安装即可。

希望这份指南能帮助您在本地成功运行Llama 3模型,享受人工智能带来的便利和乐趣。