模型:

microsoft/xclip-large-patch14-kinetics-600

英文

英文X-CLIP(大型模型)

X-CLIP模型(大型,修补分辨率为14)在 Kinetics-600 上进行了全监督训练。它是由Ni等人在 this repository 中首次发布的。

该模型使用每个视频的8帧,在224x224的分辨率下进行训练。

免责声明:发布X-CLIP的团队并未为该模型编写模型卡片,因此该模型卡片是由Hugging Face团队编写的。

模型描述

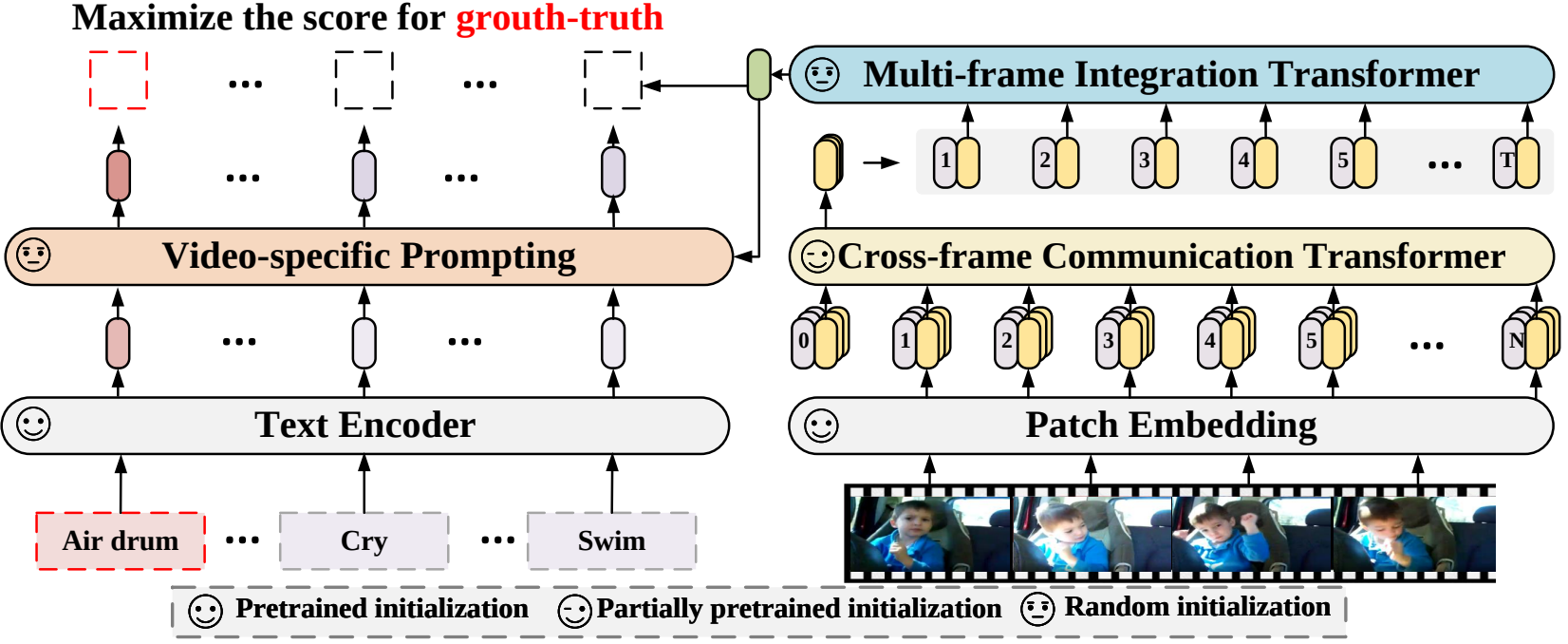

X-CLIP是 CLIP 对于视频语言理解的最小扩展。该模型按对比方式训练(视频、文本)对。

这使得该模型可以用于零样本、少样本或全监督视频分类和视频文本检索等任务。

预期用途和限制

您可以使用原始模型来确定文本与给定视频的配合程度。请参阅 model hub 以查找您感兴趣的任务的微调版本。

使用方法

有关代码示例,请参阅 documentation 。

训练数据

该模型是在 Kinetics-600 上训练的。

预处理

有关训练期间预处理的详细信息,请参见 here 。

有关验证期间预处理的详细信息,请参见 here 。

在验证期间,将调整每个帧的较短边,然后进行中心裁剪以达到固定的分辨率(如224x224)。然后,使用ImageNet的均值和标准差对帧在RGB通道上进行归一化。

评估结果

该模型的 top-1 准确率为88.3%,top-5 准确率为97.7%。