模型:

microsoft/wavlm-base

英文

英文WavLM-Base

在16kHz采样的语音音频上进行预训练的基础模型。在使用该模型时,请确保您的语音输入也以16kHz进行采样。

注意:该模型没有标记器,因为它是仅在音频上进行预训练的。为了使用该模型进行语音识别,需要创建一个标记器,并对标注文本数据对模型进行微调。有关如何微调该模型的更详细解释,请参阅 this blog 。

模型是在960小时的语音数据上进行预训练的。

Paper: WavLM: Large-Scale Self-Supervised Pre-Training for Full Stack Speech Processing

作者:Sanyuan Chen,Chengyi Wang,Zhengyang Chen,Yu Wu,Shujie Liu,Zhuo Chen,Jinyu Li,Naoyuki Kanda,Takuya Yoshioka,Xiong Xiao,Jian Wu,Long Zhou,Shuo Ren,Yanmin Qian,Yao Qian,Jian Wu,Michael Zeng,Furu Wei

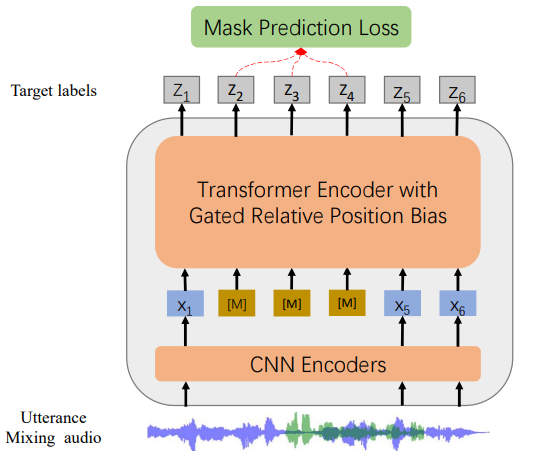

摘要:自监督学习(SSL)在语音识别方面取得了巨大成功,但在其他语音处理任务上的探索还有限。由于语音信号包含许多信息,包括说话人身份、语用学、说话内容等,为所有语音任务学习通用表示是具有挑战性的。在本文中,我们提出了一种新的预训练模型WavLM,用于解决全套下游语音任务。WavLM基于HuBERT框架构建,注重口语内容建模和说话人身份保留。我们首先使用门控相对位置偏差来改进Transformer结构在识别任务上的能力。为了更好地进行说话人区分,我们提出了一种音素混合训练策略,其中无监督地创建额外的重叠话语,并在模型训练过程中加入。最后,我们将训练数据集从60k小时扩大到94k小时。WavLM Large在SUPERB基准测试上取得了最先进的性能,并显著改进了各种语音处理任务在其代表性基准上的表现。

原始模型可在 https://github.com/microsoft/unilm/tree/master/wavlm 找到。

用法

这是一个需要在语音识别或音频分类等下游任务上进行微调后才能进行推理的英文预训练语音模型。该模型在英文上进行了预训练,因此只有在英文方面表现良好。该模型在 SUPERB benchmark 上已经被证明效果良好。

注意:该模型是基于音素而不是字符进行预训练的。这意味着在进行微调之前,应确保将输入文本转换为音素序列。

语音识别

要将模型微调为语音识别,请参阅 the official speech recognition example 。

语音分类

要将模型微调为语音分类,请参阅 the official audio classification example 。

说话人验证

待办事项

说话人分割

待办事项

贡献

模型由 cywang 和 patrickvonplaten 贡献。

许可证

官方许可证可在 here 找到