英文

英文WavLM-Base-Plus

该基础模型是在16kHz采样的语音音频上进行预训练的。在使用模型时,请确保您的语音输入也是以16kHz采样的。

注意:该模型没有tokenizer,因为它只是在音频上进行了预训练。为了使用该模型进行语音识别,需要创建一个tokenizer,并对带标签的文本数据对模型进行微调。有关如何微调模型的更详细解释,请查看 this blog 。

该模型的预训练内容包括:

- 60,000小时的 Libri-Light

- 10,000小时的 GigaSpeech

- 24,000小时的 VoxPopuli

Paper: WavLM: Large-Scale Self-Supervised Pre-Training for Full Stack Speech Processing

作者:Sanyuan Chen,Chengyi Wang,Zhengyang Chen,Yu Wu,Shujie Liu,Zhuo Chen,Jinyu Li,Naoyuki Kanda,Takuya Yoshioka,Xiong Xiao,Jian Wu,Long Zhou,Shuo Ren,Yanmin Qian,Yao Qian,Jian Wu,Michael Zeng,Furu Wei

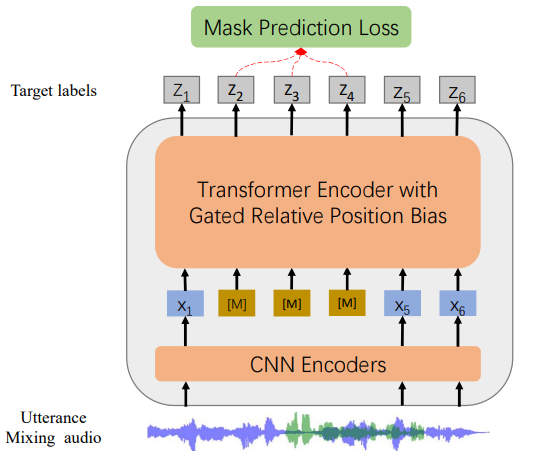

摘要:自监督学习(SSL)在语音识别方面取得了巨大的成功,但在其他语音处理任务上的探索有限。由于语音信号包含有关说话人身份、语音语调、内容等多方面信息,因此学习适用于所有语音任务的通用表示是具有挑战性的。本文提出了一种新的预训练模型WavLM,用于解决全栈下游语音任务。WavLM基于HuBERT框架构建,旨在同时进行口语内容建模和说话人身份保留。我们首先使用门控相对位置偏差改进Transformer结构的识别任务能力。为了更好地区分说话人,我们提出了一种语句混合训练策略,即在模型训练过程中无监督地创建附加的重叠语句并加以合并。最后,我们将训练数据集从60k小时扩大到94k小时。WavLM Large在SUPERB基准测试中取得了最先进的性能,并在各种语音处理任务的代表性基准测试中带来了显著的改进。

原始模型可以在 https://github.com/microsoft/unilm/tree/master/wavlm 中找到。

用法

这是一个英文预训练的语音模型,在可以用于推断之前,需要在语音识别或音频分类等下游任务上对其进行微调。该模型是在英语上进行预训练的,因此只能在英语上表现良好。该模型在 SUPERB benchmark 上表现良好。

注意:该模型是基于音素而不是字符进行预训练的。这意味着在微调之前,应确保将输入文本转换为一系列音素。

语音识别

要对该模型进行语音识别的微调,请参阅 the official speech recognition example 。

语音分类

要对该模型进行语音分类的微调,请参阅 the official audio classification example 。

说话人验证

待定

说话人分离

待定

贡献

该模型由 cywang 和 patrickvonplaten 贡献。

许可证

官方许可证可在 here 找到