模型:

facebook/data2vec-audio-base

英文

英文Data2Vec-Audio-Base

在16kHz采样率的语音音频上预训练的基础模型。在使用该模型时,请确保您的语音输入也以16kHz进行采样。

注意:该模型没有分词器,因为它是仅在音频上预训练的。为了使用该模型进行语音识别,需要创建一个分词器,并且在带标签的文本数据上对模型进行微调。更详细的说明,请参阅 this blog 。

作者:Alexei Baevski,Wei-Ning Hsu,Qiantong Xu,Arun Babu,Jiatao Gu,Michael Auli

摘要

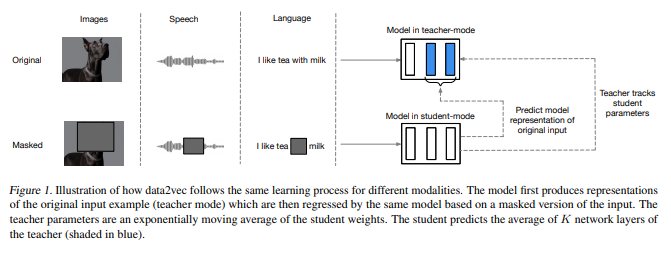

尽管跨模态自监督学习的一般思想是相同的,但实际算法和目标因为它们是为单一模态而开发的而差异很大。为了让我们更接近通用的自监督学习,我们提出了data2vec,这是一个框架,它对语音、自然语言处理或计算机视觉使用相同的学习方法。其核心思想是使用标准Transformer架构,在自蒸馏设置中,基于输入的屏蔽视图来预测完整输入数据的潜在表示。data2vec不是预测局部性质的模态特定目标,如单词、视觉标记或人类语音单元,而是预测包含来自整个输入的信息的情境化潜在表示。对语音识别、图像分类和自然语言理解的主要基准进行的实验表明,它表现出新的最先进或竞争性能。

原始模型可在 https://github.com/pytorch/fairseq/tree/main/examples/data2vec 处找到。

预训练方法

有关更多信息,请查看 official paper 。

用法

有关如何对该模型进行微调的更多信息,请参阅 this notebook 。