数据集:

Open-Orca/OpenOrca

英文

英文🐋 OpenOrca数据集! 🐋

我们很高兴地宣布发布了OpenOrca数据集!这个丰富的增强FLAN数据集尽可能地与Orca论文中概述的分布相匹配。它在生成高性能模型检查点方面起到了关键作用,是所有自然语言处理研究人员和开发人员的宝贵资源!

预览模型发布

我们现在发布了我们的第一个模型预览!这个模型在不到一天的时间内以小于200美元的成本、小于10%的数据量进行了训练。它在BigBench-Hard和AGIEval上击败了当前最先进的模型,并达到了Orca论文报告的改进的约60%。

数据集概述

OpenOrca数据集是一个增强的数据集的集合。目前包括约100万个GPT-4完成和约320万个GPT-3.5完成。它根据ORCA论文中呈现的分布进行表格化,并且目前表示了完整数据集的部分完成情况,正在进行进一步的生成以扩大其范围。该数据主要用于自然语言处理领域的训练和评估。

数据集归属

我们要特别感谢以下贡献者的重要努力和奉献:

Teknium WingLian/Caseus Eric Hartford NanoBit Pankaj Winddude Rohan http://AlignmentLab.ai: Autometa Entropi AtlasUnified NeverendingToast NanoBit WingLian/Caseus

当然,我们要永远感谢TheBloke,他是整个社区的支柱。

非常感谢NanoBit和Caseus的制作方,他们是开发和训练像Manticore、Minotaur和其他许多模型的平台专家!

我们欢迎赞助商或合作伙伴加入我们,帮助我们将这些模型建设到应有的规模。请通过我们的社交媒体与我们联系: http://Alignmentlab.ai https://discord.gg/n9hXaBPWxx

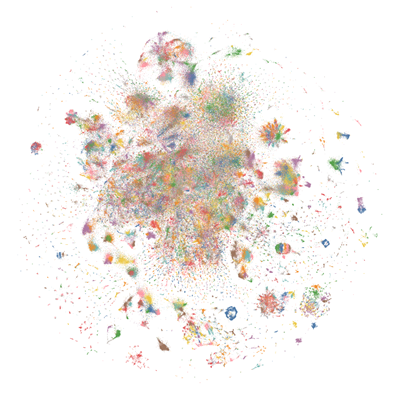

想要可视化我们的完整数据集吗?请查看我们的

Nomic Atlas Map

。

支持的任务和排行榜

该数据集支持多种任务,包括语言建模、文本生成和文本增强。它在生成多个高性能模型检查点方面发挥了关键作用,这些模型在我们的单元测试中表现出色。有关排行榜的更多信息将在更新时添加。

语言

数据主要使用英语。

数据集结构

数据实例

数据集中的数据实例表示通过向GPT-4或GPT-3.5提交列出的问题并进行增强的FLAN集合条目。然后将响应输入到响应字段中。

数据字段

字段包括:

数据拆分

数据未拆分。

数据集创建

策划原因

创建该数据集是为研究人员和开发人员提供增强文本数据的源头。数据点的主要目的是提供对GPT-3.5和GPT-4的详细逐步推理能力的FLAN集合数据的增强。这种"推理追踪"增强已经取得了出色的结果,使得使用这些数据训练的LLaMA-13B模型可以在广泛的艰难推理任务上与GPT-3.5相匹敌或超越,而在100B参数以下的所有模型上之前表现得更差。

源数据

该数据使用与Orca论文中概述的分布一致的技术生成,除非下面另有说明:

综合起来,这比原始Orca论文中的数据点少了约150万个。完成这个集合是持续进行的工作。

数据集用途

用途

该数据集可用于与语言理解、自然语言处理、机器学习模型训练和模型性能评估相关的任务。

使用注意事项

鉴于这是一个正在进行的数据集,建议定期检查更新和改进。此外,应根据Orca论文中的指导方针和建议来使用数据。

入门指南

这个数据集的组织方式使得可以通过Hugging Face数据集库简便地加载。由于文件的大尺寸,我们建议使用流式加载。可以通过HuggingFace上的OpenOrca存储库监控定期的更新和数据生成进展。

引用

@misc{OpenOrca,

title = {OpenOrca: An Open Dataset of GPT Augmented FLAN Reasoning Traces},

author = {Wing Lian and Bleys Goodson and Eugene Pentland and Austin Cook and Chanvichet Vong and "Teknium"},

year = {2023},

publisher = {HuggingFace},

journal = {HuggingFace repository},

howpublished = {\url{https://https://huggingface.co/Open-Orca/OpenOrca},

}

@misc{mukherjee2023orca,

title={Orca: Progressive Learning from Complex Explanation Traces of GPT-4},

author={Subhabrata Mukherjee and Arindam Mitra and Ganesh Jawahar and Sahaj Agarwal and Hamid Palangi and Ahmed Awadallah},

year={2023},

eprint={2306.02707},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

@misc{longpre2023flan,

title={The Flan Collection: Designing Data and Methods for Effective Instruction Tuning},

author={Shayne Longpre and Le Hou and Tu Vu and Albert Webson and Hyung Won Chung and Yi Tay and Denny Zhou and Quoc V. Le and Barret Zoph and Jason Wei and Adam Roberts},

year={2023},

eprint={2301.13688},

archivePrefix={arXiv},

primaryClass={cs.AI}

}

@software{touvron2023llama,

title={LLaMA: Open and Efficient Foundation Language Models},

author={Touvron, Hugo and Lavril, Thibaut and Izacard, Gautier and Martinet, Xavier and Lachaux, Marie-Anne and Lacroix, Timoth{\'e}e and Rozi{\`e}re, Baptiste and Goyal, Naman and Hambro, Eric and Azhar, Faisal and Rodriguez, Aurelien and Joulin, Armand and Grave, Edouard and Lample, Guillaume},

journal={arXiv preprint arXiv:2302.13971},

year={2023}

}