OpenAI 又推出了一个新的编码模型,而且这次速度非常快

OpenAI 发布了 GPT-5.3-Codex-Spark,这是其为实时编程打造的 GPT-5.3 Codex 编码模型的小型版本。它运行在 Cerebras 芯片上,每秒处理超过 1,000 个令牌。

Codex-Spark 是 OpenAI 于一月宣布的 Cerebras 合作项目中推出的首款产品。该模型运行在Cerebras的Wafer Scale Engine 3上,这是一款专为快速推断设计的人工智能加速器。

研究预览现已向ChatGPT Pro用户提供,可通过Codex应用、CLI和VS Code扩展访问。OpenAI表示计划在未来几周内扩大访问权限。由于该模型运行在专用硬件上,公司表示会有独立的速率限制,并在需求高峰期可能会进行调整。

Codex-Spark优先考虑速度而非自主性

OpenAI的大型前沿模型,如新发布的Codex 5.3,设计为能够自主工作数分钟或数小时,完成复杂的编程任务。Codex-Spark采取了不同的方法:OpenAI表示,该模型针对交互式工作进行了优化,延迟与智能同等重要。开发者可以实时中断和重定向模型,并立即看到结果。

根据OpenAI,Codex-Spark在运营方式上刻意采取了保守态度。相比大型型号,它默认做的改动很少,且只有在你明确要求的情况下不会启动自动测试。该模型有一个128k上下文窗口,只处理文本。

准确率下降,时间也有所下降

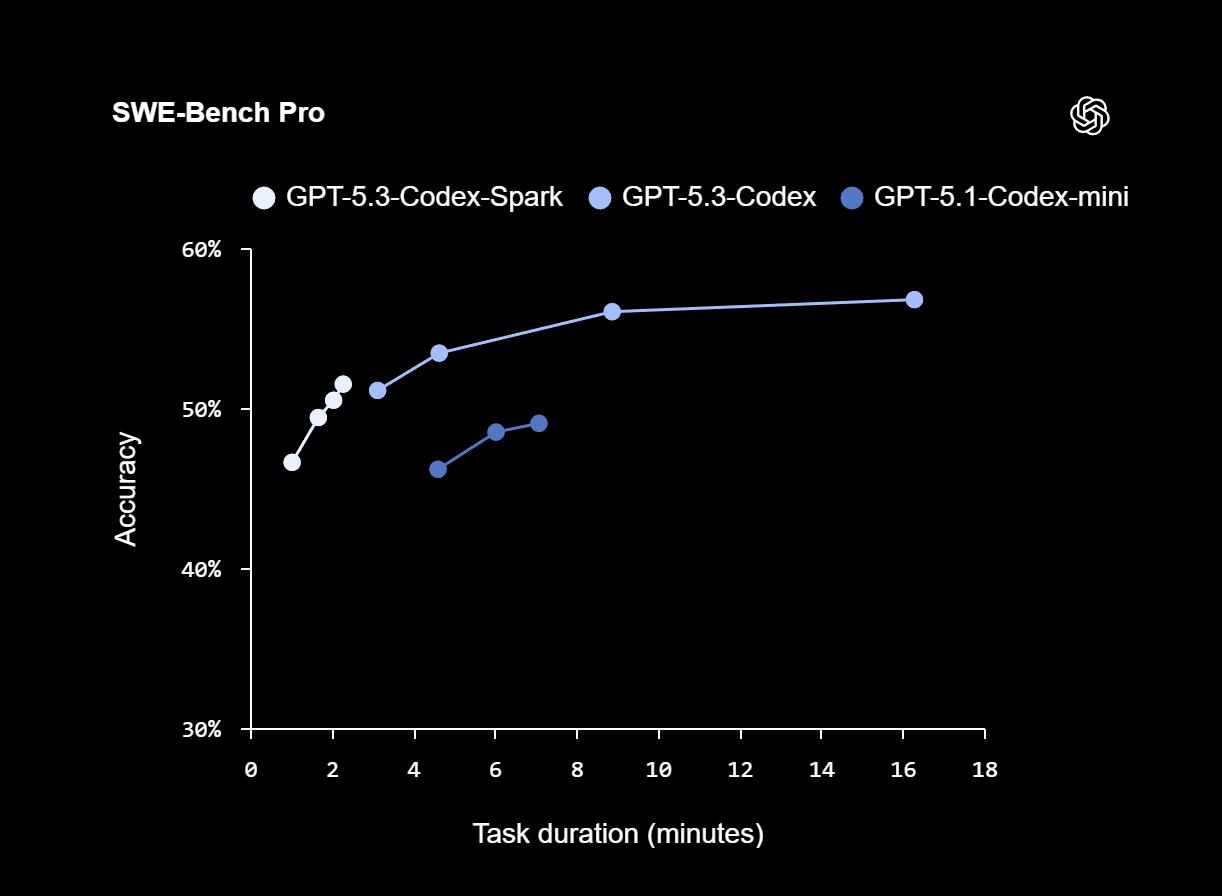

OpenAI表示,Codex-Spark在SWE-Bench Pro和Terminal-Bench 2.0基准测试中取得了强劲成绩,这些基准测试评估了基于代理的软件工程能力,但完成任务的时间远低于GPT-5.3-Codex。在SWE-Bench Pro上,Codex-Spark大约两到三分钟就能达到类似的精度,而GPT-5.3-Codex完成同样的任务大约需要15到17分钟。

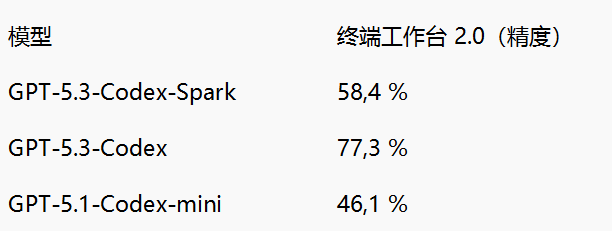

在终端工作台2.0中,Codex-Spark的准确率为58.4%。较大的GPT-5.3-Codex达到77.3%,而较旧的GPT-5.1-Codex-mini则为46.1%。两款较小的型号都用速度牺牲了精准度。

构建Codex-Spark迫使OpenAI不仅加快了模型本身的速度。为了达到延迟目标,公司重写了推理堆栈的关键部分,优化了客户端与服务器之间的响应流,并重新设计了会话启动,使第一个令牌更快显示。结果是:每次往返开销下降了80%,每个代币开销下降了30%,首个代币的时间缩短了一半,OpenAI表示。这些改进默认适用于Codex-Spark,并将很快推广到所有型号。

OpenAI 希望未来将实时模式和推理模式合并

OpenAI表示,Codex-Spark是计划中的“超快”模型家族中的首个型号。更多功能即将到来,包括更大的模型、更长的上下文窗口以及多模态输入支持。

从长远来看,公司正致力于为Codex提供两种互补模式:一种用于扩展推理和自主执行,另一种用于实时协作。OpenAI表示计划随着时间推移合并这些模式,保持开发者处于快速互动循环中,同时将较长任务在后台交给子代理,或将任务分散到多个并行运行的模型中。