Qwen-Image-2.0 几乎能以完美的文字准确度渲染古代中国书法和幻灯片

阿里巴巴的Qwen团队发布了Qwen-Image-2.0,一款紧凑型图像模型,既能处理创建,也能进行编辑。其突出特点是几乎无瑕的文字表现,包括复杂的中文书法。

阿里巴巴Qwen团队发布了Qwen-Image-2.0。该模型拥有70亿参数和原生2K分辨率(2048 x 2048),可以从文本描述生成图像并编辑现有描述——这些任务以前需要两个独立模型。前代版本参数数达到200亿,使新版本的规模约为其三分之一。据Qwen团队介绍,经过数月时间将原本分开的开发路径合并,使这次“缩小”成为可能。

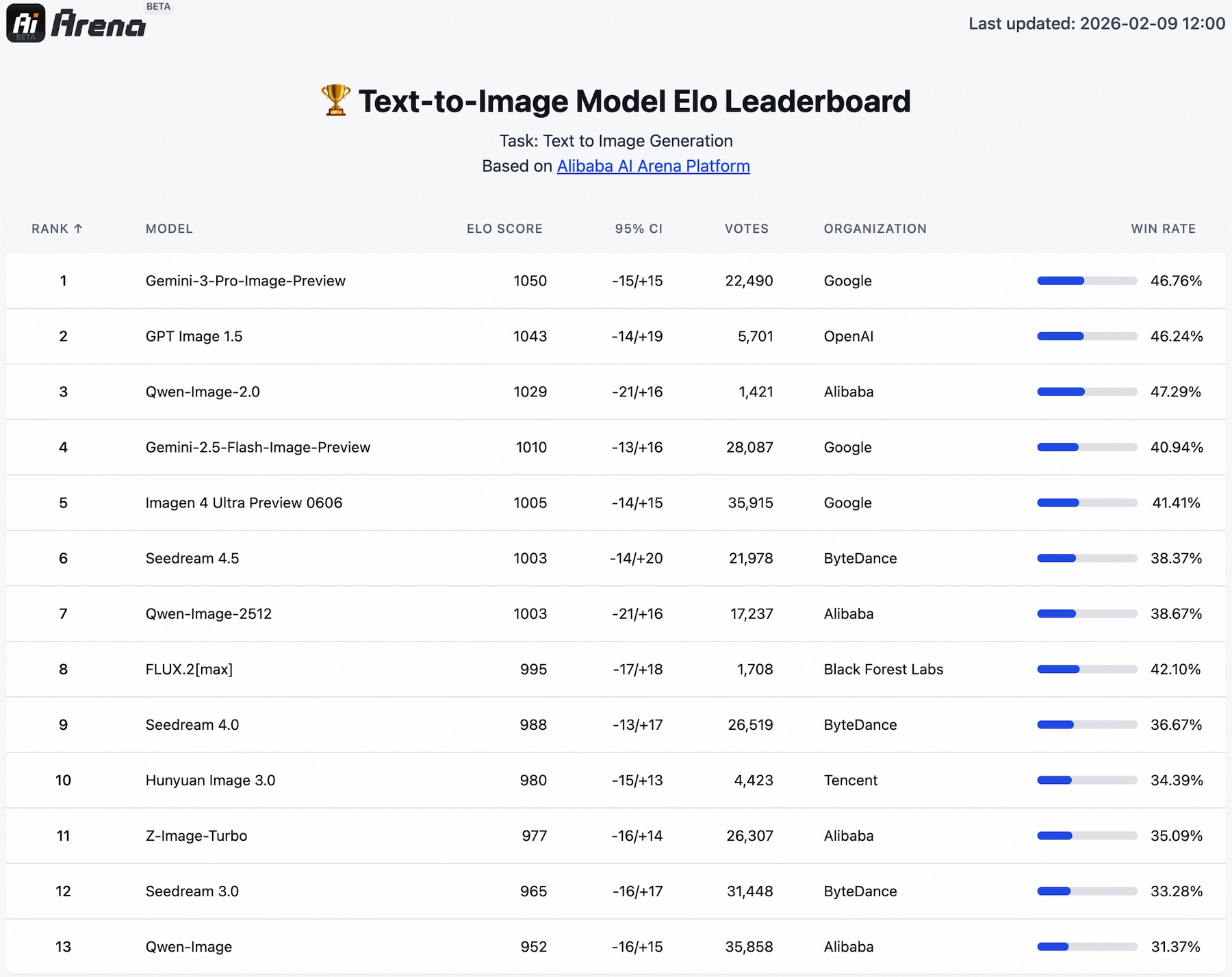

在自家Arena平台的盲测中,阿里表示该模型在文本到图像和图像到图像任务中均领先竞争对手,尽管它是一个统一模型,面对的是专门系统。它排名第三,仅次于OpenAI的GPT-Image-1.5和谷歌的Nano Banana Pro。在图像编辑比较中,Qwen-Image-2.0位居第二,位列Nano Banana Pro和字节跳动的Seedream 4.5之间。

生成图像中的近乎完美的文本

Qwen-Image-2.0最令人印象深刻的技巧是将文本渲染到生成的图像内部。Qwen团队指出五大核心优势:精准、复杂、美观、真实性和对齐性。

该模型支持最多1000个代币的提示。Qwen团队表示,这足以一次性生成信息图、演示幻灯片、海报,甚至多页漫画。在一个演示中,模型生成了一个带有时间线的PowerPoint幻灯片,精准处理所有文本并在幻灯片中渲染嵌入的图像;这是一种“画中画”的构图。

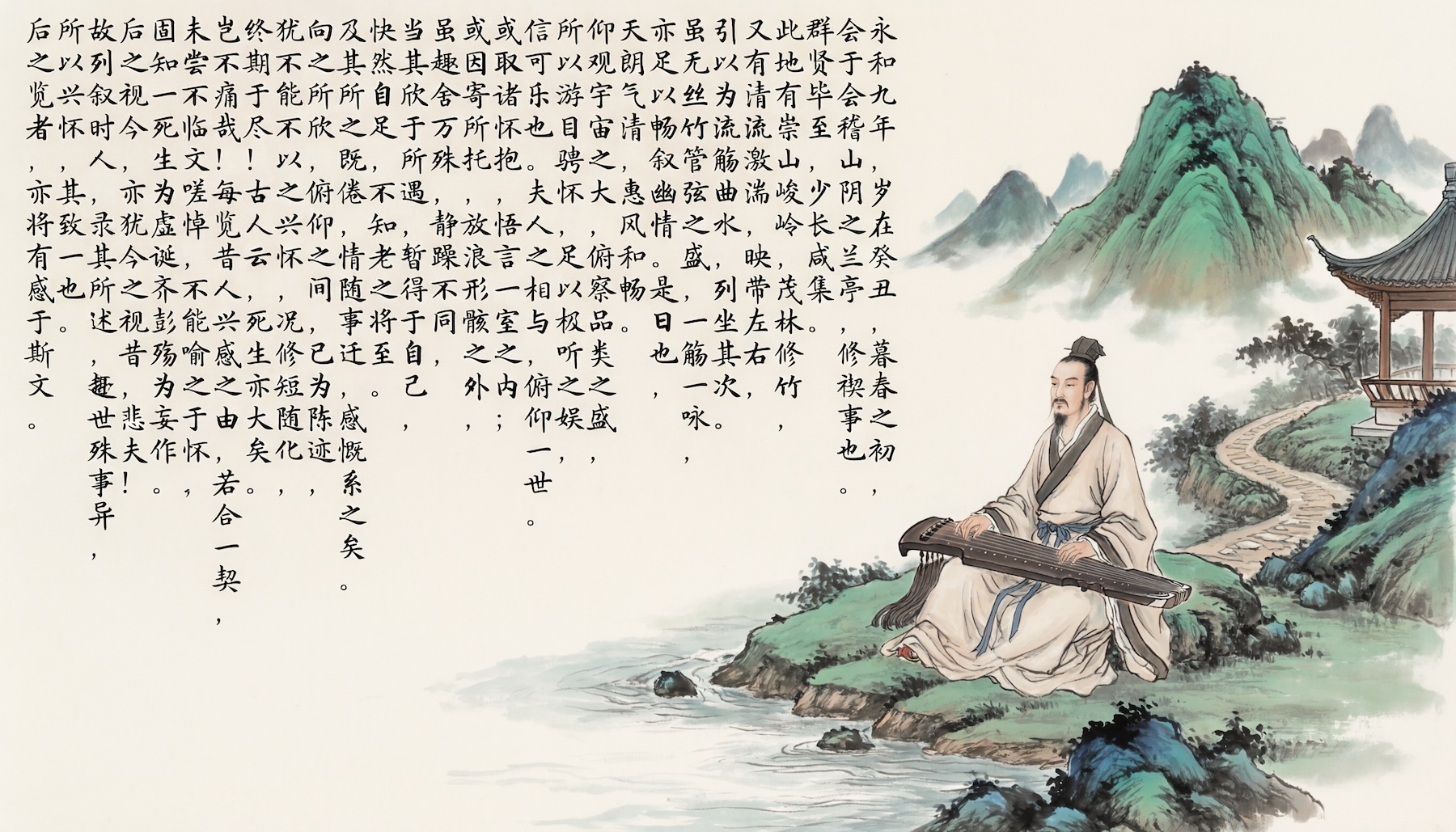

书法群体尤其雄心勃勃。据称Qwen-Image-2.0能够处理多种中文书写风格,包括宋代惠宗皇帝的“细金体”和标准文字。例如,团队表示该模型几乎用标准体将《兰阁诗序》全文都用标准体呈现,只有少数错误字符。

模型还能在不同表面——玻璃白板、服装、杂志封面——配合合适的光线、反射和透视处理文字。一个电影海报示例展示了写实场景和密集排版在单一图像中协同作用。

除了文字,Qwen-Image-2.0在纯视觉任务中展现了明显的提升。Qwen团队演示了一个森林场景,模型区分了23种绿色调,具有鲜明的质感,从蜡质叶面到天鹅绒苔藓垫。

由于生成和编辑共享同一模型,生成层的改进直接提升了编辑质量。模特可以在现有照片上叠加诗歌,从一张肖像中创造九格不同姿势,或将两张不同照片中的人物合并成自然的合影。跨维度编辑也很有效,比如把卡通人物放进真实城市照片里。

开放式重量很可能会推出

Qwen-Image-2.0目前仅通过API在阿里云上作为邀请限定测试版和Qwen Chat的免费演示提供。开放模型的权重还没下降。

话虽如此,Reddit上的LocalLLaMA社区对该模式表现出浓厚兴趣。7B尺寸对于希望在消费级硬件上本地运行模型的用户来说最为重要。封闭式配重似乎没人感到惊讶。在Qwen-Image的第一个版本发布时,团队在发布后大约一个月便以Apache 2.0许可证发布了重量。大多数用户这次都期待同样的战术手册。关于建筑的论文也仍在等待中。

Qwen-Image-2.0符合中国图像模型中越来越注重精准文本渲染的更广泛趋势。12月,美团发布了60亿参数的LongCat-Image,随后1月发布了拥有160亿参数的智慧AI和MIT许可的GLM-Image。