美团正式开源 LongCat-Image 模型:编辑能力登顶开源 SOTA

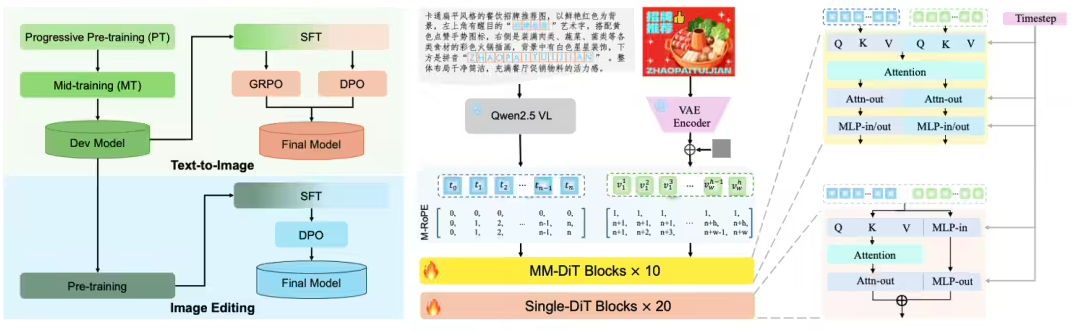

今日,美团 LongCat 团队正式发布并开源图像生成模型 LongCat-Image 模型,通过高性能模型架构设计、系统性的训练策略和数据工程,以 6B 参数规模,成功在文生图和图像编辑的核心能力维度上逼近更大尺寸模型效果。

LongCat-Image 采用文生图与图像编辑同源的架构设计,并结合渐进式学习策略,在仅 6B 的紧凑参数规模下,实现了指令遵循精准度、生图质量与文字渲染能力的高效协同提升。尤其在单图编辑的可控性和文字生成的汉字覆盖度方面独具优势。

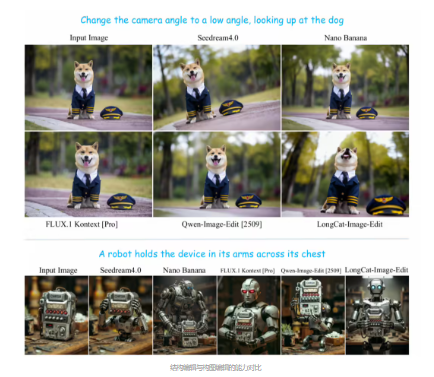

亮点一:图像编辑高度可控

LongCat-Image 在图像编辑领域的多个重要基准测试中(如 GEdit-Bench、ImgEdit-Bench)均达到开源 SOTA 水平,实现性能突破的背后在于一套紧密协同的训练范式和数据策略。为有效继承文生图模型的知识和美感,同时避免文生图后训练阶段收窄的状态空间对编辑指令多样性的限制,基于文生图 Mid-training 阶段模型进行初始化,并采用指令编辑与文生图多任务联合学习机制,深化对复杂多样化指令的理解。此外通过预训练阶段的多源数据及指令改写策略,以及 SFT 阶段引入人工精标数据,最终实现了指令遵循精准度、泛化性和编辑前后视觉一致性的共同提升。

亮点二:中文文字生成精准覆盖

针对中文文本渲染这一行业痛点,LongCat-Image 通过课程学习策略来提升字符覆盖度和渲染精准度:预训练阶段基于千万量级合成数据学习字形,覆盖通用规范汉字表的 8105 个汉字;SFT 阶段引入真实世界文本图像数据,提升在字体、排版布局上的泛化能力;RL 阶段融入 OCR 与美学双奖励模型,进一步提升文本准确性与背景融合自然度。此外通过对 prompt 中指定渲染的文本采用字符级编码,大幅降低模型记忆负担,实现文字生成学习效率的跨越式提升。通过该项能力加持,有效支持海报设计、商业广告作图场景中复杂笔画结构汉字的渲染,以及古诗词插图、对联、门店招牌、文字 Logo 等设计场景的生僻字渲染。

此外,LongCat-Image 通过系统性的数据筛选与对抗训练框架,实现了出图纹理细节和真实感的提升。预训练和中期训练阶段严格过滤 AIGC 数据,避免陷入“塑料感”纹理的局部最优;在 SFT 阶段,所有数据均经过人工精筛来对齐大众审美;在 RL 阶段,创新性地引入 AIGC 内容检测器作为奖励模型,利用其对抗信号逆向引导模型学习真实世界的物理纹理、光影和质感。

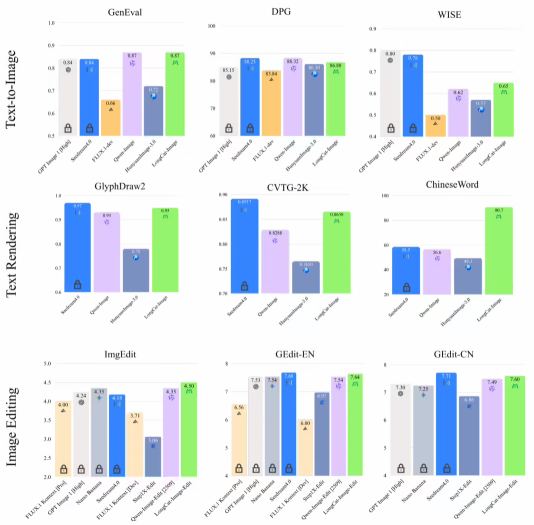

客观基准评测

全面的客观基准测试充分验证了 LongCat-Image 的核心竞争力:在图像编辑任务中,ImgEdit-Bench(4.50 分)、 GEdit-Bench 中英文得分(7.60/7.64 分)均达到开源 SOTA 水平,且逼近头部闭源模型水平;在文字渲染方面,ChineseWord 评测以 90.7 分的成绩大幅领先所有参评模型,实现常用字、生僻字的全量精准覆盖;文生图任务上,GenEval 0.87 分、DPG-Bench 86.8 分的表现,使其在生图基础能力上相比头部开源与闭源模型依然具备强竞争力。

综合主观评测

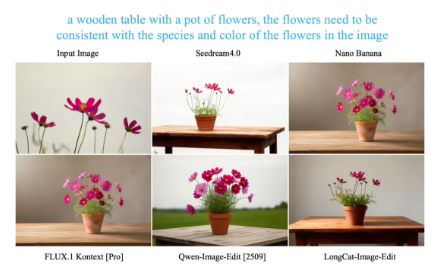

在衡量模型的通用能力时,我们始终将用户的真实体验放在首位。为此,我们采用业界公认的主观评价方法,对 LongCat-Image 在“文生图”与“图像编辑”两大核心场景下的表现进行了系统评估。

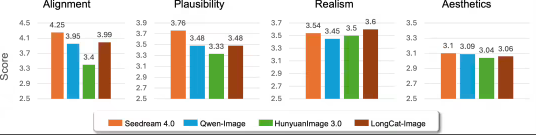

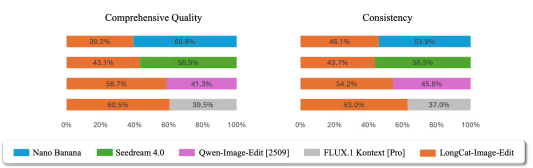

在文生图方面采用大规模的人工主观评分(MOS)方法,核心覆盖文本-图像对齐、视觉合理度、视觉真实度、美学质量 4 个维度,LongCat-Image 的真实度相比主流开闭源模型表现出色,同时在文本-图像对齐与合理度上达到开源 SOTA 水平。在图像编辑方面采用严格的并列对比评估(Side-by-Side, SBS)方法,聚焦于综合编辑质量、视觉一致性这两个用户体验的维度,评测结果表明,LongCat-Image 虽然与 Nano Banana、Seedream 4.0 等商业模型存在一定差距,但显著超越了其他开源方案。

为了构建一个更透明、开放、协作的开源生态系统,我们全面开源文生图的多阶段模型(Mid-training、Post-training)和图像编辑模型,旨在无缝支持从前沿研究到商业应用的全流程。我们坚信,真正的技术进步源于社区的集体智慧。诚邀广大开发者体验模型、参与共建,让我们共同基于这个高效能模型,探索视觉生成的更多可能。