OpenAI 发布 GPT-5.1-Codex-Max,用于处理全天候工程任务

OpenAI 正在用 GPT-5.1-Codex-Max 更新其编码环境,这是一款新模型,旨在处理大量上下文并解决需要数小时完成的复杂工程任务。

OpenAI 发布了其最新的“代理”编码模型 GPT-5.1-Codex-Max。公司表示,该系统专为“长期运行、细致工作”打造,取代了之前的 GPT-5.1-Codex,成为所有 Codex 接口的标准。

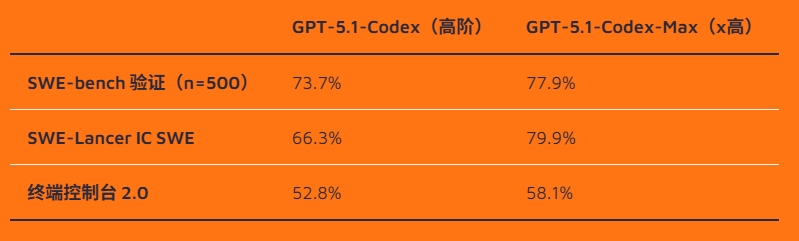

在编码基准SWE-Bench验证测试中,GPT-5.1-Codex-Max预计将获得77.9%的最高分,超过Anthropic和谷歌最近发布的Gemini 3。该模型在内部“SWE-Lancer IC SWE”基准测试中也从66.3%提升至79.9%。

OpenAI表示,新模型比前代少用30%的“思考代币”,同时保持了相同的质量。在实际任务中,它的运行速度也提升了27%到42%。对于延迟无关紧要的工作,新增了一个“超高”推理模式,可以分配更多时间来思考。

据OpenAI介绍,GPT-5.1-Codex-Max也是首个专门训练以在Windows环境中有效工作的模型,旨在提升其处理命令行任务的能力。公司声称95%的工程师每周使用Codex,自工具推出以来,拉取请求数量增长了70%。

目前,ChatGPT Plus、Pro、Team、Edu 和 Enterprise 用户已开放访问权限,Max 版本将取代旧型号成为默认,前一版本仅几天后就将关闭。那个短命的前身每百万输入代币成本为1.25美元,输出代币成本为10美元;OpenAI尚未公布新型号的价格。预计API访问即将实现。

对于ChatGPT Plus用户,每五小时限制为45到225条本地消息和10到60个云端任务。专业用户可获得显著更大的容量,限制在同一期间300到1500条本地消息和50到400项云任务之间。

新技术支持全天的编码会话

OpenAI表示,该模型可以在内部测试中专注于单一任务“超过24小时”,处理修复测试失败或迭代实现等任务。虽然OpenAI未透露这些工作负载的具体细节,但这一说法与Anthropic近期关于其Sonnet 4.5模型能够长时间运行的声明相呼应。

为了管理这些长时间的会话,OpenAI 使用一种称为“压缩”的过程。当模型填满上下文窗口时,会自动压缩会话历史。系统总结相关信息,丢弃不重要的细节,使AI能够在数百万代币中保留核心任务和关键步骤。GPT-5.1-Codex-Max 是首个原生训练以跨多个上下文窗口工作方式的模型。