OpenAI承诺在未来几个月推出“更优版本”的奥运数学金牌模型

OpenAI研究员Jerry Tworek正在分享一款新AI模型的早期细节,该模型可能在某些领域实现性能的显著飞跃。

这款被称作 “国际数学奥林匹克(IMO)金牌得主” 的模型,计划在未来几个月内以 “性能大幅提升的版本” 首次亮相。正如特沃雷克所指出的,该系统目前仍在积极开发中,且正为更广泛的公开发布做准备。

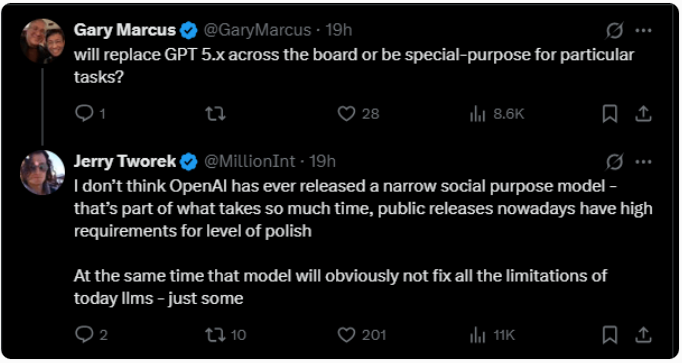

当OpenAI批评者Gary Marcus询问该模型是否旨在取代GPT-5.x或作为任务专属专家时,Tworek表示OpenAI从未发布过聚焦于特定领域的模型。他解释说,“如今公开发布对完善程度的要求很高”,并补充道:“同时,这种模型显然无法解决当今大型语言模型的所有限制——只能解决部分。”

该模型能够超越数学推广,引发了争议。在演讲中,OpenAI强调其在国际数学奥林匹克赛事前的优化“非常有限”。它并非专门的数学系统,而是建立在强化学习和计算领域的更广泛进步之上——不依赖外部工具如代码解释器。一切都通过自然语言完成。

这一区分很重要,因为强化学习在缺乏明确答案的任务上仍然存在困难,许多研究者认为这是一个未解决的问题。这里的突破将有助于验证这样一个观点:扩展推理模型能够证明计算量的巨大增长是合理的,而这也是关于可能存在的人工智能泡沫持续辩论的核心问题之一。

真正的瓶颈是可验证性,而非具体性

前OpenAI和特斯拉研究员安德烈·卡帕西指出了一个更深层的结构性限制:在他所称的“软件2.0”范式中,关键挑战不是任务定义得多好,而是任务能多好地验证。只有内置反馈的任务——如对错答案或明确的奖励信号——才能通过强化学习高效训练。

卡帕西写道:“任务/作业越是可验证,它在新编程范式中就越容易实现自动化。”“如果无法验证,只能靠神经网络的泛化魔法,或者通过更弱的方式,比如模仿。”他说,这种动态定义了LLM进步的“崎岖边境”。

这也是数学、编程和结构化游戏等领域进步迅速的原因,有时甚至超越了专家级的人类表现。IMO任务正好属于这一类。相比之下,在难以验证的领域——如创意工作、策略或依赖上下文的推理——进展停滞不前。

Tworek 和 Karpathy 的观点一致:IMO 模型表明,可验证任务可以通过基于推理的方法系统地扩展,而且此类任务数量众多。但在其他方面,研究人员仍然寄望于大型神经网络能够远远超越其训练数据的泛化。

为什么普通用户可能感觉不到差别

即使模型在数学等严格可验证领域表现优于人类,也不意味着普通用户会感受到影响。这些进步仍可能加速证明、优化或模型设计等领域的研究,但不太可能改变大多数人与人工智能的互动方式。

OpenAI最近指出,许多用户已不再意识到模型质量的真正提升,因为典型的语言任务已变得微不足道,至少在LLM已知的范围内,比如幻觉或事实错误。