芯片初创公司d-Matrix筹集2.75亿美元以加速内存计算推理

芯片初创公司d-Matrix Inc.今天宣布他们已经成功筹集了2.75亿美元的资金,以支持其商业化进程。这轮C轮融资由Bullhound Capital、Triatomic Capital和新加坡的淡马锡主权财富基金领投。此次投资使d-Matrix的估值达到20亿美元。公司计划利用这笔资金扩大其国际影响力,并帮助客户基于其技术构建人工智能集群。

一张显卡由两个主要组件组成:用于处理数据的晶体管和用于存储正在处理的数据的内存池。该内存通常基于HBM,这是一种能够高速将数据加载到晶体管中的RAM。它由多层RAM电路或单元堆叠而成。

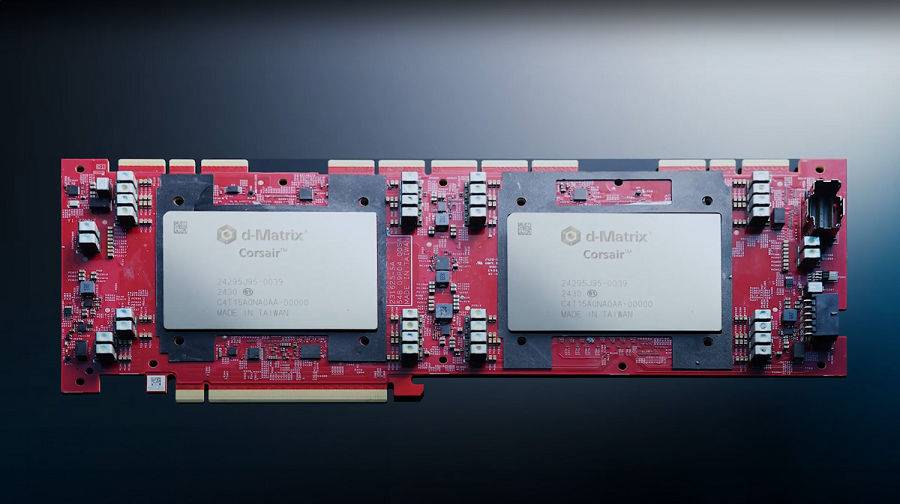

总部位于圣克拉拉的d-Matrix开发了一种名为Corsair的推理加速器,采用了不同的架构。与显卡使用独立的处理和内存组件不同,Corsair将处理组件嵌入到内存中。d-Matrix称这种方法为数字内存计算,被认为比传统的基于HBM的架构更快且更节能。

Corsair以PCIe卡的形式出现,公司可以将其附加到他们的服务器上。该卡包含两个定制芯片,实施了d-Matrix的数字内存计算技术。

Corsair的两个芯片每个包含1GB的SRAM,这是一种同样优化速度的RAM类型,类似于HBM。SRAM最常用于为处理器的小型高性能嵌入式缓存供电。根据d-Matrix的说法,其工程师已重新利用Corsair的一些SRAM电路来执行向量矩阵乘法,这些是AI模型用于执行推理的数学计算。

Corsair的定制芯片除了SRAM外还包含其他组件。还有一个控制核心,这是一个基于开源RISC-V架构的中央处理单元核心,负责协调芯片的工作。一些无法通过d-Matrix修改的SRAM高效执行的计算被分配给SMID核心,这些处理模块优化以并行执行多个计算。

芯片的内部组件通过一个名为DMX Link的定制互连连接在一起。根据d-Matrix的说法,还有一个256GB的内存池,当SRAM容量耗尽时可以用于存储AI模型的数据。该内存池基于LPDDR5,这是一种主要用于移动设备的低功耗RAM。

Corsair可以以块浮点数格式存储AI模型的信息。这些数据结构比显卡使用的标准数据格式占用更少的空间。根据d-Matrix的说法,Corsair在处理以MXINT4块浮点格式存储的数据时每秒可以执行9600万亿次计算。

公司提供加速器以及一个名为JetStream的NIC或网络接口卡。这是一个网络芯片,可以用于将多个配备Corsair的服务器连接成一个AI推理集群。数据中心运营商可以通过将JetStream模块附加到他们服务器机架内的交换机上来部署它们。

上个月,d-Matrix发布了一种名为SquareRack的参考架构,使客户更容易创建由Corsair驱动的AI集群。它支持每个机架最多八台服务器,每台服务器配备八张Corsair卡。单个SquareRack机箱可以完全在SRAM中运行参数多达1000亿的AI模型,d-Matrix称这种安排提供了高达基于HBM芯片10倍的性能。

公司随Corsair一起提供一个名为Aviator的软件栈。它自动化了一些在加速器上部署AI模型的工作。根据d-Matrix的说法,Aviator还包括一套模型调试和性能监控工具。

公司计划明年推出Corsair的后续产品,一种更强大的推理加速器,名为Raptor。据报道,它将在其计算模块上直接堆叠RAM,形成三维配置。在芯片上堆叠内存单元而不是将它们放置在主机服务器的不同部分中可以减少数据必须传输的距离,从而加快处理速度。

Raptor还将引入其他增强功能。值得注意的是,d-Matrix计划用四纳米技术取代Corsair所基于的六纳米制造技术。工艺升级通常会带来速度和能效的提升。