Anthropic获得100万个谷歌TPU,继续以亚马逊为主要训练合作伙伴

Anthropic刚刚签署了一项可能是历史上最大的TPU交易——到2026年将上线多达100万个谷歌张量处理单元,价值数百亿美元,提供超过一吉瓦的计算能力。首席财务官Krishna Rao表示,公司正接近70亿美元的年收入运行率,过去一年中大型企业账户(年收入超过10万美元的账户)增长了7倍。

Anthropic的收入有望在年底达到90亿美元,内部目标是在2026年达到200-260亿美元——这样的增长率需要比任何单一供应商能提供的更多计算能力。行业估计,一个1吉瓦的数据中心大约需要500亿美元建造,其中约350亿美元用于芯片。

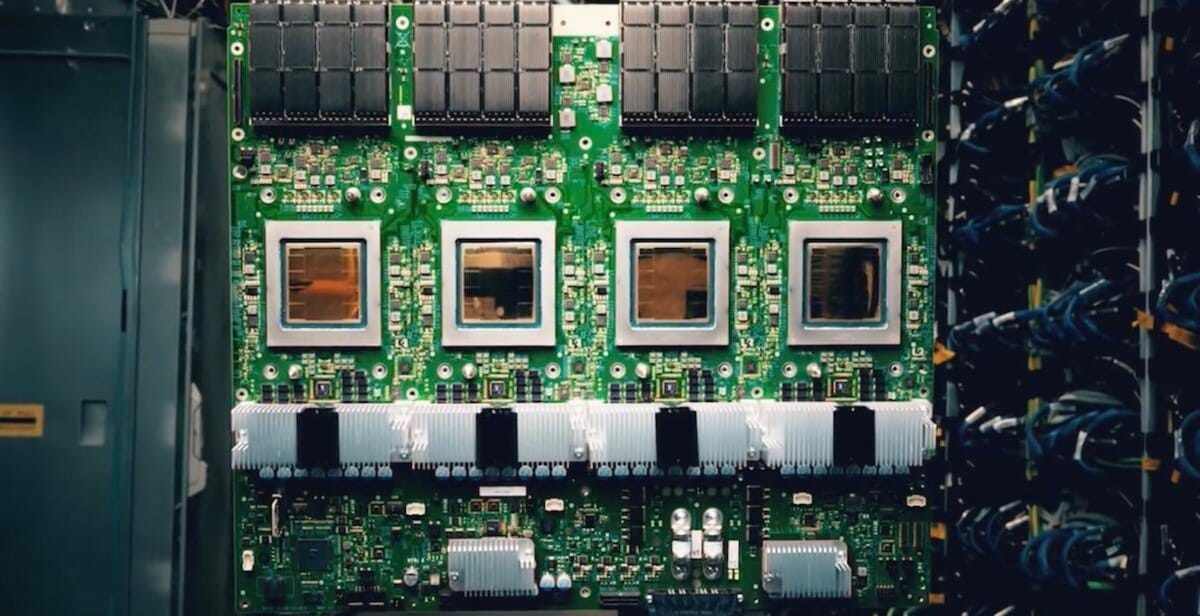

有趣的是其策略本身。大多数AI实验室都与一个芯片供应商绑定,支付高额利润并接受由此带来的容量限制。Anthropic将工作负载分散在三个平台上——谷歌TPU用于某些训练运行,亚马逊Trainium用于庞大的Project Rainier集群,NVIDIA GPU在需要时使用。据了解公司基础设施方法的人士称,在这种模式下,每一美元的计算能力比单一供应商架构更具延展性。

谷歌总共在Anthropic投资了约30亿美元,而亚马逊承诺投资80亿美元,并正在建设Project Rainier,这将提供比Anthropic目前最大的训练集群多五倍的计算能力。问题不在于Anthropic是否偏袒——显然没有——而在于这种多元化方法是否真的能在前沿模型规模上实现其成本效益承诺。

谷歌在推动TPU向外部客户开放的同时获得了一个重要的AI客户,而亚马逊则获得了数十万颗Trainium2芯片的保证买家,证明了尚未在大规模复杂LLM训练中经过实战考验的硅片。Anthropic通过让三家供应商竞争其业务获得了选择权和可能更好的定价。

Project Rainier计划将单个计算集群分布在多个建筑中,连接它们以作为一台计算机运行——这一计划雄心勃勃但在此规模上尚未验证。TPU有其自身的网络限制。多供应商协调增加了复杂性,可能会消耗理论上的成本节约。

Anthropic押注它能成功实现这一目标,而OpenAI在8月的年化收入已超过130亿美元,并有望在年底超过200亿美元。Anthropic正在缩小差距,但两家公司面临相同的基本挑战:足够快地改进模型以证明现在以吉瓦为单位的基础设施账单的合理性。