Gemma 3n:更智能、更快速、离线就绪

作者提供的图片

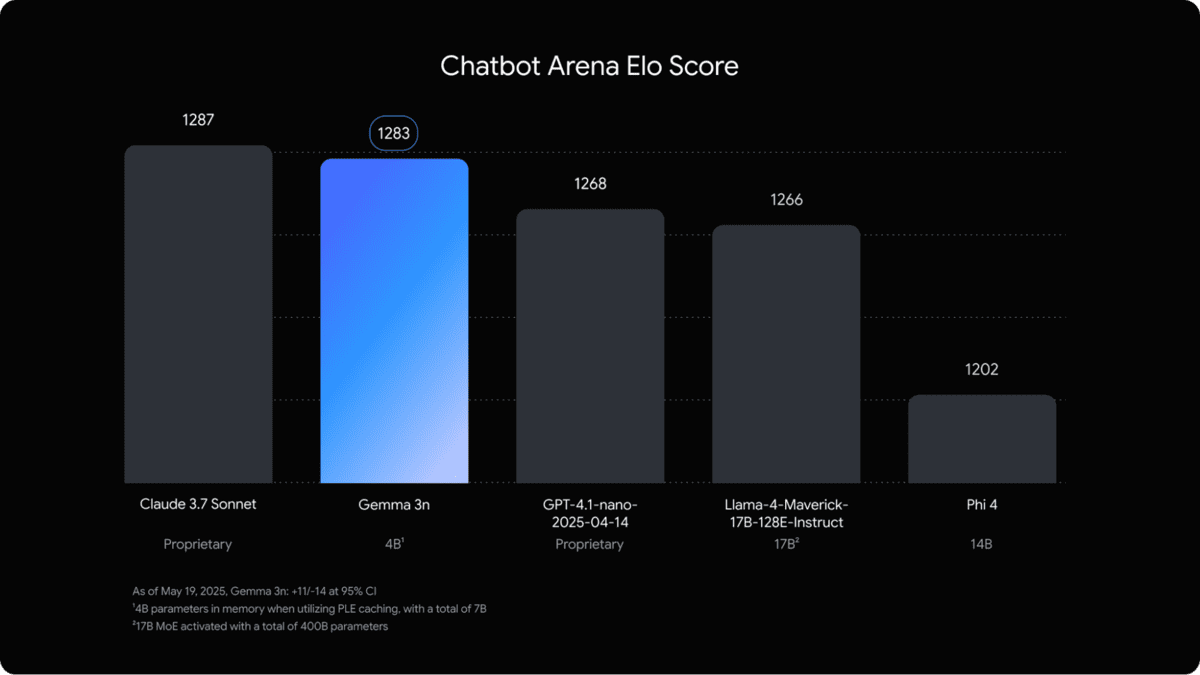

昨天,谷歌发布了他们最新的生成式AI模型Gemma 3n。Gemma 3n体积小巧、速度极快,专为在手机上离线运行而设计,将先进的AI功能带入您的日常设备。它不仅能够理解音频、图像和文本,还具有极高的准确性,性能优于Chatbot Arena上的GPT-4.1 Nano。

图片来源Gemma 3n预览版发布

在这篇文章中,我们将了解Gemma 3n背后的新架构,深入探讨其功能,并提供如何开始使用这一突破性模型的指南。

Gemma 3n的新架构

为了在下一代设备上实现AI,谷歌DeepMind与高通技术、联发科和三星系统LSI等领先的移动硬件创新者紧密合作,开发了一种新架构。

该架构旨在优化资源受限设备(如手机、平板电脑和笔记本电脑)上的生成式AI性能。它通过三个关键创新实现这一目标:每层嵌入(PLE)缓存、MatFormer架构和条件参数加载。

PLE缓存

PLE缓存允许模型将每层嵌入参数卸载到快速外部存储中,减少内存使用的同时保持性能。这些参数在模型的操作内存之外生成,并在执行期间根据需要检索,即使在资源有限的设备上也能实现高效操作。

MatFormer架构

Matryoshka Transformer(MatFormer)架构引入了一种嵌套的Transformer设计,其中较小的子模型嵌入在较大的模型中,类似于俄罗斯套娃。这种结构允许选择性激活子模型,使模型能够根据任务动态调整其大小和计算需求。这种灵活性降低了计算成本、响应时间和能耗,使其非常适合边缘和云部署。

条件参数加载

条件参数加载允许开发者跳过加载未使用的参数,如音频或视觉处理参数。这些参数可以在运行时动态加载,从而进一步优化内存使用,使模型能够适应各种设备和任务。

Gemma 3n的功能

Gemma 3n引入了创新技术和功能,重新定义了设备上AI的可能性。

让我们分解其关键能力:

- 优化的设备性能和效率:Gemma 3n比其前身(Gemma 3 4B)快约1.5倍,同时保持显著更好的输出质量。

- PLE缓存:PLE缓存系统使Gemma 3n能够将参数存储在快速的本地存储中。

- MatFormer架构:Gemma 3n使用MatFormer架构,根据特定请求选择性激活模型参数。

- 条件参数加载:为了节省内存资源,Gemma 3n可以在不需要时绕过加载不必要的参数,如视觉或音频参数。

- 隐私优先和离线就绪:在本地运行AI功能,无需互联网连接,确保用户隐私。

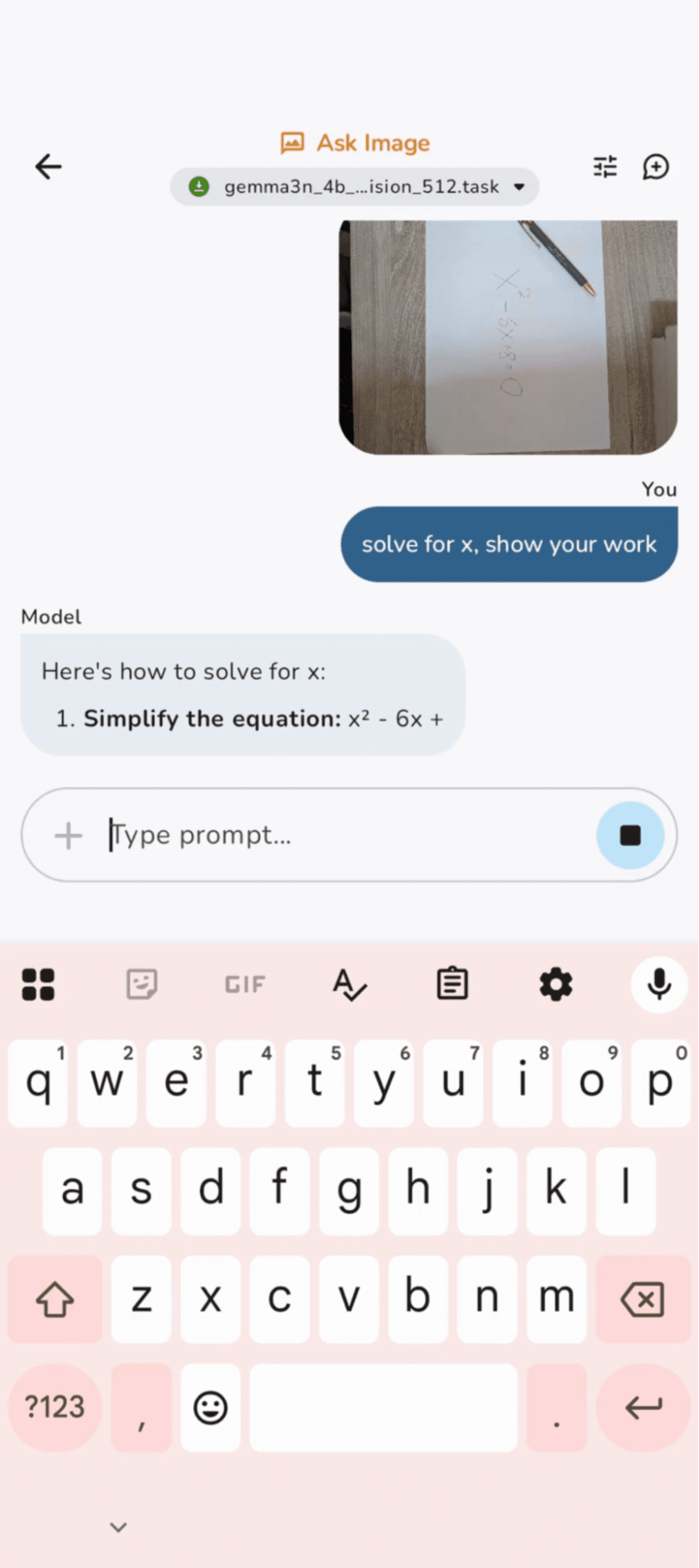

- 多模态理解:Gemma 3n提供对音频、文本、图像和视频输入的高级支持,实现复杂的实时多模态交互。

- 音频功能:它提供自动语音识别(ASR)和语音转文本翻译,具有高质量的转录和多语言支持。

- 改进的多语言能力:在日语、德语、韩语、西班牙语和法语等语言中显著提升性能。

- 32K令牌上下文:它可以在单个请求中处理大量数据。

如何开始

开始使用Gemma 3n既简单又易于访问,开发者可以通过两种主要方法探索和集成这一强大的模型。

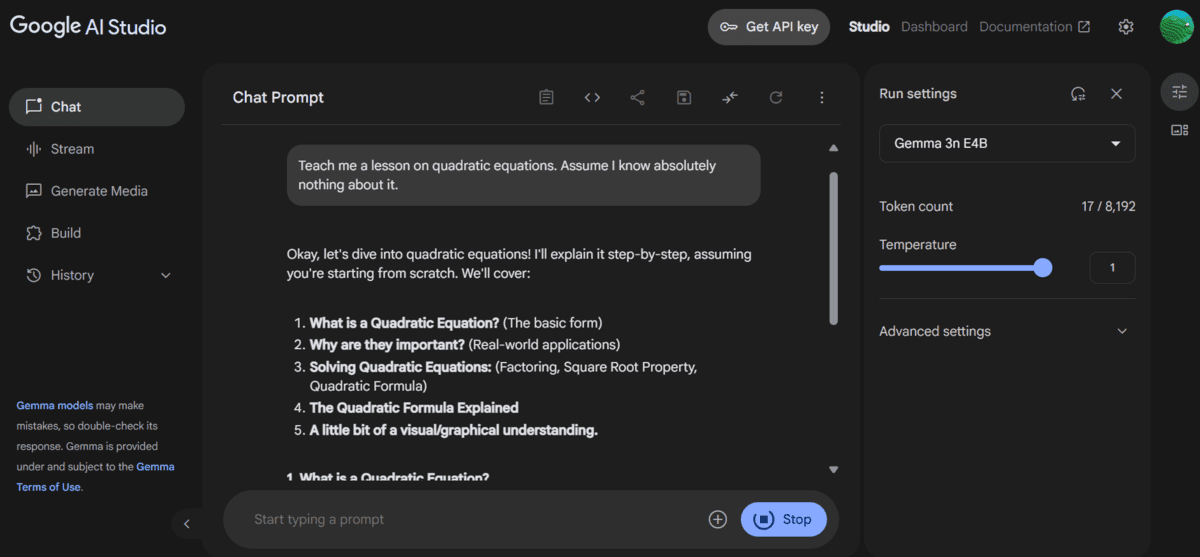

1. Google AI Studio

要开始,只需登录Google AI Studio,进入工作室,选择Gemma 3n E4B模型,开始探索Gemma 3n的功能。工作室非常适合希望快速原型和测试想法的开发者,然后再进行全面实施。

截图来自聊天 | Google AI Studio

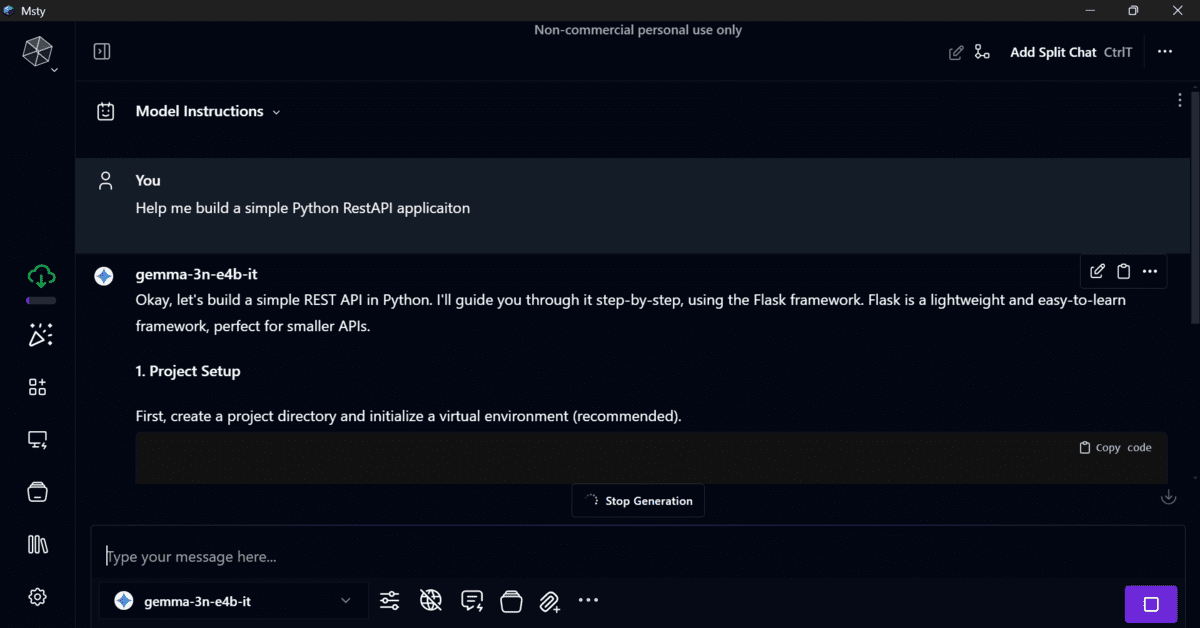

您可以获取API密钥,并通过Msty应用将模型集成到本地AI聊天机器人中。

Msty应用截图

此外,您可以使用Google GenAIPython SDK,通过几行代码将模型集成到您的应用程序中。

2. 使用Google AI Edge进行设备开发

对于希望将Gemma 3n直接集成到其应用程序中的开发者,Google AI Edge提供了设备开发所需的工具和库。这种方法非常适合在Android和Chrome设备上本地构建利用Gemma 3n功能的应用程序。

图片来源谷歌开发者博客

结论

许多专家和专业人士认为,谷歌正准备在未来几周内将Gemma 3n完全开源并向所有人开放。预计公司还将随着时间的推移发布额外的功能,如增强的图像和音频理解。虽然当前的预览版专注于文本理解,但这些即将到来的进步将进一步扩展模型的功能。

Gemma 3n代表了在小型设备上实现大型AI模型的重大进步。通过使这些模型能够本地运行,Gemma 3n确保您的数据在设备上保持私密,同时提供快速性能和先进LLM的多模态能力。