【评估】医疗数据的差异隐私和联合学习

敏感数据需要更多保护

在大型语言模型从公共互联网上训练出来的时代,人们对数据隐私的需求似乎已普遍放宽,而不管其各自公司领导公开承认的实际知识产权。

但是,当涉及到病人的数据,即我们的健康记录时,还有一个更加敏感的平行世界,这无疑要敏感得多,也需要保护得多。

此外,全世界的法规都在不断加强,包括人工智能在内的数据保护法规也一致趋向于更加严格。

这其中有显而易见的道德原因,我们无需解释,但从企业层面的监管和法律原因来看,制药公司、实验室和医院必须使用最先进的技术来保护患者的数据隐私。

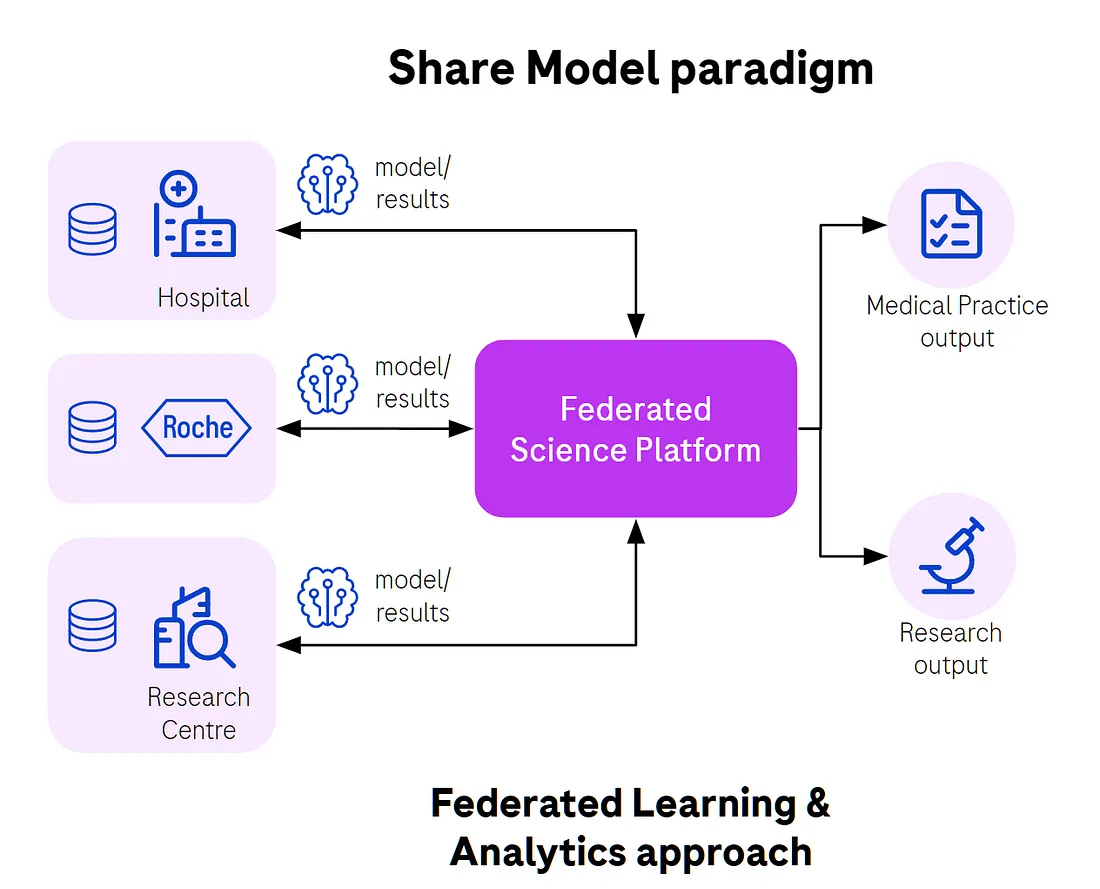

联合范例可提供帮助

联合分析和学习是在不访问任何原始数据的情况下对患者数据进行分析和模型训练的最佳选择。

例如,就联合分析而言,这意味着我们可以在不访问任何可能导致患者身份重新识别的原始数据的情况下,获得血糖与患者体重指数之间的相关性。

就机器学习而言,以诊断学为例,通过对病人的图像进行模型训练,可以检测出病人组织中的恶性变化,例如检测出癌症的早期阶段。这简直就是机器学习的救命应用。在医院一级,使用本地图像和专业放射科医生指定的标签对模型进行本地训练,然后进行汇总,将所有这些本地模型合并为一个更通用的模型。这一过程会重复数十或数百轮,以提高模型的性能。

对每家医院来说,训练有素的模型将使他们受益匪浅,能够以更高的概率检测到未来患者的疾病。这对每个人,尤其是患者来说都是双赢的局面。

当然,联盟网络拓扑结构和模型聚合策略多种多样,但在本文中,我们试图将重点放在典型的例子上。

借助技术建立信任

人们认为,由于数据所有者不愿意与合作伙伴共享数据(这是有道理的),大量临床数据没有得到利用。

联合学习是以技术为后盾建立信任的关键策略,而不仅仅是依靠合同和对特定员工的道德信仰以及组成联合体的组织的合作伙伴。

首先,数据保留在源头,从未离开过医院,也不会集中在一个单一的、潜在的易受攻击的位置。联合式方法意味着没有任何外部数据副本,而这些副本在研究完成后可能很难删除。

由于采用了多种遵循纵深防御原则的技术,该技术可以阻止对原始数据的访问。每种技术都能将数据暴露和患者身份再识别的风险降低数万或数千倍。这一切都使得发现或重建原始数据在经济上不可行。

我们首先对数据进行最小化处理,只向本地运行的机器学习代理暴露必要的属性,剥离 PII 数据,并使用匿名化技术。

然后,本地节点通过只允许本地数据所有者接受的代码和操作在其数据上运行,来保护本地数据免受所谓 “太好奇的数据科学家 ”的威胁。例如,医院本地部署的模型训练代码作为一个软件包,本地数据所有者允许或不允许。远程数据科学家不能向远程节点发送任何代码,因为这将允许他们返回原始数据。

模型是否足够私密?

假设所有这些保护层都已到位,模型权重本身的安全性仍然令人担忧。

人工智能界对机器学习模型的关注与日俱增,认为它是数据的超级压缩,不像以前认为的那样黑箱作业,而且比以前认为的揭示了更多的底层数据信息。

这就意味着,只要有足够的技能、时间、精力和强大的硬件,一个有动机的对手就可以尝试重建原始数据,或者至少以很高的概率证明某个病人属于用于训练模型的群体(成员推理攻击(MIA))。还有其他类型的攻击,如提取、重建和逃避。

更糟糕的是,我们都钦佩并从中受益的生成式人工智能的进步为图像重建(例如,患者的肺部扫描)提供了更有效的新技术。我们所有人用来按需生成图像的想法,同样可以被对手用来从核磁共振/CT 扫描仪中重建原始图像。其他数据模式,如表格数据、文本、声音和视频,现在也可以使用基因人工智能进行重建。

差异隐私拯救

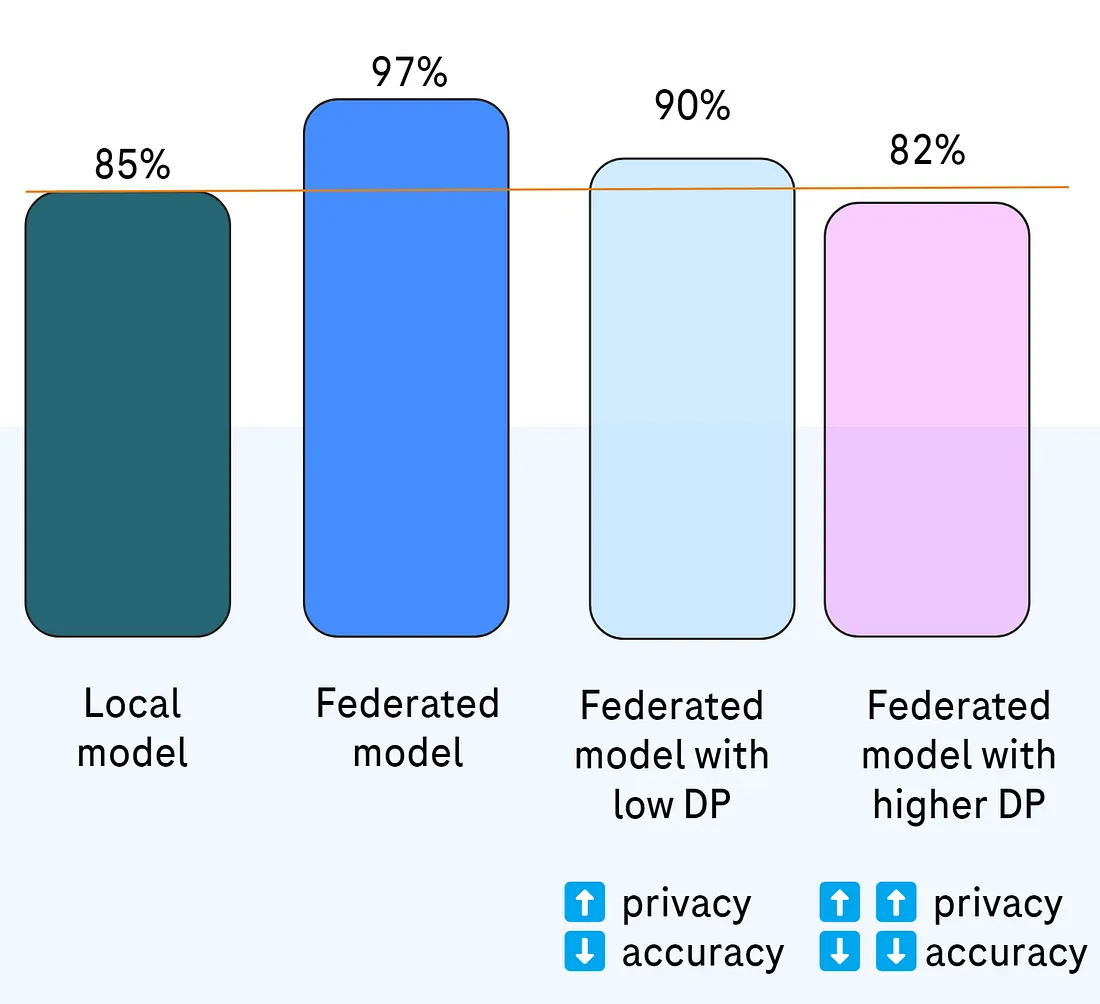

差分隐私(DP)算法承诺,我们可以用模型的部分准确性来换取对推理攻击的更强抵御能力。这是另一个值得考虑的隐私-效用权衡。

差分隐私意味着,在实践中,我们增加了一种非常特殊的噪声和剪切,这将导致隐私收益与准确性损失的良好比率。

它可以像最小有效高斯噪声一样简单,但如今我们迎来了更复杂算法的发展,如稀疏矢量技术(SVT)、作为差异化私有随机梯度下降(DP-SGD)实际实现的 Opacus 库,以及基于拉普拉斯噪声的古老库(即 PyDP)。

顺便说一句,我们都受益于这种技术,甚至没有意识到它的存在,而它现在就正在发生。我们从移动设备(苹果 iOS、谷歌 Android)和桌面操作系统(微软 Windows)获取的遥测数据正在使用差异化隐私和联合学习算法来训练模型,而无需从我们的设备中发送原始数据。这种技术已经很多年。

现在,其他使用案例的采用率也在不断提高,其中包括我们最喜欢的孤岛式联合学习案例,在不同组织和公司组成的联合体中,参与者相对较少,但却拥有大量数据。

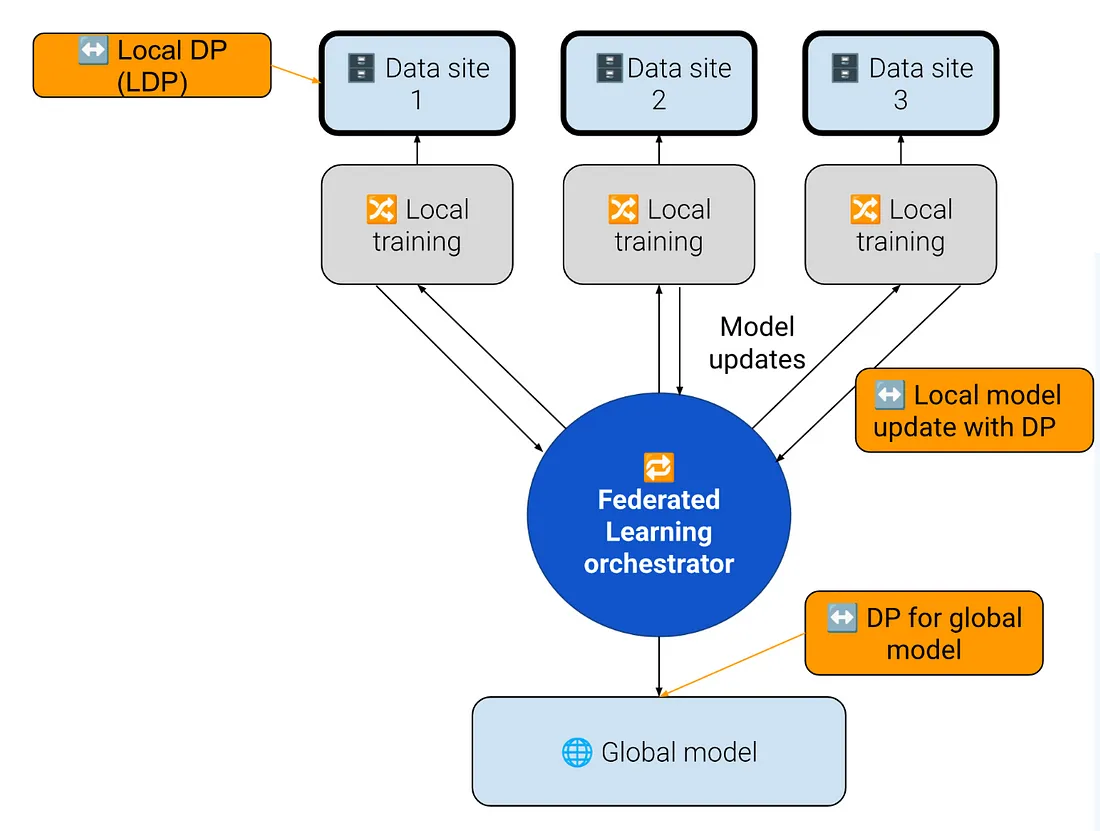

差异化隐私并非联合学习所特有。不过,在联合学习场景中应用数据隐私有不同的策略,选择的算法也不尽相同。不同的算法对联合学习设置更有效,对本地数据隐私(LDP)和集中数据处理也不同。

在联合学习的背景下,我们预计在应用差异化隐私后,模型的准确性会有所下降,但仍然(在某种程度上希望)期望模型的性能比没有联合聚合的本地模型更好。因此,尽管增加了噪音和剪切(DP),联合模型仍应保持其优势。

差分隐私最早可应用于源数据(本地差分隐私 (LDP))。

也有在合作伙伴网络内进行联合学习的情况,这些合作伙伴拥有所有的数据访问权,对数据保护水平的关注较少,因此可能根本不需要 DP。

另一方面,当模型要与外部世界共享或进行商业销售时,对全局模型应用数据保护也不失为一个好主意。

实际实验结果

在罗氏的联合开放科学团队中,NVIDIA Flare 是我们首选的联合学习工具,因为它是市场上最成熟的开源联合框架。我们还与NVIDIA团队就NVIDIA Flare 的未来发展进行了合作,并很高兴能帮助改进这个已经非常出色的联合学习解决方案。

我们测试了三种不同的 DP 算法:

- Opacus

- SVT

- 高斯噪声

我们使用不同的策略对模型进行了差分隐私保护:

- 每轮联合学习

- 仅第一轮(联合训练)

- 每 N 轮(联合训练)

针对三种不同情况(数据集和算法):

- FLamby Tiny IXI 数据集

- 乳腺密度分类

- 希格斯分类

因此,我们从算法、策略和数据集(案例)三个维度进行了尝试。

结果符合我们的预期,即隐私预算越低,模型准确度下降越大(如预期)。

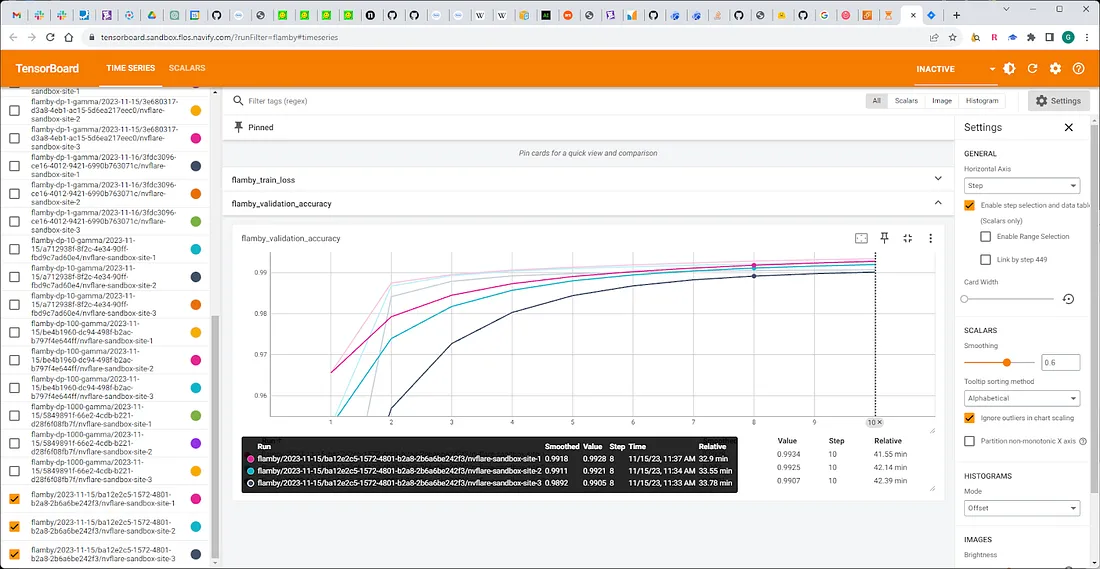

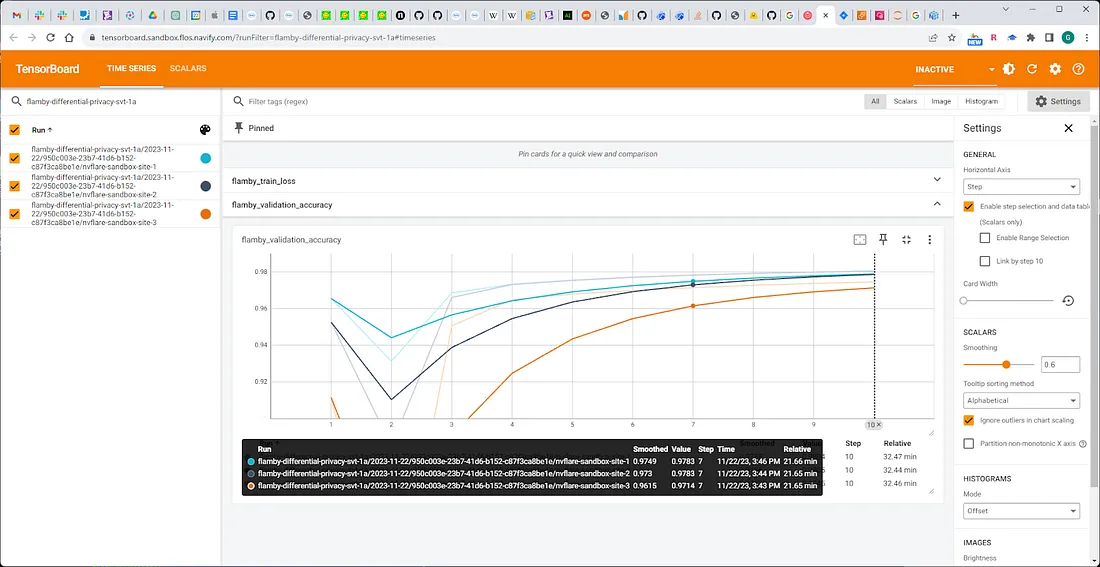

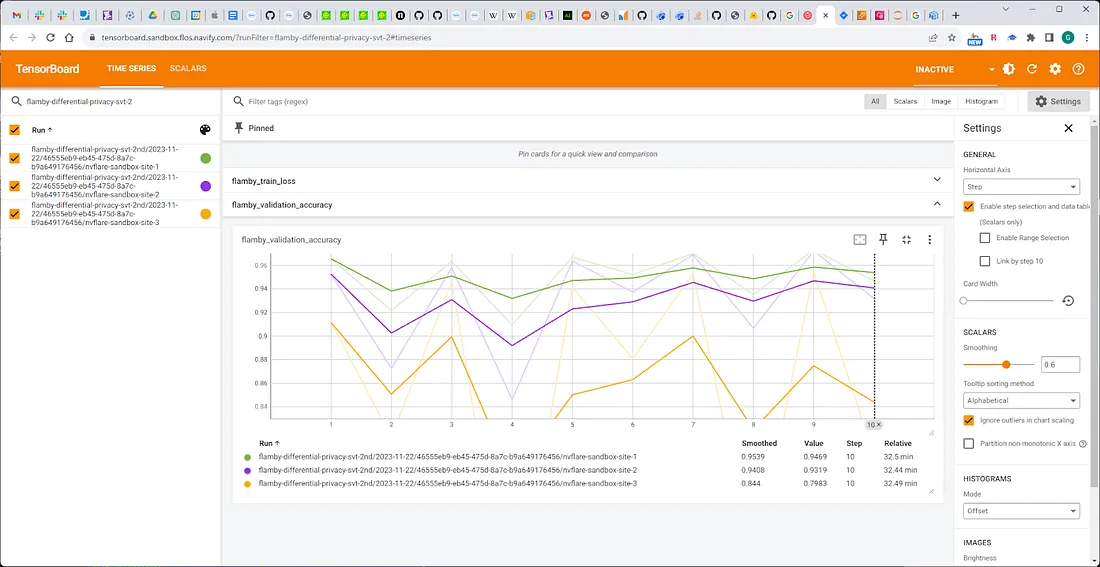

FLamby Tiny IXI 数据集

与每一轮都使用 SVT 滤波器相比,我们发现第一轮使用 SVT 滤波器的准确率有了明显提高。

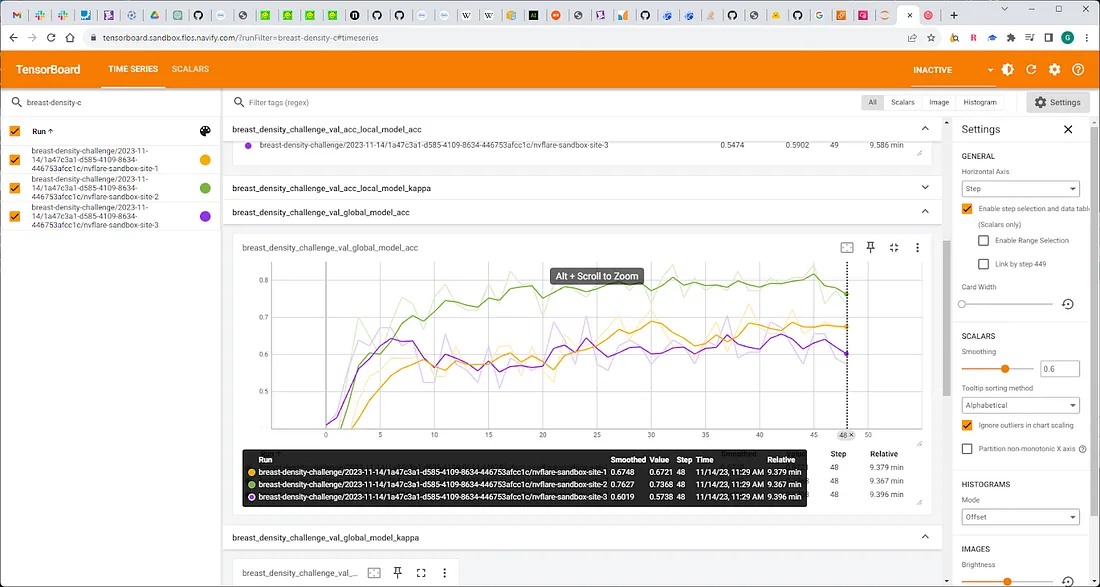

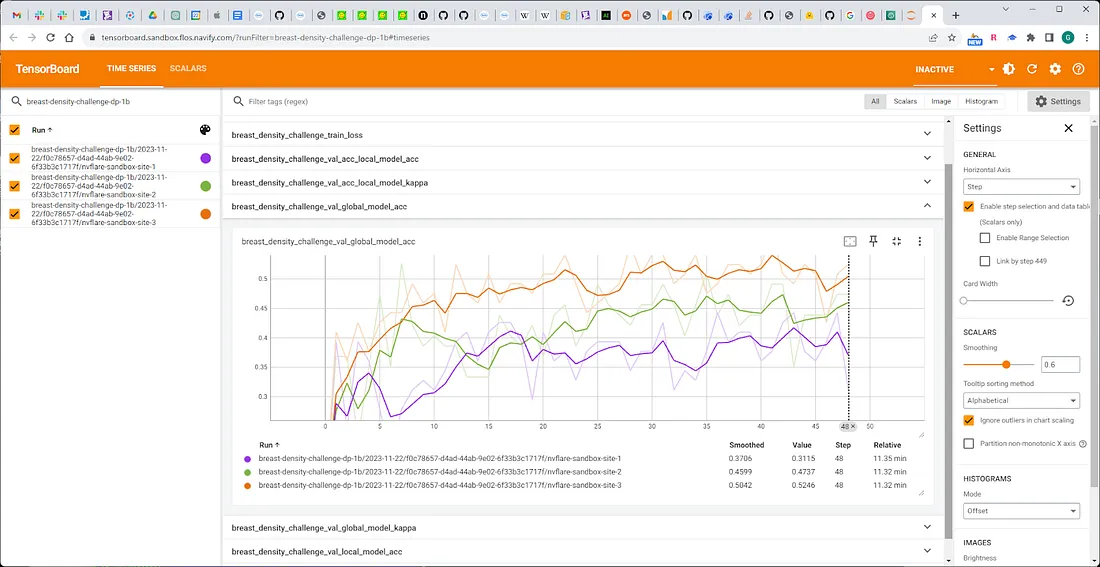

乳腺密度案例

在应用高斯噪声滤波器后,我们发现准确度损失不大。

该数据集是最麻烦的,也是对 DP 最敏感的数据集(准确率损失大、不可预测性强)。

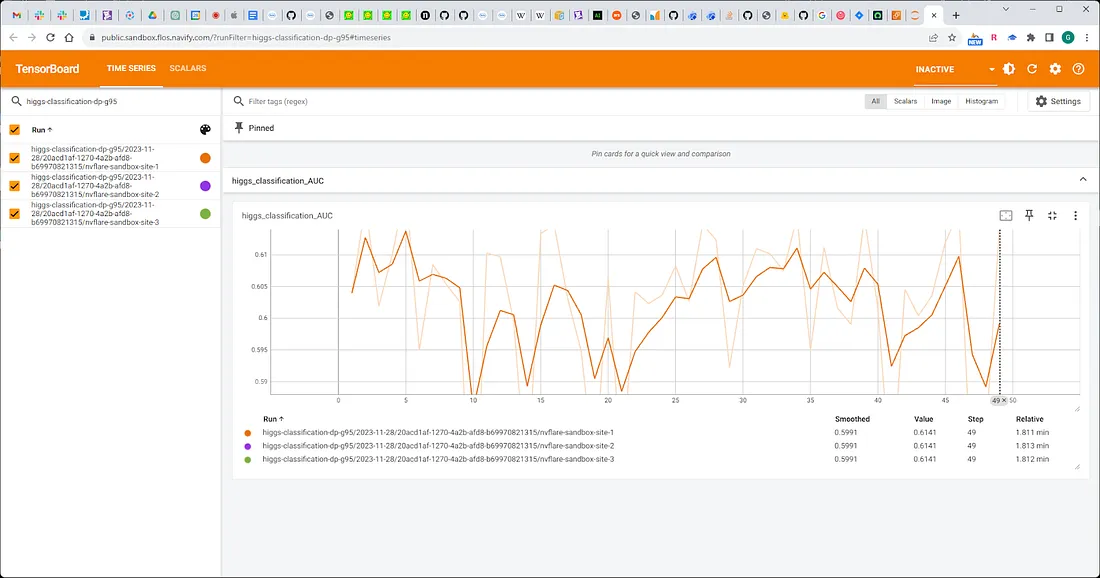

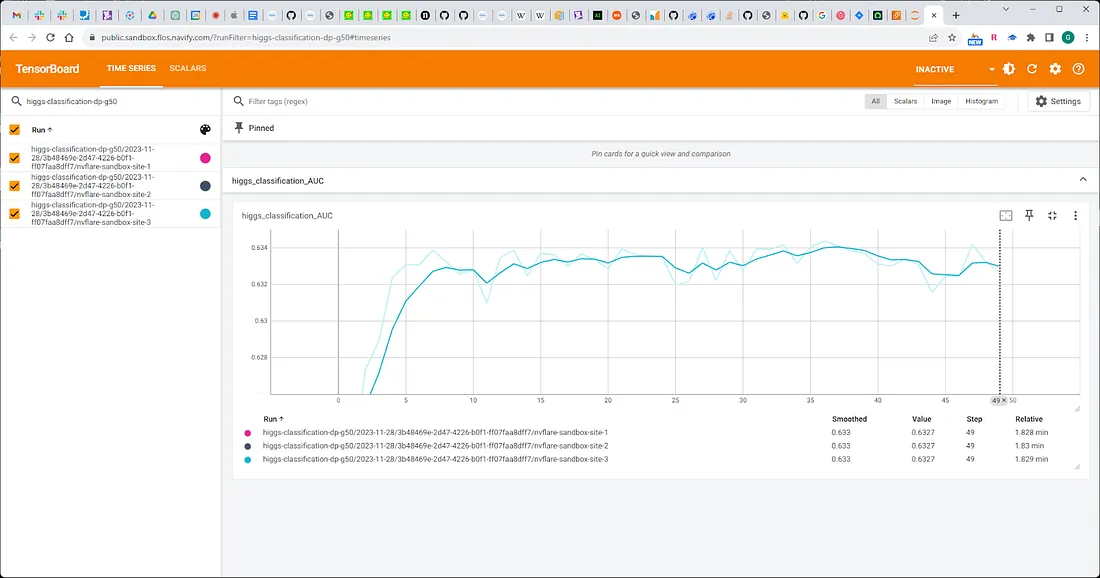

希格斯分类

我们观察到与 DP 有关的轻微、可接受的精度损失。