视觉语言模型新突破:Mini-Gemini框架引领多模态AI能力迈向新高度

视觉语言模型(VLMs)是计算机视觉(CV)与自然语言处理(NLP)两大领域融合创新的产物,旨在模拟人类理解复杂视觉信息的能力,将图像与文字内容相互解释与生成,这一挑战吸引了全球研究人员的广泛关注。

近年来,一系列模型如LLaVA和BLIP-2等崭露头角,它们通过大量图像-文本对的微调,实现了跨模态对齐的优化。此外,LLaVA-Next和Otter-HD等模型则专注于提升图像分辨率和令牌质量,丰富了LLMs内的视觉嵌入,并解决了处理高分辨率图像时的计算难题。同时,InternLM-XComposer以及EMU和SEED等自回归令牌预测方法,旨在通过大量图像-文本数据使LLMs能够直接解码图像。虽然这些方法成效显著,但仍面临着延迟和大规模训练资源需求等挑战。

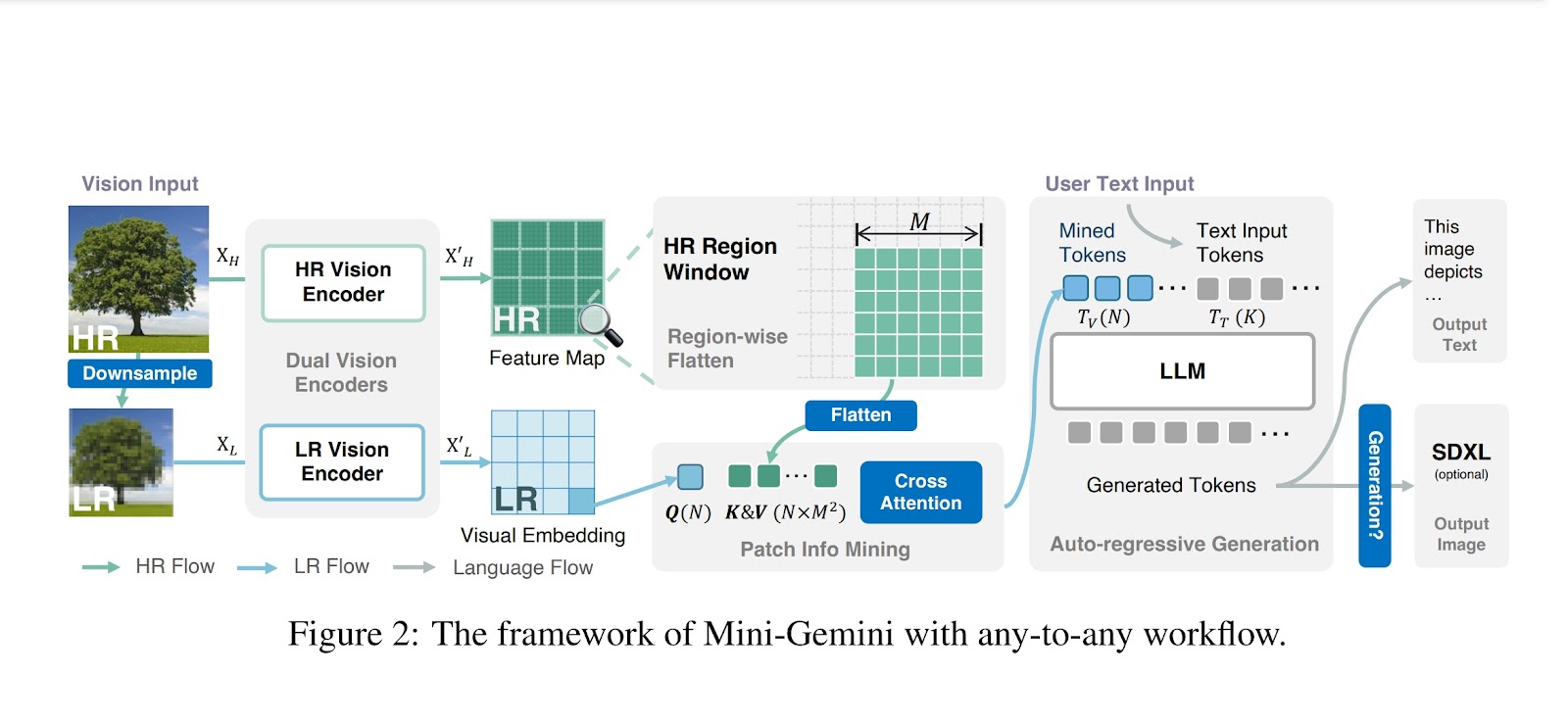

香港中文大学和SmartMore的研究人员提出了一种新颖的框架——Mini-Gemini,它通过增强多模态输入处理,为VLMs的发展注入了新的活力。Mini-Gemini的独特之处在于采用了双编码器系统,结合了补丁信息挖掘技术,并构建了一个高质量的综合数据集。这些创新使得Mini-Gemini能够高效处理高分辨率图像,生成富含上下文的视觉和文本内容,从而在众多模型中脱颖而出。

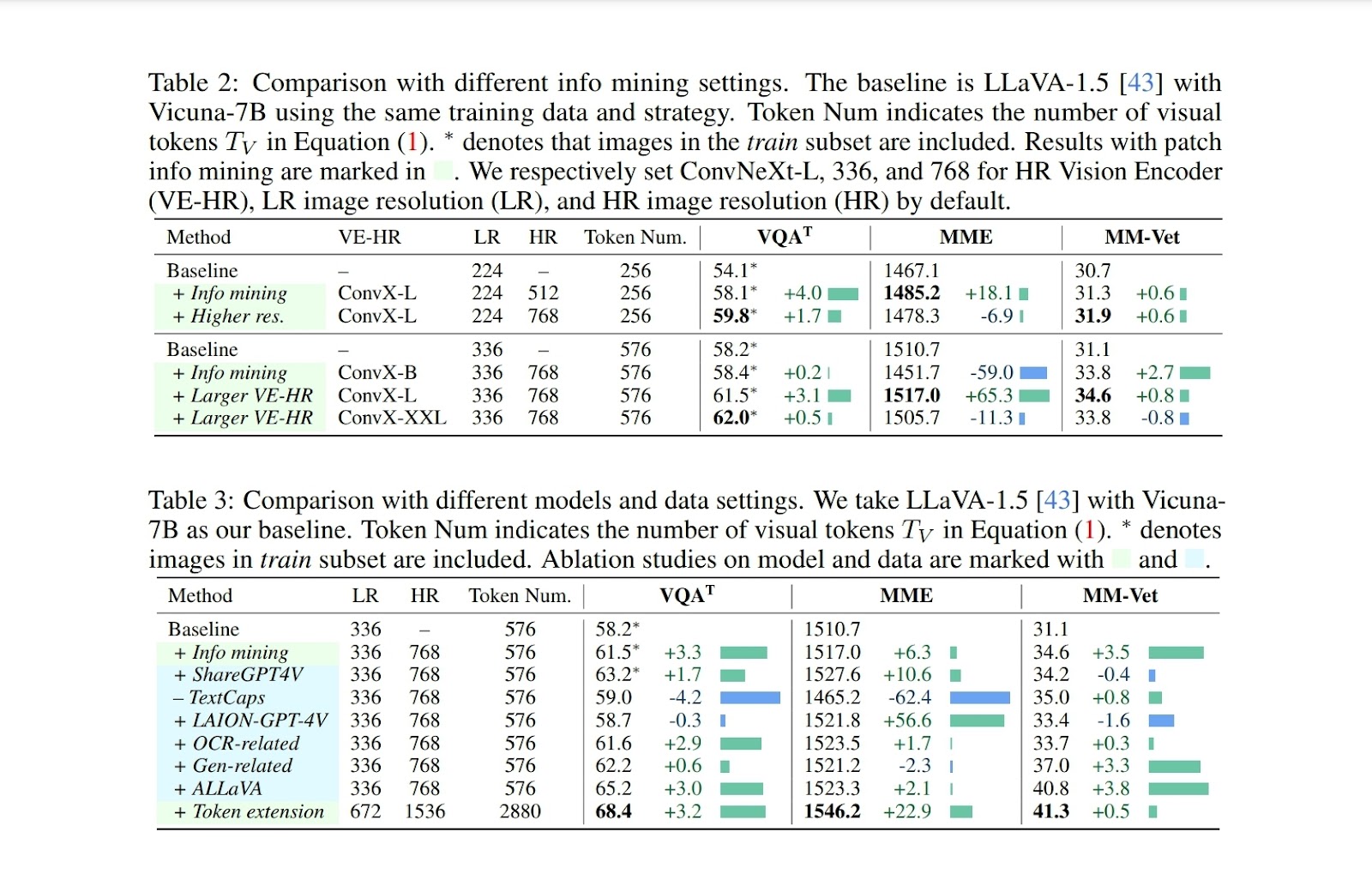

具体来说,Mini-Gemini的双编码器系统包含一个卷积神经网络,用于精细处理图像,增强视觉令牌的质量而不增加其数量。同时,通过补丁信息挖掘技术,框架能够提取详细的视觉线索。这一框架在一个融合了高质量图像-文本对和任务导向指令的综合数据集上进行训练,从而提升了模型性能和应用范围。值得一提的是,Mini-Gemini与多种大型语言模型(LLMs)兼容,参数范围广泛,实现了高效的任意-任意推理。这种设置使得Mini-Gemini在零样本基准测试中取得了卓越的成绩,并支持高级多模态任务。

在评估Mini-Gemini的有效性时,该框架在多个零样本基准测试中展现出了卓越的性能。具体而言,它在MM-Vet和MMBench基准测试中均超越了Gemini Pro模型,分别获得了79.6和75.6的高分。当配置Hermes-2-Yi-34B时,Mini-Gemini在VQAT基准测试中取得了令人瞩目的70.1分,这一成绩优于现有的LLaVA-1.5模型在所有评估指标上的表现。这些结果充分证明了Mini-Gemini在高级多模态处理能力方面的先进性,凸显了其在处理复杂视觉和文本任务时的效率和精度。

总之,这项研究通过引入Mini-Gemini框架,为VLMs的发展带来了新的突破。该框架通过双编码器系统、补丁信息挖掘和高质量数据集的综合应用,展示了在多个基准测试中的卓越性能。Mini-Gemini不仅超越了已有模型,也标志着多模态AI能力迈出了重要的一步。然而,研究人员也指出,Mini-Gemini在视觉理解和推理方面仍有提升空间,未来的研究将致力于探索更先进的视觉理解、推理和生成方法。