模型Quiet-STaR实现让AI像人类一样“思考”

人类天生具备推理的能力:“如果”、“为什么”以及“言外之意”和推断未言明信息的能力,这些都是我们解决问题能力的关键。

到目前为止,人工智能模型自然在这方面一直饱受困扰。但斯坦福大学和Notbad AI公司的研究人员现在透露,他们已经教会了人工智能模型在回应提示之前先思考——就像(大多数)人们在说话前会考虑要说什么一样。

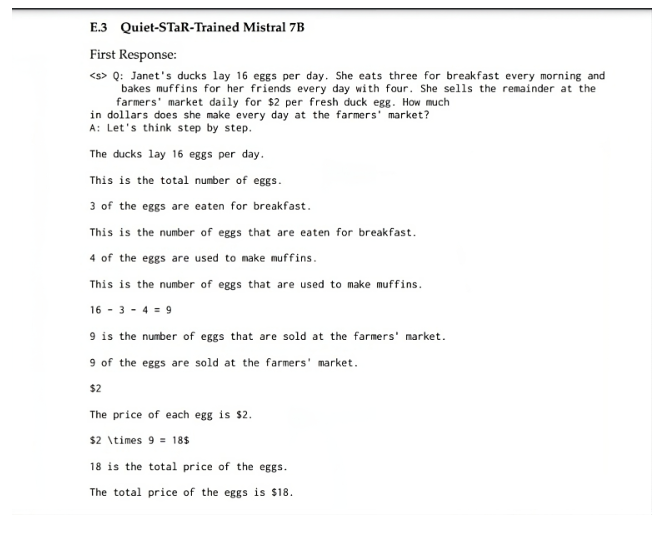

研究人员引入了Quiet-STaR——一种Self-Taught Reasoner(STaR)模型的扩展——它经过大量互联网数据的训练,学会在每个标记处生成理由来解释未来的文本并改进预测。

Quiet-STaR被应用于Mistral 7B,在CommonsenseQA问答挑战(从36.3%的基础提升到47.2%)和GSM8K小学数学应用题数据集(从5.9%的基础提升到10.9%)上的零样本直接推理能力有所提升。而且,随着模型“内部思维”中使用的标记数量的增加,这些改进始终在增加。

“Quiet-STaR标志着向能够以更通用和可扩展的方式学习推理的语言模型迈出了一步。”研究人员写道。

人工智能推理迄今为止的不足之处

之前帮助语言模型从其推理中学习的方法更注重特定性而缺乏通用性:人工智能被训练来解决单个任务或依赖于精心策划的数据集的预定任务集。

例如,Quiet-STaR开发人员指出,一个经过预训练的语言模型在回答多项选择题之前输出人类推理轨迹方面的微调表现,优于直接针对答案进行训练的AI。其他模型在提供“脚手架”的情况下,可以在没有额外监督的情况下生成一连串的解决思路。此外,研究人员还“迫使”模型使用一连串的推理,除非它们完全确信,否则不允许它们回答。

“然而,这些方法再次仅适用于问答数据集。”斯坦福大学和Notbad AI公司的研究人员争辩道。

特别是STaR证明,模型可以在问答数据集上“引导”其推理能力。它们可以抽样推理尝试回答问题,如果这些推理导致了正确答案,就在这些推理的基础上进行训练,并反复迭代以解决越来越难的问题。

然而,Quiet-STaR研究人员指出,从经过整理的数据集中进行训练会限制推理的“规模和可推广性”。高质量的数据集“本质上只涵盖推理任务的一个子集”。

研究人员断言,从问答中的几个例子中推断出推理是一种“高度受限的设置”。“理想情况下,语言模型应该学会从任意文本中推断出未言明的推理。”

通过扩展STaR,“我们允许语言模型从语言中的多样化任务中学习。据我们所知,这是首次明确训练语言模型从文本中普遍推理的工作,而不是针对经过整理的推理任务或推理任务集合进行训练。”

“安静”地思考

斯坦福大学和Notbad AI公司的研究人员将他们的技术称为Quiet-STaR,是因为它在应用STaR时“悄无声息”。

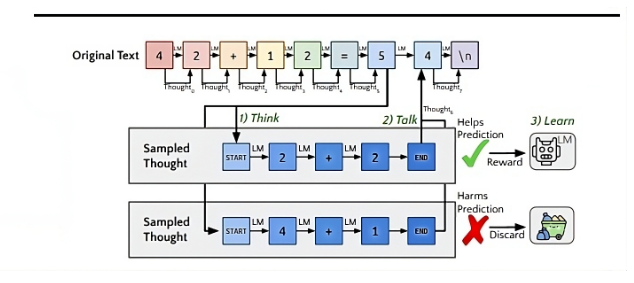

该方法在每个标记处并行生成许多内部思考,以在响应提示之前解释未来的文本(即“思考”的过程)。当人工智能最终回答时,它会产生有理由和无理由的预测混合体。

然后应用了REINFORCE算法;在强化学习中,这会在一个情节中收集样本,以更新策略参数以及思考开始和结束时的嵌入。研究人员解释说,这有助于增加人工智能准确预测未来文本的可能性。作为这一过程的一部分,模型还会丢弃不正确的预测。

“通过迭代优化这些参数,Quiet-STaR在训练过程中训练模型生成更多有用的理由。”研究人员写道。

因为他们的目标是通用推理,所以他们使用了零样本提示(“让我们一步步思考”),而没有上下文示例。Quiet-STaR被应用于Mistral 7B,使用了网络文本数据集OpenWebMath和Colossal Clean Crawled Corpus。

“Quiet-STaR……允许模型在每个标记处安静地思考,训练出的分布是有用的。”研究人员写道。

他们补充说,“通过训练来自多样化网络文本中隐含的丰富推理任务,而不是仅仅针对特定数据集进行狭义的专业化,Quiet-STaR为更健壮和适应性更强的语言模型指明了方向。”

缩小模型与人类推理能力之间的差距

值得注意的是,研究人员创建了一个并行采样算法,该算法从字符串中的所有标记生成推理。这使得标记能够“关注自身”,以及具有相同思考的所有前面的标记和前面的文本。这允许“所有思考的并行延续”,并且每次推理调用都会为所有标记生成一个额外的标记。

研究人员在每个思考的开始和结束时引入了自定义的元标记。<|startofthought|>和<|endofthought|>初始化为破折号”—”,这通常用于表示暂停。

“直觉上,开始思考的标记可以被理解为将模型置于‘思考模式’。”研究人员解释说,“而结束思考的标记可以被理解为告诉模型何时停止思考。”

下一步是引入所谓的“混合头”,这是一个“浅层”多层感知器。这有助于研究人员回顾性地确定在当前的下一个标记预测中应纳入来自给定思考的下一个标记预测的程度。

最后,研究人员优化了参数,以增加更可能的未来文本的可能性。强化技术根据其对未来预测的影响为推理提供“学习信号”。为了帮助减少方差,研究人员还引入了一个“教师强制”技巧,确保神经网络尽可能接近真实序列。

最终,研究人员得出结论:“Quiet-STaR代表了向能够以通用和可扩展的方式学习推理的语言模型迈出的一步。未来的工作可以在这些见解的基础上进一步缩小语言模型与人类类似推理能力之间的差距。”