综合上下文:NLP中命名实体识别的探索

介绍

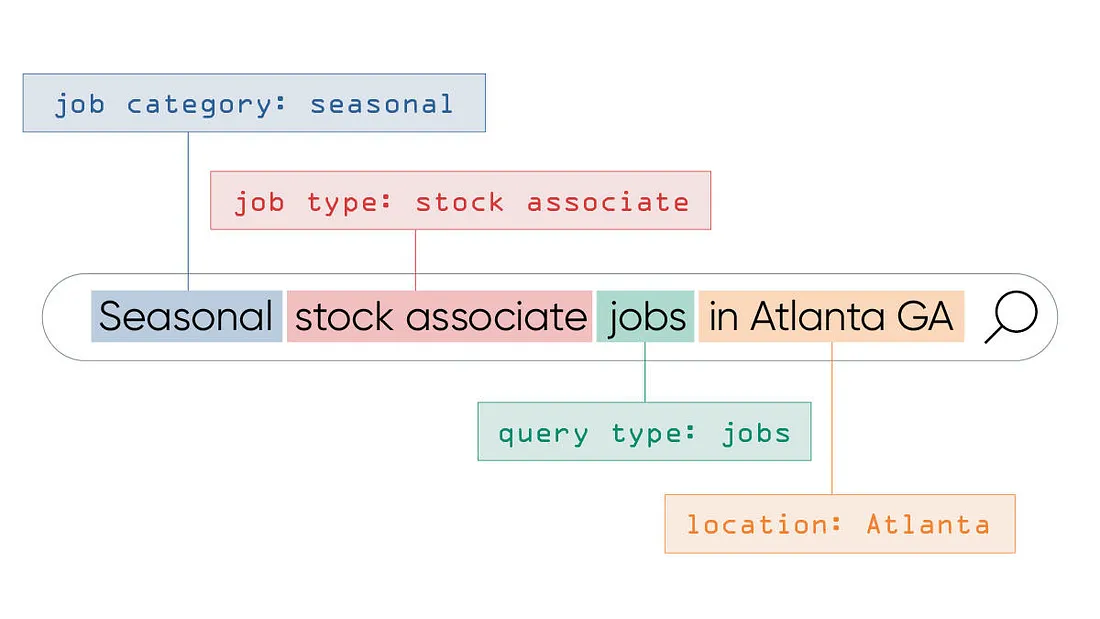

命名实体识别(NER)是信息提取的一个子任务,旨在定位非结构化文本中提到的命名实体并将其分类为预定义的类别,例如人名、组织、位置、时间表达、数量、货币价值、百分比等。

NER的背景和重要性

NER是问题解答、机器翻译、内容分析和知识图谱构建等许多 NLP 应用的基础。在数据主要是非结构化数据的时代,命名实体识别是解析大量文本以获取有价值信息的关键步骤。例如,在金融新闻分析中识别公司并将其与股票代码联系起来对市场分析至关重要。

NER 面临的挑战

NER 所面临的挑战是多方面的。语言表达的多变性意味着实体可以有多种指代方式。例如,"纽约市"、"纽约市 "和 "大苹果 "都是指确切的地点。模糊性也是一个挑战,例如,"约旦 "可以指一个国家、一条河流或一个人的名字。此外,新的实体(如新的产品名称或公司)不断涌现,NER 系统必须经常更新才能识别这些实体。

方法论

NER 方法包括基于规则的系统(依靠词典和语言语法)和统计模型(如隐马尔可夫模型 (HMM) 和条件随机场 (CRF))。近年来,深度学习占据了中心位置,与 CRF 相结合的双向长短期记忆网络(Bi-LSTM)等模型,以及最近基于Transformer的模型(如 BERT 和 GPT)都表现出了卓越的性能。

特征工程和模型训练

NER 系统的性能取决于特征工程。传统模型依赖于手工制作的特征,如词缀、语音部分标记和正字法特征。而现代方法则利用预先训练好的单词嵌入,根据大型语料库中的单词共现统计来捕捉语义上的细微差别。

训练这些模型通常需要使用大型注释语料库。CoNLL-2003 和 OntoNotes 等数据集已被广泛使用。注释不仅涉及标记实体,还涉及定义多词实体的边界,这又增加了一层复杂性。

评估指标和结果

通常使用精确度、召回率和 F1 分数对 NER 系统进行评估。精确度衡量 NER 系统识别的命名实体有多少是正确的,而召回率则衡量 NER 系统识别的命名实体有多少是正确的。F1 分数是精确度和召回率的调和平均值,为性能比较提供了单一指标。

高性能的 NER 系统可以达到令人印象深刻的精确度和召回率。不过,由于语言特点、领域特殊性和文本复杂性的不同,得分也会有很大差异。

应用

NER 在现实世界的许多应用中都有使用,包括搜索引擎、推荐系统、内容推荐、合规性监控和客户服务自动化。该技术还能极大地丰富文本数据,以便在大数据分析中进行更好的处理和分析。

代码

我们需要数据和机器学习框架,以便为命名实体识别(NER)模型实现更真实的训练过程。让我们使用 sklearn-crfsuite 库的简单方法来训练条件随机场(CRF)模型,该模型通常用于 NER 等序列预测任务。

首先,你需要安装必要的软件包:

pip install sklearn-crfsuite

然后,我们就可以实施基本的训练过程:

- 我们将生成一个合成数据集,但会使用 CoNLL-2003 这样的结构化数据集来实现更真实的场景。

- 我们将从句子中的每个标记中提取特征。

- 我们将在这些数据上训练一个 CRF 模型。

你可以这样做:

import sklearn_crfsuite

# Feature extraction function for a single word

def word2features(sent, i):

word = sent[i][0]

features = {

'word.lower()': word.lower(),

'word.isupper()': word.isupper(),

'word.istitle()': word.istitle(),

'word.isdigit()': word.isdigit(),

}

if i > 0:

word1 = sent[i-1][0]

features.update({

'-1:word.lower()': word1.lower(),

'-1:word.istitle()': word1.istitle(),

'-1:word.isupper()': word1.isupper(),

})

else:

features['BOS'] = True # Beginning of Sentence

if i < len(sent)-1:

word1 = sent[i+1][0]

features.update({

'+1:word.lower()': word1.lower(),

'+1:word.istitle()': word1.istitle(),

'+1:word.isupper()': word1.isupper(),

})

else:

features['EOS'] = True # End of Sentence

return features

# Function to extract features from a sentence

def sent2features(sent):

return [word2features(sent, i) for i in range(len(sent))]

# Function to extract labels from a sentence

def sent2labels(sent):

return [label for token, label in sent]

# Function to train the NER model using CRF

def train_ner_model(data):

X = [sent2features(s) for s in data]

y = [sent2labels(s) for s in data]

crf = sklearn_crfsuite.CRF(

algorithm='lbfgs',

c1=0.1,

c2=0.1,

max_iterations=100,

all_possible_transitions=True

)

crf.fit(X, y)

return crf

# Synthetic dataset

data = [

[("Alice", "PERSON"), ("works", "O"), ("at", "O"), ("Acme", "ORGANIZATION"), ("Corp", "ORGANIZATION")],

[("Bob", "PERSON"), ("moved", "O"), ("to", "O"), ("New", "LOCATION"), ("York", "LOCATION")],

[("Charlie", "PERSON"), ("is", "O"), ("from", "O"), ("Berlin", "LOCATION")]

]

# Train the NER model

model = train_ner_model(data)

# Example of how to use the model for prediction

test_sentence = data[0] # Using the first sentence from our data

test_features = sent2features(test_sentence)

predictions = model.predict([test_features])

print(predictions)

这个示例数据应该是一个句子列表,每个句子都是一个(标记、标签)对列表。对每个标记进行特征提取,以创建一个丰富的表示,CRF 模型可以从中学习。

这种方法为使用 Python 训练 NER 模型提供了一个更真实的例子。

[['PERSON', 'O', 'O', 'ORGANIZATION', 'ORGANIZATION']]

图片显示了与命名实体识别(NER)任务相关的两幅图。

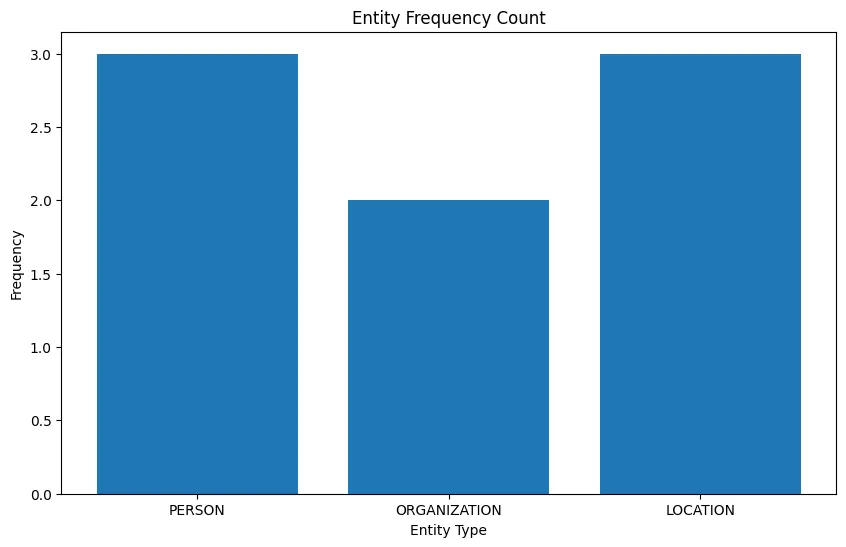

实体频率计数图:

- 该条形图表示数据集中每种命名实体类型的频率。

- 实体类型 PERSON、ORGANIZATION 和 LOCATION 显示在 x 轴上。

- y 轴表示每种实体类型的频率。

- 此图表显示数据集中出现最频繁的 PERSON 实体,其次是 LOCATION,而 ORGANIZATION 实体出现最少。

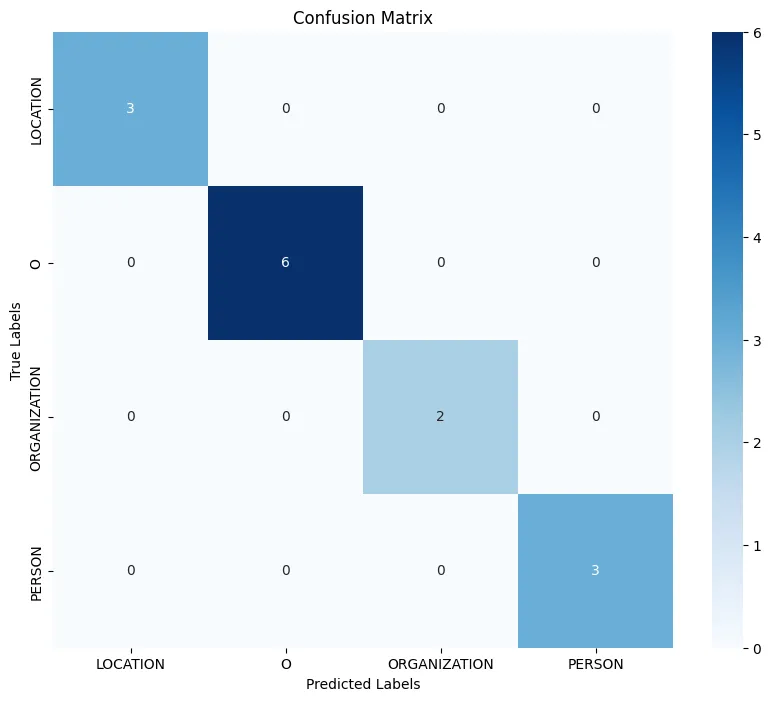

混淆矩阵图:

- 该热图表示分类任务的混淆矩阵。

- x 轴表示预测标签,y 轴表示实际标签。

- 每个单元格的颜色和数字表示每个真实-预测标签对的预测次数。

- 该矩阵显示 LOCATION 始终被正确识别(3 次),因为其行中没有非对角线数字。

- ORGANIZATION 实体两次被误判为 PERSON。

- PERSON 实体总是被正确分类(3 次),没有错误分类。

- 代表正确分类的对角单元格包含所有非零值,表明准确度很高。然而,将 ORGANIZATION 错误分类为 PERSON 表明该模型可能会混淆这两种实体类型。

这些解释有助于深入了解命名实体在数据集中的分布情况以及 NER 模型的性能。频率计数有助于了解数据集的平衡情况,而混淆矩阵则提供了模型预测准确性的详细视图,指出了可以改进的地方。这些分析将为在实际环境中进一步调整模型和数据收集策略提供指导。

结论

总之,NER 仍然是 NLP 研究中一个重要且充满活力的领域。随着深度学习的出现,NER 系统的泛化和扩展能力显著提高。然而,挑战依然存在,特别是在处理低资源语言和特定领域应用方面,这为未来的研究和发展提供了肥沃的土壤。