苹果开发多模态LLM,实现图像数据解读

2024年03月20日 由 daydream 发表

510

0

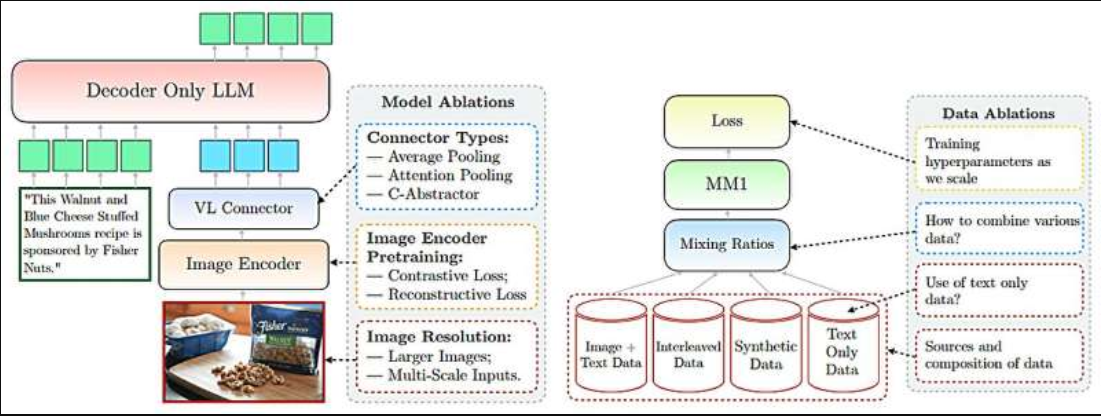

苹果公司的一组计算机科学家和工程师开发了一种LLM模型,该公司声称该模型能够解释图像和数据。该团队在arXiv预印本服务器上发布了一篇论文,描述了他们新开发的MM1系列多模态模型及其测试结果。

过去一年里,LLM因其先进的AI能力而备受关注。值得注意的是,苹果公司在这场讨论中一直缺席。在这次新尝试中,研究团队明确表示,苹果公司并不只是简单地添加由其他公司开发的LLM(目前他们正在与谷歌协商,以将Gemini AI技术添加到苹果设备中);相反,他们一直在努力开发下一代LLM,一种能够解释图像和文本数据的LLM。

多模态AI通过整合和处理不同类型的数据输入,如视觉、听觉和文本信息来工作。这种整合使AI能够更全面地理解复杂数据,从而比单模态AI系统提供更准确和更具上下文意识的解释。

苹果公司的研究团队声称,他们在使用多模态AI与MM1模型方面取得了重大进展,该模型整合了文本和图像数据,以提高图像描述、视觉问答和查询学习的能力。他们的MM1是他们所说的多模态模型系列的一部分,每个模型都包含多达300亿个参数。

研究人员指出,这类模型使用了由图像捕获对、包含图像和仅包含文本的文档组成的数据集。研究人员还声称,他们的多模态LLM(MLLM)可以计数对象,识别图像中的部分对象,并利用对日常对象的常识为用户提供有关图像呈现内容的有用信息。

研究人员还声称,他们的MLLM具有上下文学习能力,这意味着每次提问时,它不需要从头开始;它会利用当前对话中所学到的东西。该团队提供了其模型高级功能的示例——其中一个示例包括上传一张一群朋友在酒吧拿着菜单的照片,并询问模型根据菜单上列出的价格,为每个人买一瓶啤酒需要多少钱。

文章来源:https://techxplore.com/news/2024-03-apple-mm1-multimodal-llm-capable.html

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消