机器学习中如何“正确”的进行模型选择

简介

模型选择是机器学习 (ML) 工作流程不可或缺的一部分,决定着从医疗保健诊断到财务预测等各个领域的项目的成功。本文深入探讨了模型选择的细微差别、其重要性以及确保最佳性能和对现实问题的适用性所采用的方法。

模型选择的重要性

机器学习承诺的核心是能够从数据中学习并做出预测或决策,而无需针对特定任务进行明确编程。然而,这种能力取决于选择正确的模型,以准确捕捉数据的基本模式。模型的选择不仅会影响预测的准确性,还会影响 ML 解决方案的可解释性、可扩展性和运营成本。因此,模型选择不仅仅是一个技术步骤,而是一项战略决策,它使机器学习项目与业务目标、运营限制和道德标准保持一致。

模型选择标准

了解问题空间

模型选择的第一步是全面了解当前的问题,包括确定问题类型(如分类、回归、聚类)和了解数据(如规模、质量、特征)。这一步为选择一个非常适合问题性质和数据特征的模型奠定了基础。

性能指标

模型选择主要依靠性能指标来评估和比较模型。这些指标因问题类型而异(分类的准确度、精确度、召回率、F1 分数;回归的 MSE、RMSE、MAE),提供了模型性能的量化指标。不过,将这些指标与项目的实际目标结合起来至关重要,因为优化一个指标可能会导致其他指标的折衷。

计算效率

训练和部署模型的计算成本是一个重要的考虑因素,尤其是对于需要实时预测或处理大规模数据的应用而言。模型选择必须平衡计算效率与预测准确性之间的权衡,同时考虑训练时间和推理时间。

模型复杂性和可解释性

偏差-方差权衡是模型选择中的一个基本概念,复杂度高的模型可能在训练数据上表现出色,但由于过度拟合,在未知数据上表现不佳。相反,过于简单的模型可能无法捕捉潜在的模式,从而导致拟合不足。此外,对透明人工智能的需求日益增长,这就需要考虑模型的可解释性,尤其是在医疗保健和金融等领域,因为这些领域的决策过程必须是可解释和合理的。

模型选择策略

交叉验证和验证技术

交叉验证和其他验证技术是评估模型普适性不可或缺的工具。通过使用不同的数据子集进行训练和测试,这些方法可以更准确地估计模型在未见数据上的表现。

超参数调整和 AutoML

超参数调整是优化 ML 模型设置以提高性能的过程。常用的技术包括网格搜索、随机搜索和贝叶斯优化。此外,自动机器学习(AutoML)平台可简化模型选择和超参数调整,让非专业人员也能使用复杂的 ML。

集合方法

集合方法(例如 boosting、bagging 和 stacking)将多个模型结合起来,以提高预测准确性和鲁棒性。这些方法可利用模型间的多样性,实现比任何单一模型本身更好的性能。

代码

为了用完整的 Python 代码示例来演示模型选择,我们将使用一个合成数据集来解决分类问题。我们将使用 sklearn.datasets.make_classification 生成该数据集,比较多个模型,并根据通用指标对它们进行评估。最后,我们将对性能进行可视化分析。

首先,让我们生成一个合成数据集,将其分为训练集和测试集,然后开始训练和评估几个不同的模型。

1. 生成合成数据集

from sklearn.datasets import make_classification

from sklearn.model_selection import train_test_split

# Generate a synthetic dataset

X, y = make_classification(n_samples=1000, n_features=20, n_informative=2,

n_redundant=10, n_classes=2, random_state=42)

# Split dataset into training and testing

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.25, random_state=42)

2. 训练多种模型

我们将比较三种不同的模型: 逻辑回归、随机森林和支持向量机 (SVM)。

from sklearn.linear_model import LogisticRegression

from sklearn.ensemble import RandomForestClassifier

from sklearn.svm import SVC

from sklearn.metrics import accuracy_score, precision_score, recall_score, f1_score

# Initialize the models

models = {

"Logistic Regression": LogisticRegression(max_iter=1000),

"Random Forest": RandomForestClassifier(n_estimators=100),

"SVM": SVC()

}

# Dictionary to hold evaluation metrics

metrics = {"Accuracy": accuracy_score, "Precision": precision_score,

"Recall": recall_score, "F1 Score": f1_score}

# Train and evaluate models

results = {}

for name, model in models.items():

# Train model

model.fit(X_train, y_train)

# Predict on test set

y_pred = model.predict(X_test)

# Evaluate model

results[name] = {metric: metric_func(y_test, y_pred) for metric, metric_func in metrics. Items()}

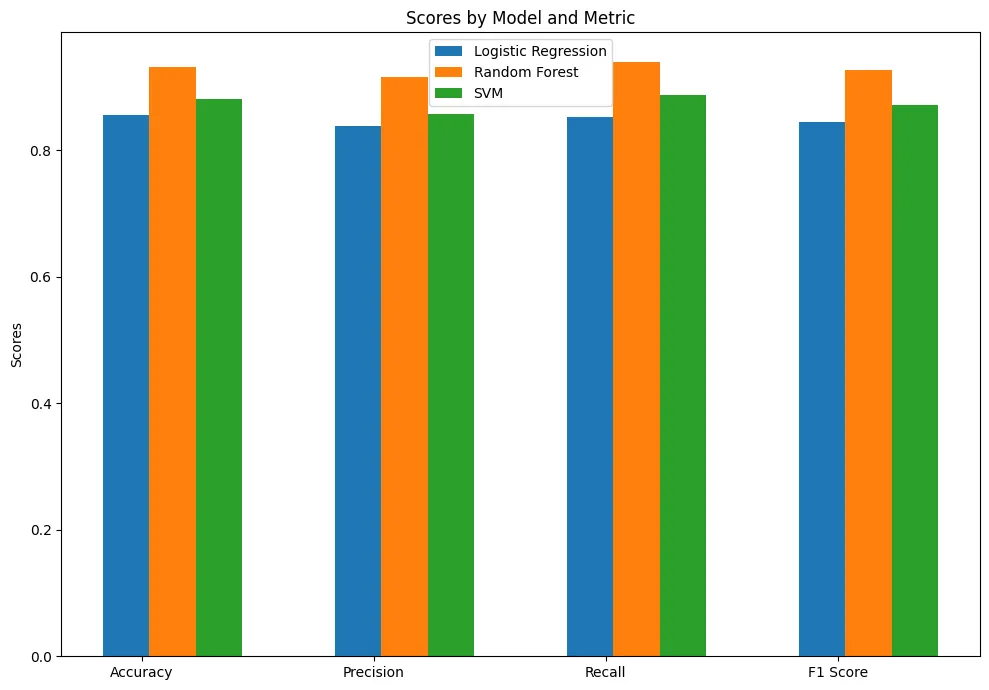

3. 模型性能可视化

最后,我们将使用 matplotlib 对合成数据集上每个模型的性能进行可视化比较分析。

import matplotlib.pyplot as plt

# Setting up the plot

fig, ax = plt.subplots(figsize=(10, 7))

width = 0.2 # Bar width

x = np.arange(len(metrics)) # The label locations

# Plotting each model's metrics

for i, (name, result) in enumerate(results.items()):

ax.bar(x + i * width, result.values(), width, label=name)

# Adding some text for labels, title, and custom x-axis tick labels, etc.

ax.set_ylabel('Scores')

ax.set_title('Scores by Model and Metric')

ax.set_xticks(x + width / len(models))

ax.set_xticklabels(metrics.keys())

ax.legend()

plt.tight_layout()

plt.show()

该代码块为每个模型的性能指标设置了一个比较条形图。通过并排显示准确率、精确度、召回率和 F1 分数,我们可以更明智地决定哪个模型在我们的合成数据集上表现最佳。值得注意的是,模型的选择在很大程度上取决于数据集和问题背景的具体特征,因此这一过程应视为迭代过程,并能适应新的信息。

结论

机器学习中的模型选择是一个多方面的过程,需要仔细考虑问题背景、数据特征、性能指标、计算资源和道德影响。通过采用系统的模型选择方法,结合验证技术、超参数调整和集合方法,实践者可以开发出稳健、高效和可解释的机器学习解决方案。最终,模型选择的目标是弥合机器学习理论模型与实际应用之间的差距,确保 ML 项目能带来实际价值,并符合更广泛的目标和限制。