用于顺序训练的模型馈送器:提高机器学习模型的效率和有效性

简介

在快速发展的机器学习领域,高效数据处理的重要性怎么强调都不为过。序列训练是这一领域的关键环节,结构良好的模型馈送系统尤其能从中获益。本文深入探讨了用于顺序训练的模型馈送器的概念,探讨了它在机器学习领域的意义、组成部分和所面临的挑战。

顺序训练中模型馈线的意义

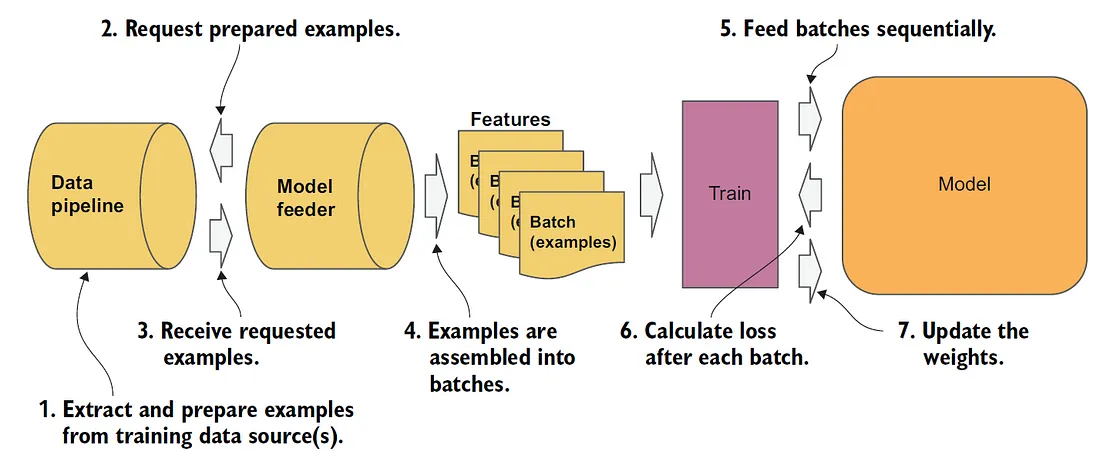

顺序训练涉及按照特定顺序处理数据,这是时间序列分析、自然语言处理和其他各种应用中的常见要求。在这些情况下,数据点的顺序不仅重要,而且对模型的准确性和性能至关重要。模型馈送器是这一过程的支柱,它能确保数据以有序、高效和有效的方式馈送到机器学习模型中。

在顺序训练中,"模型馈送器 "的概念通常是指用于将数据顺序或有序地馈送到机器学习模型中的系统或机制。这在需要按照特定顺序处理数据的场景中尤为重要,例如时间序列数据或文本数据,在这些场景中,数据点的顺序对于准确建模至关重要。

以下是顺序训练中模型馈送器的关键组成部分和注意事项:

数据预处理:

- 序列处理: 确保数据序列(如文本中的句子或时间序列中的时间步)保持正确的顺序。

- 批处理:将数据整理成批,以提高处理效率。这通常涉及填充或截断序列,以确保统一的批次大小。

- 特征工程: 从数据中提取并选择对序列模型有意义的相关特征。

数据管道:

- 流数据: 如果数据是实时流式传输的(如金融数据或实时传感器数据),模型馈送器就需要高效处理这种持续涌入的数据。

- 缓冲和缓存:为了提高性能,尤其是大型数据集的性能,可以使用缓冲和缓存机制。

与模型集成:

- 兼容性: 确保输入模型的数据格式与模型架构兼容(如神经网络输入张量的形状)。

- 动态更新: 在某些情况下,模型可能需要根据新数据进行动态更新,而无需从头开始训练过程。

处理变长序列:

- 填充和屏蔽 对于需要固定大小输入数据的模型,在训练过程中可以用零填充长度可变的序列,并进行适当的屏蔽。

效率和可扩展性:

- 并行处理: 利用多线程或分布式处理,更高效地将数据输入模型。

- 硬件优化: 调整数据馈送器,以最佳利用 GPU 或 TPU 等可用硬件资源。

错误处理和质量检查:

- 数据验证: 确保输入数据的质量,防止模型受到污染。

- 错误恢复: 从数据馈送过程中的错误中恢复或从容处理错误的机制。

监控和日志记录:

- 性能指标: 监控数据馈送过程的吞吐量和延迟。

- 日志记录: 保存日志,用于调试和性能调整。

在实践中,TensorFlow 或 PyTorch 等框架提供的工具和功能大大简化了用于顺序训练的模型馈送器的实现,包括批处理、填充和与神经网络架构集成的实用程序。

模型馈送器的核心组件

- 数据预处理: 这一初始阶段涉及为训练准备序列数据。技术包括保持数据序列的完整性、批处理(将数据分组为易于管理的数据集)以及提取相关信息的特征工程。

- 数据管道构建: 稳健的数据管道对于处理流式数据至关重要,尤其是在实时场景中。采用有效的缓冲和缓存策略可提高性能,尤其是在处理大型数据集时。

- 与机器学习模型集成: 模型馈送器必须确保与模型架构的兼容性。这包括格式化数据以符合模型的输入要求,并可能在新数据到达时动态更新模型。

- 处理变长序列: 在许多序列模型中,数据点的长度可能各不相同。填充(添加零使序列一致)和屏蔽(在训练过程中忽略这些零)等技术至关重要。

- 效率和可扩展性: 任何模型馈送器的关键都在于其高效处理数据的能力。这包括利用并行处理、针对特定硬件进行优化,以及确保可扩展性以处理大型数据集。

- 错误处理和数据质量: 确保输入数据的质量对于防止模型污染至关重要。有效的错误处理和恢复机制对于保持训练过程的完整性至关重要。

- 监测和日志记录: 跟踪性能指标和维护详细日志对于调试和改进数据馈送过程至关重要。

模型馈送器应对的挑战

模型馈送器解决了顺序训练中的几个难题:

- 数据复杂性: 它们可以管理顺序数据的复杂性,确保固有的顺序和结构得以保持。

- 资源优化: 促进计算资源的有效利用,增强整个训练过程。

- 动态数据处理: 它们能适应不断变化的数据模式,尤其是在实时流场景中。

- 可扩展性: 模型馈送器能够处理大型数据集,这是许多机器学习应用中的共同挑战。

代码

为顺序训练中的模型馈送器创建完整的 Python 代码涉及多个步骤,包括生成合成数据集、将数据馈送到模型中以及绘制结果图。让我们分解这些步骤并提供一个综合示例。为此,我们将使用一个简单的递归神经网络(RNN),因为 RNN 通常用于序列数据。

- 生成合成数据集: 我们将创建一个简单的时间序列数据集。

- 构建模型馈送器: 这将包括数据预处理和批处理。

- 定义序列模型: 本例中我们将使用 RNN 模型。

- 训练模型: 我们将在合成数据集上训练模型。

- 绘制结果图: 显示训练结果。

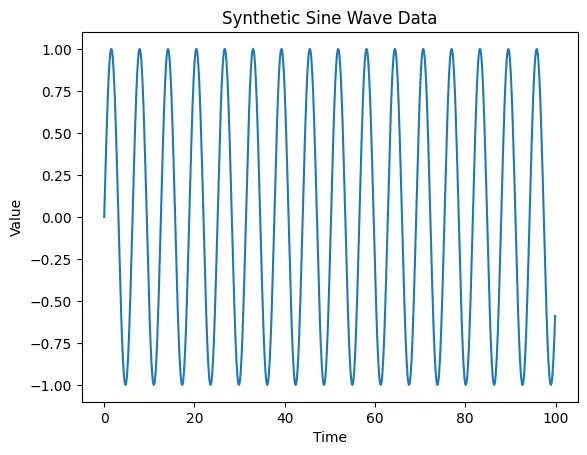

首先,让我们创建一个合成数据集。我们将生成正弦波时间序列数据,这是合成序列数据集的常见选择。

import numpy as np

import matplotlib.pyplot as plt

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import SimpleRNN, Dense

from tensorflow.keras.preprocessing.sequence import TimeseriesGenerator

# Generate synthetic data - Sine Wave

time = np.arange(0, 100, 0.1)

data = np.sin(time)

# Plot the synthetic data

plt.plot(time, data)

plt.title("Synthetic Sine Wave Data")

plt.xlabel("Time")

plt.ylabel("Value")

plt.show()

def create_dataset(data, sequence_length=10):

generator = TimeseriesGenerator(data, data, length=sequence_length, batch_size=1)

return generator

sequence_length = 10

dataset = create_dataset(data, sequence_length)

def build_model(input_shape):

model = Sequential()

model.add(SimpleRNN(50, activation='relu', return_sequences=True, input_shape=input_shape))

model.add(SimpleRNN(50, activation='relu'))

model.add(Dense(1))

model.compile(optimizer='adam', loss='mse')

return model

model = build_model((sequence_length, 1))

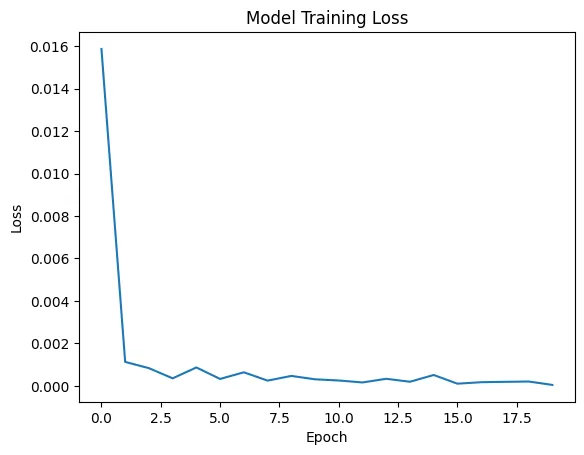

history = model.fit(dataset, epochs=20, verbose=1)

plt.plot(history.history['loss'])

plt.title("Model Training Loss")

plt.xlabel("Epoch")

plt.ylabel("Loss")

plt.show()

Epoch 1/20

990/990 [==============================] - 8s 6ms/step - loss: 0.0159

Epoch 2/20

990/990 [==============================] - 7s 7ms/step - loss: 0.0011

Epoch 3/20

990/990 [==============================] - 6s 6ms/step - loss: 8.3596e-04

Epoch 4/20

990/990 [==============================] - 6s 6ms/step - loss: 3.5654e-04

Epoch 5/20

990/990 [==============================] - 6s 6ms/step - loss: 8.6900e-04

Epoch 6/20

990/990 [==============================] - 6s 6ms/step - loss: 3.2865e-04

Epoch 7/20

990/990 [==============================] - 6s 6ms/step - loss: 6.4090e-04

Epoch 8/20

990/990 [==============================] - 6s 6ms/step - loss: 2.4975e-04

Epoch 9/20

990/990 [==============================] - 6s 6ms/step - loss: 4.7050e-04

Epoch 10/20

990/990 [==============================] - 7s 7ms/step - loss: 3.1094e-04

Epoch 11/20

990/990 [==============================] - 6s 6ms/step - loss: 2.5507e-04

Epoch 12/20

990/990 [==============================] - 7s 7ms/step - loss: 1.6318e-04

Epoch 13/20

990/990 [==============================] - 7s 7ms/step - loss: 3.3521e-04

Epoch 14/20

990/990 [==============================] - 6s 6ms/step - loss: 1.9582e-04

Epoch 15/20

990/990 [==============================] - 6s 6ms/step - loss: 5.1452e-04

Epoch 16/20

990/990 [==============================] - 6s 6ms/step - loss: 1.0510e-04

Epoch 17/20

990/990 [==============================] - 6s 6ms/step - loss: 1.7497e-04

Epoch 18/20

990/990 [==============================] - 7s 7ms/step - loss: 1.9253e-04

Epoch 19/20

990/990 [==============================] - 6s 6ms/step - loss: 2.0740e-04

Epoch 20/20

990/990 [==============================] - 7s 7ms/step - loss: 4.6815e-05

本代码提供了一个基本框架,用于创建模型馈线,以便使用合成数据集进行顺序训练。根据实际数据集和模型要求的复杂程度,你可能需要调整和扩展本示例。

结论

顺序训练中的模型馈送器对机器学习模型的成功起着至关重要的作用。通过有效管理数据流、确保数据质量并保持与模型架构的兼容性,模型馈送器极大地促进了机器学习算法的准确性和性能。随着数据量和复杂性的不断增长,模型馈送器的作用将变得越来越关键,推动机器学习领域及其无数应用的进步。