模型探索计算机视觉中语义分割的基础和应用

介绍

在计算机视觉中,语义分割是一个引人入胜且迅速发展的领域。它涉及将图像划分为有意义的部分,并将每个部分分类到预定义的类别中。本文将探讨在计算机视觉领域中,语义分割的重要性、技术、应用、挑战以及未来前景。

语义分割的意义

语义分割在计算机视觉中扮演着关键角色,它使机器能够在精细的层次上理解和解释图像内容。不同于仅识别和定位图像中的对象的目标检测,语义分割更进一步,通过在像素级别上对图像进行分割。这种精确度允许对场景进行更详细和全面的理解,这在自动驾驶、医学成像和环境监测等应用中至关重要。

技术和算法

语义分割技术的发展与深度学习的进步紧密相连。卷积神经网络(CNNs)已成为这个领域的基石。早期方法如全卷积网络(FCNs)证明了CNNs可以适用于像素级分类。这之后,出现了更复杂的架构,比如专为医学图像分割设计的U-Net,以及结合了空洞卷积和完全连接的条件随机场(CRFs)以实现更精确分割的DeepLab。

在各个领域的应用

语义分割在许多领域都找到了应用。在自动驾驶汽车中,它有助于理解道路场景,包括识别车道、行人和其他车辆。在医疗保健中,它有助于医学扫描的精确分析,从而实现更好的诊断和治疗规划。在农业中,可以用于作物分析和监测。在城市规划和环境监测中,语义分割有助于分析卫星和航空图像,进行土地利用分类和变化检测。

挑战和限制

尽管语义分割取得了进步,但仍面临着几个挑战。一个主要的挑战是需要大量注释过的数据集来训练深度学习模型。逐像素注释图像是耗时且劳动强度大的工作。另一个挑战是处理现实世界场景中的变化照明条件、遮挡以及多样化的背景。此外,在不同领域之间模型的泛化仍然是一个重大的障碍。

未来展望

语义分割的未来与人工智能和深度学习的持续发展息息相关。转移学习和半监督学习方法正被探索用来解决数据稀缺问题。将语义分割与其他计算机视觉任务(如对象检测和深度估计)整合也是一个活跃研究领域。此外,硬件的进步,如GPU和TPU,正使得处理变得更快和更有效,为实时应用打开了新的可能性。

代码

创建一个完整的Python语义分割代码涉及几个步骤:安装库、加载数据集、定义模型、训练和可视化结果。为了简单易用,我们将使用TensorFlow及其高级Keras API,以及像CIFAR10这样的标准数据集。

第一步:安装必要的库

首先,确保安装了TensorFlow。你可以通过pip安装:

pip install tensorflow

第二步:加载和准备数据集

CIFAR10是一个包含10个类别的60,000张32x32彩色图像的数据集。我们将使用它,因为它简单,虽然它并不是用于语义分割的典型数据集。

import tensorflow as tf

from tensorflow.keras.datasets import cifar10

from tensorflow.keras.utils import to_categorical

# Load the dataset

(train_images, train_labels), (test_images, test_labels) = cifar10.load_data()

# Normalize pixel values

train_images, test_images = train_images / 255.0, test_images / 255.0

# Convert labels to one-hot encoded

train_labels = to_categorical(train_labels)

test_labels = to_categorical(test_labels)

第三步:定义语义分割模型

我们将为这项任务定义一个简单的CNN。在真实世界的场景中,你会使用更复杂的架构,如U-Net或DeepLab。

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Conv2D, MaxPooling2D, UpSampling2D, Flatten, Dense

def create_model():

model = Sequential([

Conv2D(32, (3, 3), activation='relu', input_shape=(32, 32, 3)),

MaxPooling2D((2, 2)),

Conv2D(64, (3, 3), activation='relu'),

UpSampling2D((2, 2)),

Flatten(),

Dense(64, activation='relu'),

Dense(10, activation='softmax') # 10 classes in CIFAR10

])

model.compile(optimizer='adam',

loss='categorical_crossentropy',

metrics=['accuracy'])

return model

model = create_model()

第四步:训练模型

在CIFAR10数据上训练模型。

history = model.fit(train_images, train_labels, epochs=10, validation_data=(test_images, test_labels))

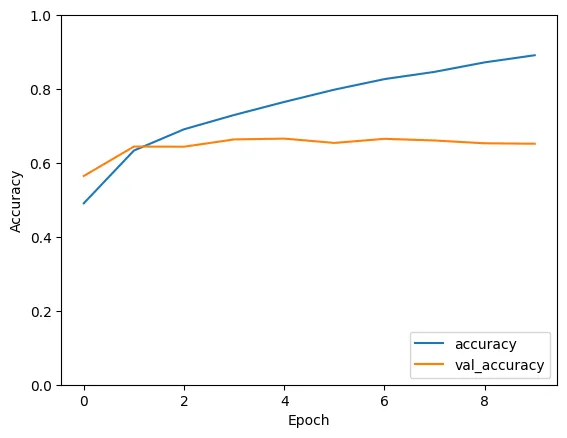

第五步:可视化结果

绘制训练历史数据。

import matplotlib.pyplot as plt

plt.plot(history.history['accuracy'], label='accuracy')

plt.plot(history.history['val_accuracy'], label = 'val_accuracy')

plt.xlabel('Epoch')

plt.ylabel('Accuracy')

plt.ylim([0, 1])

plt.legend(loc='lower right')

plt.show()

Epoch 1/10

1563/1563 [==============================] - 226s 144ms/step - loss: 1.4284 - accuracy: 0.4909 - val_loss: 1.2385 - val_accuracy: 0.5648

Epoch 2/10

1563/1563 [==============================] - 159s 102ms/step - loss: 1.0429 - accuracy: 0.6336 - val_loss: 1.0144 - val_accuracy: 0.6444

Epoch 3/10

1563/1563 [==============================] - 133s 85ms/step - loss: 0.8852 - accuracy: 0.6911 - val_loss: 1.0305 - val_accuracy: 0.6440

Epoch 4/10

1563/1563 [==============================] - 135s 86ms/step - loss: 0.7708 - accuracy: 0.7298 - val_loss: 1.0021 - val_accuracy: 0.6637

Epoch 5/10

1563/1563 [==============================] - 129s 83ms/step - loss: 0.6701 - accuracy: 0.7651 - val_loss: 1.0023 - val_accuracy: 0.6659

Epoch 6/10

1563/1563 [==============================] - 128s 82ms/step - loss: 0.5778 - accuracy: 0.7983 - val_loss: 1.1584 - val_accuracy: 0.6542

Epoch 7/10

1563/1563 [==============================] - 129s 83ms/step - loss: 0.4965 - accuracy: 0.8269 - val_loss: 1.1701 - val_accuracy: 0.6653

Epoch 8/10

1563/1563 [==============================] - 132s 85ms/step - loss: 0.4357 - accuracy: 0.8465 - val_loss: 1.2827 - val_accuracy: 0.6608

Epoch 9/10

1563/1563 [==============================] - 128s 82ms/step - loss: 0.3665 - accuracy: 0.8721 - val_loss: 1.3547 - val_accuracy: 0.6532

Epoch 10/10

1563/1563 [==============================] - 134s 86ms/step - loss: 0.3098 - accuracy: 0.8915 - val_loss: 1.5152 - val_accuracy: 0.6520

- 此代码是一个基础演示,使用的是分类模型,而不是真正的语义分割模型,这是由于CIFAR10数据集的性质所致。在真正的语义分割任务中,图像中的每个像素都被分类,往往需要更复杂的模型和专门为分割标注的数据集(如PASCAL VOC或MS COCO)。

- 对于真正的语义分割任务,考虑使用像U-Net、FCN或DeepLab这样的架构,以及图像中每个像素都有对应类标签的数据集。

- 提供的代码是为了教育目的而简化的,对于实际和更复杂的现实世界应用可能需要调整。

结论

语义分割是计算机视觉的一个关键组成部分,它为图像分析提供了详细和丰富上下文的分析。它在各种行业中的应用展示了其多功能性和潜力。尽管它面临挑战,但持续的研究和技术进步承诺将克服这些障碍,使语义分割成为计算机视觉技术武库中更加强大的工具。随着这个领域的不断发展,它无疑将解锁新的能力和应用,进一步缩小人类和机器视觉之间的差距。