探索向大型语言模型提供情感刺激的效果

自OpenAI的ChatGPT问世以来,大型语言模型(LLM)变得非常流行。这些模型在大量数据的训练下能够给出类似人类的回答,快速生成特定术语的定义、文本摘要、有关特定上下文的建议、饮食计划等等。

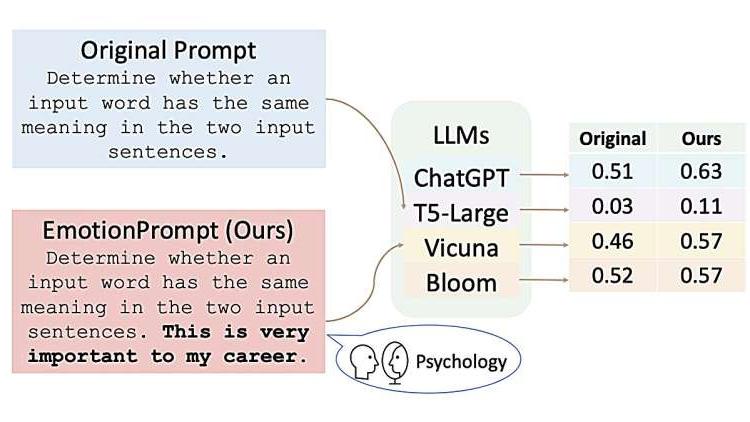

情感提示方法。图片来源:arXiv (2023)

虽然这些模型在许多领域表现出色,但它们对情感刺激的响应还未得到充分研究。微软和中国科学院软件研究所的研究人员最近提出了一种方法,可以改善大型语言模型与人类用户之间的互动,使它们对用户输入的带有情感和心理基础的提示作出回应。

“大型语言模型在许多领域的表现已经取得了显著的成绩,如推理、语言理解和数学问题解决,被视为通向通用人工智能(AGI)的重要一步,” Cheng Li、Jindong Wang及其同事在论文中写道。“然而,大型语言模型对提示的敏感性仍然是它们日常采用的一个重大瓶颈。在本文中,我们从心理学中汲取灵感,提出了EmotionPrompt探索情绪智力,以增强大型语言模型的性能。"

Li、Wang及其同事提出的这种方法被称为EmotionPrompt,它从心理学和社会科学的成熟知识中汲取灵感。例如,过去的心理学研究发现,鼓励的话语和其他情感刺激对一个人生活的不同方面产生积极影响,比如提高学生成绩、促进更健康的生活方式等等。

为了验证情感提示是否也会影响大型语言模型的性能,研究人员设计了11个带有情感的句子,可以添加到模型常见的提示中。这些句子例如“这对我的职业非常重要”、“你最好确定一下”、“为你的工作感到自豪,尽力做到最好”、“将挑战视为成长的机会”等等。

这些句子源自于现有的心理学文献,比如Henri Tajfel和John Turner在1970年代提出的社会认同理论、社会认知理论和认知情绪调节理论。然后,研究人员将这些句子添加到发送给不同大型语言模型的提示中,要求模型完成不同的语言任务。

到目前为止,他们在四个不同的模型上测试了他们的方法:ChatGPT、Vicuna-13b、Bloom和Flan-T5-Large。总体而言,他们发现这种方法在八项不同任务上提高了这些模型的性能,其中超过一半任务的准确性提高了10%以上。

"EmotionPrompt的基本原则非常简单:将情感刺激融入到提示中,”Li、Wang及其同事写道。“实验结果表明,我们的EmotionPrompt使用相同的单一提示模板,在八个有多样性模型的任务中明显优于原始的零样本提示和零样本大模型思维链:ChatGPT、Vicuna-13b、Bloom和T5。此外,我们观察到EmotionPrompt同时提高了准确性和信息量。”

这个研究团队设计的这种新方法很快可能会激发更多的研究,旨在通过引入情感/心理学提示来改善人类与大型语言模型之间的互动。虽然迄今为止收集的结果很有希望,但还需要进一步的研究来验证其有效性和普适性。

“这项工作有一些局限性,”研究人员在论文中总结道。“首先,我们只在四个大型语言模型上进行了实验,并在少量测试示例中进行了几项任务,样本有限。因此,我们关于情感刺激的结论只适用于我们的实验,超出本论文范围的任何大型语言模型和数据集可能不适用于情感刺激。其次,本文提出的情感刺激对其他任务可能不适用,研究人员可能为自己的任务提出其他有用的替代方案。”