将大型语言模型的回答与现实联系在一起的新技术

2023年08月02日 由 daydream 发表

75983

0

向ChatGPT寻求答案是有风险的,它可能会为你提供听起来合法的完全虚构的“事实”。尽管已经接受了大量事实数据的训练,但大型语言模型容易产生称为幻觉的虚假信息。

当LLM在被要求生成他们所了解甚少的主题的文本时,或者当他们错误地混合来自不同来源的信息时,就可能发生这种情况。

"想象一下使用手机的自动完成功能来完成句子'My favorite restaurant is...'。你可能最终得到一些看起来合理但不一定准确的文本"惠廷工程学院计算机科学系的博士三年级候选人Marc Marone解释道。

Marone和一组研究人员,其中包括候选人Orion Weller和Nathaniel Weir以及顾问Benjamin Van Durme(计算机科学副教授,语言和语音处理中心成员)、Dawn Lawrie(人类语言技术卓越中心的高级研究科学家)和Daniel Khashabi(计算机科学助理教授,同时也是CLSP成员)。他们开发了一种减少LLM产生幻觉可能性的方法。

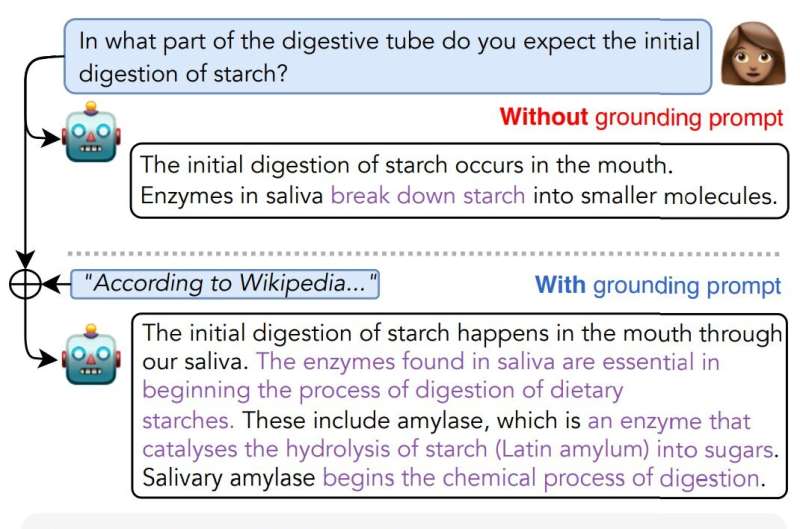

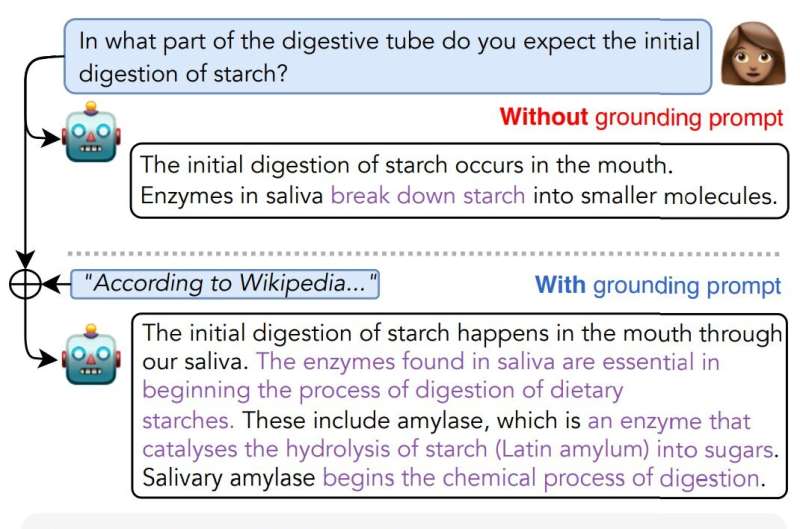

受到新闻中常用的短语启发,研究人员对加入“according to”这些词在LLM查询中的影响进行了研究。

他们发现,“according to”提示能够成功地引导语言模型将其回答与先前观察到的文本进行关联;该团队表示,与其产生错误的答案,模型更有可能直接引用所要求的来源 - 就像记者一样。

Weller解释说:"语言模型在遵循句法和语义提示方面非常出色。由于在新闻文章引用来源时“according to”更容易出现在在线上,LLM可能会将提示视为从训练数据中专门搜索引语的线索。"

通过使用Data Portraits,Marone和Van Durme先前开发的一种工具,可以快速确定特定内容是否存在于训练数据集中,而无需下载大量文本,研究团队验证了LLM的回答是否能在其原始训练数据中找到。换句话说,他们能够确定模型是在凭空编造还是基于已经学到的数据生成答案。

研究团队将这一指标称为“QUIP-Score”,即引用信息准确性,当查询使用“According to Wikipedia…”等引导提示时,这一指标的提高了5%至15%。实际上,添加一个引导提示,鼓励模型从高质量的来源提取信息,既提高了模型引用文本的能力,也增加了其整体答案的详细性和准确性。

“我们正在寻求通过让LLM直接从他们在培训期间看到的基础可信资源中引用来改善知识基础”Khashabi解释说。“我们的目标是让模型访问有用的内容,例如从高质量或可信文档中记住的字符串。

虽然这听起来像虚拟助手所做的事情,但Hopkins团队的实现方法有一个关键的区别:LLM无法访问互联网。相反,它必须完全通过自己的内隐知识来回答问题——这是通过之前观察到的句子所学习到的分布——而没有来自实时搜索的额外数据。”

研究团队表示,“according to”提示技巧适用于各种类型的LLM,无需人工调整。然而,他们声称它在与更大的模型和指令调整同时使用时最为成功,指令调整是指在典型的问答对之外,还使用了类似“用正确答案回答问题”的指令对模型进行训练。

Weller表示:“还需注意的是,模型生成的文本虽然可能存在于维基百科或其他指定的来源中,但这并不意味着其对所提问题的回答就是正确的。”

最终,模型回答的准确性仍取决于其训练所使用数据的质量,这就是为什么研究团队考虑了过滤来自不可靠网站的信息的能力。

Weir说:“测试表明,可以在查询中明确加上‘不引用XYZ.com’,而ChatGPT会遵守这一要求,这进一步证明了它对理解引导指令的能力。”

Van Durme补充说:“我们的方法并不是完全解决方案,但它是朝向通过帮助模型使用其从训练数据中学到的知识来帮助LLM生成更多实际和正确信息的一步。”

来源:https://techxplore.com/news/2023-08-fake-facts-words-technique-ground.html

当LLM在被要求生成他们所了解甚少的主题的文本时,或者当他们错误地混合来自不同来源的信息时,就可能发生这种情况。

"想象一下使用手机的自动完成功能来完成句子'My favorite restaurant is...'。你可能最终得到一些看起来合理但不一定准确的文本"惠廷工程学院计算机科学系的博士三年级候选人Marc Marone解释道。

Marone和一组研究人员,其中包括候选人Orion Weller和Nathaniel Weir以及顾问Benjamin Van Durme(计算机科学副教授,语言和语音处理中心成员)、Dawn Lawrie(人类语言技术卓越中心的高级研究科学家)和Daniel Khashabi(计算机科学助理教授,同时也是CLSP成员)。他们开发了一种减少LLM产生幻觉可能性的方法。

受到新闻中常用的短语启发,研究人员对加入“according to”这些词在LLM查询中的影响进行了研究。

他们发现,“according to”提示能够成功地引导语言模型将其回答与先前观察到的文本进行关联;该团队表示,与其产生错误的答案,模型更有可能直接引用所要求的来源 - 就像记者一样。

Weller解释说:"语言模型在遵循句法和语义提示方面非常出色。由于在新闻文章引用来源时“according to”更容易出现在在线上,LLM可能会将提示视为从训练数据中专门搜索引语的线索。"

通过使用Data Portraits,Marone和Van Durme先前开发的一种工具,可以快速确定特定内容是否存在于训练数据集中,而无需下载大量文本,研究团队验证了LLM的回答是否能在其原始训练数据中找到。换句话说,他们能够确定模型是在凭空编造还是基于已经学到的数据生成答案。

研究团队将这一指标称为“QUIP-Score”,即引用信息准确性,当查询使用“According to Wikipedia…”等引导提示时,这一指标的提高了5%至15%。实际上,添加一个引导提示,鼓励模型从高质量的来源提取信息,既提高了模型引用文本的能力,也增加了其整体答案的详细性和准确性。

“我们正在寻求通过让LLM直接从他们在培训期间看到的基础可信资源中引用来改善知识基础”Khashabi解释说。“我们的目标是让模型访问有用的内容,例如从高质量或可信文档中记住的字符串。

虽然这听起来像虚拟助手所做的事情,但Hopkins团队的实现方法有一个关键的区别:LLM无法访问互联网。相反,它必须完全通过自己的内隐知识来回答问题——这是通过之前观察到的句子所学习到的分布——而没有来自实时搜索的额外数据。”

研究团队表示,“according to”提示技巧适用于各种类型的LLM,无需人工调整。然而,他们声称它在与更大的模型和指令调整同时使用时最为成功,指令调整是指在典型的问答对之外,还使用了类似“用正确答案回答问题”的指令对模型进行训练。

Weller表示:“还需注意的是,模型生成的文本虽然可能存在于维基百科或其他指定的来源中,但这并不意味着其对所提问题的回答就是正确的。”

最终,模型回答的准确性仍取决于其训练所使用数据的质量,这就是为什么研究团队考虑了过滤来自不可靠网站的信息的能力。

Weir说:“测试表明,可以在查询中明确加上‘不引用XYZ.com’,而ChatGPT会遵守这一要求,这进一步证明了它对理解引导指令的能力。”

Van Durme补充说:“我们的方法并不是完全解决方案,但它是朝向通过帮助模型使用其从训练数据中学到的知识来帮助LLM生成更多实际和正确信息的一步。”

来源:https://techxplore.com/news/2023-08-fake-facts-words-technique-ground.html

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消