Captum——新的人工智能可解释性工具

2019年10月11日 由 TGS 发表

978481

0

可解释性,即理解人工智能模型为什么做出决定的能力,对于开发人员解释模型为什么做出某个决定是很重要的。它可以使人工智能符合监管法律,以应用于需要解释性的业务。

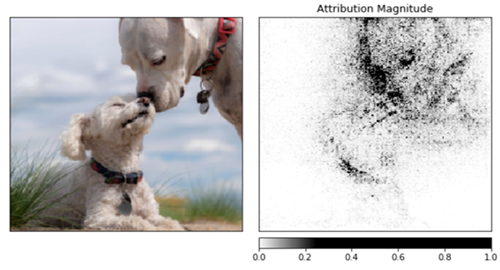

可解释性,即理解人工智能模型为什么做出决定的能力,对于开发人员解释模型为什么做出某个决定是很重要的。它可以使人工智能符合监管法律,以应用于需要解释性的业务。Facebook今天推出了一个用深度学习框架PyTorch解释神经网络决策的工具——Captum。Captum旨在实现AI模型的最新版本,如集成梯度、深度弯曲和传导等等,它可以帮助研究人员和开发人员解释人工智能在多模态环境中做出的决策,并能帮助研究人员把结果与数据库中现有的模型进行比较。

开发人员还可以使用Captum来理解特性的重要性,或者深入研究神经网络来理解神经元和层属性。Captum将与结果的可视化表示工具Captum Insights一同发布,Facebook在一篇博客文章中说:

Insights推出即支持集成渐变,不久后还会支持更多的模型。

Pythorch产品经理Joe Spisak在接受VentureBeat Ina电话采访时说:“其他一些图书馆更注重背景,但却无法帮助解决深入学习解释模型实际想法的难题,尤其是在涉及到多模态技术问题的时候。”

Pythorch产品经理Joe Spisak在接受VentureBeat Ina电话采访时说:“其他一些图书馆更注重背景,但却无法帮助解决深入学习解释模型实际想法的难题,尤其是在涉及到多模态技术问题的时候。”Spisak表示,在开源之前,Captum仅在Facebook内部使用,被用来更好地理解在多模态环境下做出的决定。他说:

“你可以浏览任何一个Facebook页面,它有文本,有音频,有视频和链接,还有很多不同类型的模式。所以,我们基本上是从这个前提开始的,我们想知道,为什么模型会预测到预测出的东西,我们想用一种视觉化的方式,给用户一种直觉,以及具体的统计数据和信息,让用户可以自信的解释,人工智能模型为什么会做出某种预测。”

今年夏天,在与VentureBeat的Kyle Wiggers的对话中,OpenAI的首席技术官Greg Brockman和首席科学家Ilya Sutskever建议,未来的模型制作,应该通过可解释性和理性来获得信息。

可解释工具的发展,会帮助人工智能解决法律上的监管问题,并获得社会的广泛信任,从而间接推动人工智能技术的发展,加快人工智能产品技术的落地。除了Facebook 的Captum,今年发布的其他帮助解释人工智能推断的工具,还有IBM推出的AI Explainability 360工具包,以及微软在5月份发布的expltml。

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消