一文全面了解反向强化学习

2019年01月05日 由 浅浅 发表

665238

0

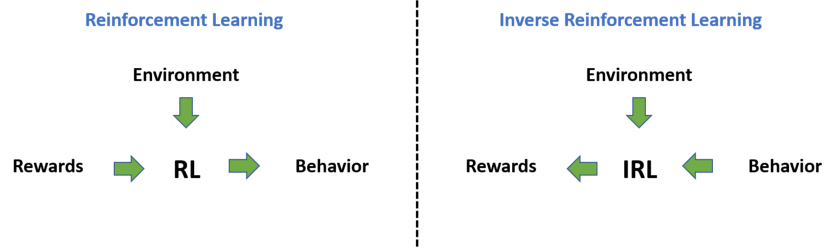

反向强化学习(IRL)是近年来发展起来的一种能够解决RL逆问题的机器学习框架。简而言之,IRL就是向人类学习,它通过观察个体的行为来学习其目标、价值或奖励的领域。

反向强化学习(IRL)是近年来发展起来的一种能够解决RL逆问题的机器学习框架。简而言之,IRL就是向人类学习,它通过观察个体的行为来学习其目标、价值或奖励的领域。Johannes Heidecke说:“我们可能会观察人类在某些特定任务中的行为,了解人类正在努力实现的环境状态,以及具体目标可能是什么。”

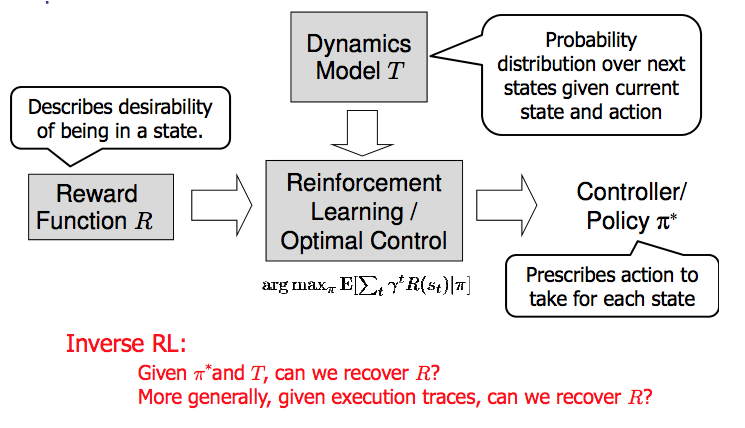

IRL是一种依赖马尔可夫决策过程(MDP)的范例,其中智能体的目标是从专家演示中找到可以解释专家行为的奖励函数。

如果有一天某些AI能力超过人类,IRL可能是一种理解人类想要什么的方法,并有望朝着这些目标努力。

奖励函数

Jordan Alexander指出,“目标是学习决策过程以产生行为,最大化某些预定义奖励函数。基本上,我们的目标是从被观察到的行为中提取奖励函数。

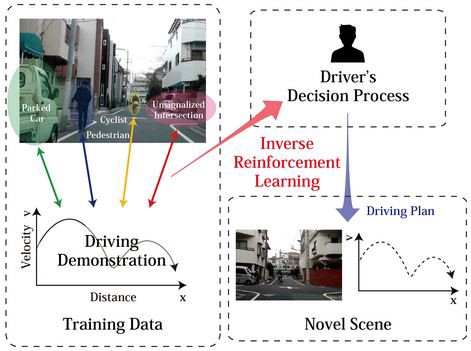

例如,考虑自动驾驶的任务,一种方法是创建一个奖励函数,捕捉所需的驾驶员的行为,如停在红灯处,避开行人等。但是,这需要详尽列出我们想要考虑的每一个行为,以及一系列权重,描述每种行为的重要性。”

AI研究员Prasanth Omanakuttan说:“通过IRL,任务是获取一组人为生成的驾驶数据,并为该任务提取人类奖励函数的近似值。尽管如此,解决问题所需的大部分信息都是在真实奖励函数的近似值内捕获的。一旦我们有了正确的奖励函数,问题就可以简化为找到正确的策略,并可以用标准的强化学习方法来解决。”

将复杂任务转换为简单奖励函数时的主要问题是,给定策略对于许多不同的奖励函数可能是最佳的。也就是说,即使有来自专家的行动,也存在许多不同的奖励功能,专家可能试图最大化。——斯坦福大学Jordan Alexander《向人类学习:什么是反向强化学习?》

Bilal Piot,Matthieu Geist和Olivier Pietquin表示:“换句话说,我们的目标是模拟智能体在特定环境中采取行动。因此,我们假设我们有一个状态空间 S(代理和环境可以处于的状态集),一个动作空间 A(代理可以采取的一组动作)和一个转换函数T(s'| s,a),它给出了在采取行动a时,从状态s移动到状态s'的概率。”

例如,AI学习控制汽车这一例子中,状态空间将是汽车的可能位置和方向,动作空间将是AI可以发送给汽车的一组控制信号,并且过渡功能将是是汽车的动力学模型。(S,A,T)的元组称为MDP∖R,它是没有奖励函数的马尔可夫决策过程。

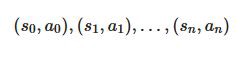

IRL的推理问题是推断给定最优策略π*的奖励函数R:对于MDP∖R,是S→A。我们从状态的样本(s,a)中了解策略π*,根据π*(可以是随机的)了解相应动作。通常,这些样本来自一个轨迹,该轨迹记录了单个事件中智能体的状态和动作的完整历史记录:

在上述汽车示例中,这相当于一个人类司机所采取的行动,他正在演示所期待的驾驶行为(这些行动将被记录为给方向盘、刹车等的信号)

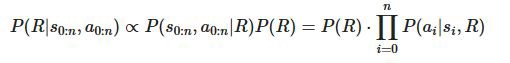

给定MDP∖R和观察到的轨迹,目标是在贝叶斯框架中推断出奖励函数R,如果我们在R上指定先验,则:

似然P(ai | si,R)只是πR(s)[ai],其中πR是奖励函数R下的最优策略。注意,给出奖励计算最优策略通常是不平凡的,除非情况简单,我们通常使用强化学习来近似策略。由于指定先验,计算最优政策和整合奖励函数的挑战,IRL大多数都使用某种近似贝叶斯目标的方法。

奖励信号

Johannes Heidecke表示,在大多数强化学习任务中,奖励信号没有自然来源。相反,它必须手工制作并精心设计,以准确地表示任务。

通常,有必要手动调整RL智能体的奖励,直到观察到所需的行为。为某个目标找到一个合适的奖励函数的更好的方法可能是观察执行任务的专家,然后从这些观察中自动提取相应的奖励。

IRL的最大动机源于手动为任务指定奖励函数通常非常困难。

数据中的人类行为

Johannes Steinhardt指出,IRL是一种很有前途的学习人类价值观的方法,部分原因是数据易于获取。对于监督学习,人类需要产生许多专门用于任务的标记实例。相比之下,IRL是一种无监督或半监督的方法,其中任何人类行为记录都是潜在的数据来源。Facebook的用户行为记录,YouTube视频等提供了许多人类行为的数据点。

然而,尽管有许多现有数据可以提供有关人类偏好的信息,但使用现有技术很难利用这些数据进行IRL。

策划数据

Johannes Steinhardt提到的另一个要素是数据问题。他说:“IRL算法难以使用书籍和视频中的人类行为记录。然而,来自Facebook的数据看起来很有希望,我们可以存储状态和每个行动(如点击和滚动)。虽然这涵盖了广泛的任务,但存在明显的局限性:从计算机上的行为来看,某些人的偏好似乎很难学习。”

信息和偏见

人类行为取决于他们的偏好和信仰。

Owain Evans和Johannes Steinhardt说,这些信仰与偏好一样,不能被直接观察到。对于狭隘的任务(例如,人们从显示器中选择他们喜欢的照片),我们可以将人类建模为完全了解状态。

但对于大多数现实世界的任务,人类信息有限,信息随时间而变化。如果IRL假定人类拥有完整的信息,那么模型就会被错误指定,并且在其他场景中对人类偏好的内容进行概括可能是错误的。这里有些例子:

- 有人从家走到一家已关门的餐馆。如果有充分的知识,那么IRL会推断出另一种偏好(例如散步),而不是获得食物。

- 假设IRL算法通过笔记本电脑上的按键来推断一个人的目标。这个人总是忘记登录密码,必须重置密码。使用POMDP风格的模型很难捕获这种行为:人类忘记了一些特定字符串。IRL可能会推断该人打算重置密码。

以上是人类遗忘信息的原因,即使信息只是一串简短的字符。这是人类系统地偏离理性贝叶斯智能体的一种方式。

长期计划

Owain Evans和Johannes Steinhardt给出的另一个要素是长期计划。事实上,他们认为为了实现一个长期的目标,代理人通常会采取一系列的行动,而这些行动会给他们带来负面的效用。由于一些原因,这样的长期计划会使IRL更加困难。让我们关注两个问题:

- IRL系统可能无法访问正确类型的数据以了解长期目标;

- 需要预测长序列的动作会使算法在模型不规范的情况下更加脆弱。

第一个问题,为了在长期计划的基础上做出推断,拥有关于单个智能体在很长一段时间内、行为一致的数据是很有帮助的。但在实践中,我们可能会有大量的数据,包括不同智能体的快照。

另一方面,有些服务在很长一段时间内都有关于个人用户的大量数据。但是,这个数据有另一个问题:以系统的角度来说,它是不完整的(因为它只跟踪在线行为)。

例如,有人可能会在大多数时间上网阅读课程笔记和维基百科上课,这是可能被记录的数据。但是,不太可能有人记录该人参加期末考试,通过课程,根据他们的班级表现获得实习机会。当然,根据一些人的电子邮件记录,这些序列的某些部分可以被推断,但是相对于维基百科使用记录,它可能在数据中代表性不足。

在这两种情况下,都需要一些重大的推理来理解这些数据。

接下来,我们讨论另一个潜在的问题:模拟错误指定的脆弱性。

假设有人花了99天做一个无聊的任务,在第100天完成了一个重要的目标。如果一个系统能预测出一个人天生喜欢做无聊的事情,那么它99%的时候都是正确的。当然,一个了解目标以及任务如何实现目标的系统100%正确,但即使是理解上的微小错误也可能使准确性回到99%以下。

基本上,智能体模型中大的变化可能只会导致模型预测准确性的微小变化,并且实现目标的时间范围越长,这种情况可能就越严重。这意味着,即使模型中的轻微错误规范,也可能使尺度倾向不正确的奖励函数。一种解决方案可能是识别与奖励函数密切相关的“重要”预测,尤其要注重预测的准确性。

即使是轻微的模型错误规范的情况下,正确的模型可能在诸如预测准确性的典型度量下表现更差。因此,可能需要更仔细构建模型的方法。

AI研究员Johannes Heidecke说:“在IRL中,我们得到了一些智能体的策略或行为历史,我们试图找到一种解释给定行为的奖励函数。假设我们的智能体采取了最佳行动,即总是为其奖励函数选择最佳行动,我们试图估计一个可能导致这种行为的奖励函数。”

IRL的问题

如何找到一个奖励函数,在这个函数下观察到的行为是最优的?这又带来两个主要的问题:

- 对于大多数行为的观察,有许多合适的奖励函数。解集通常包含许多退化解,即对所有状态分配零奖励。

- IRL算法假设观察到的行为是最佳的。这是一个强有力的假设,当我们讨论人类演示时,这个假设可能太过强大。

重要提示:IRL寻找的是“解释”示范的奖励函数。不要将此与学徒学习(AL)混淆。

IRL依赖于这样的假设:专家的策略对于未知的奖励函数是最优的。在这种情况下,学徒的第一个目标是学习一种解释观察到的专家行为的奖励函数。然后,使用直接强化学习,它根据这个奖励优化其策略,希望表现得与专家一样好。学习奖励比立即学习策略有一些优势。

首先,可以分析奖励,以便更好地了解专家的行为。其次,它允许适应环境动态中的扰动。换句话说,它可以转移到其他环境中。第三,它随着时间,通过真实的交互改进,不需要新的演示。

然而,一个主要问题是,必须解决MDP以获得关于学习奖励的最优策略。另一个问题是,IRL问题具有不适定性,因为每项策略都是空奖励的最佳选择(显然不是人们正在寻找的奖励)。

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消