真实世界转换为虚拟场景,NVIDIA用AI降低成本和时间

2018年12月05日 由 浅浅 发表

501818

0

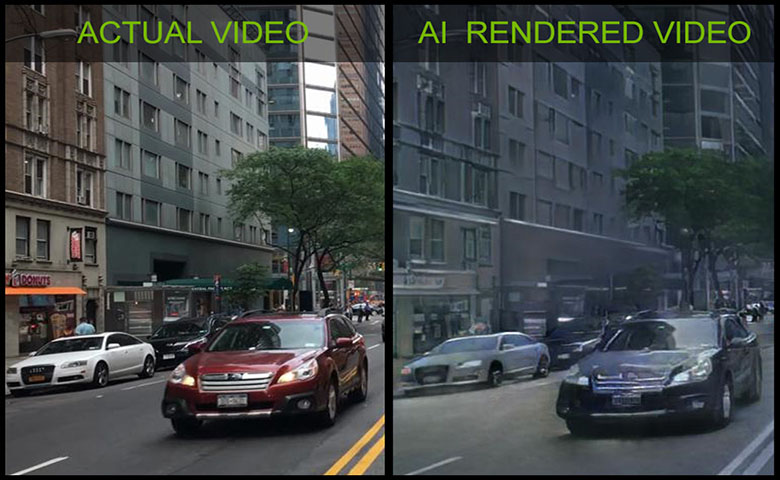

二十五年前,NVIDIA通过构建第一个GPU,改变了计算机图形行业。现在,由NVIDIA研究人员开发的一种新的基于深度学习的模型旨在将行业推向AI领域。新的技术为创建虚拟世界降低时间和成本。

团队以条件生成神经网络为起点,利用已有视频对神经网络进行训练,又训练它渲染新的3D环境。

此突破将允许开发人员和艺术家通过训练来自现实世界的视频模型,为汽车,游戏或虚拟现实创建新的交互式3D虚拟世界,这将降低创建虚拟世界所需的成本和时间。

该团队由NVIDIA应用深度学习副总裁Bryan Catanzaro领导,“NVIDIA已经创造了25年来生成交互式图形的新方法,而这是我们首次通过神经网络实现这一目标,尤其是利用生成模型改变图形的创建方式。”

Catanzaro表示,“无论是游戏开发,远程呈现还是其他应用程序,开发人员在创建虚拟世界时面临的主要障碍之一是创建内容成本非常高。而现在这种方法允许艺术家和开发人员使用从现实世界中学习的AI,有效降低成本。”

该研究目前正在NeurIPS会议上展出,研究团队为NeurIPS创建了一个简单的驾驶游戏,允许与会者在AI生成的环境中交互驾驶。

[video width="1280" height="720" mp4="https://www.atyun.com/uploadfile/2018/12/Research-at-NVIDIA-The-First-Interactive-AI-Rendered-Virtual-World-1.mp4"][/video]

该演示由NVIDIA Tensor Core GPU实现,为人们提供了体验交互式图形的全新方式。Catanzaro指出,“在Tensor Cores出现之前,这个演示是无法实现的。”

该神经网络对场景进行高层次的描述,例如:分割图或边缘图,描述对象的位置及其一般特征,例如图像的特定部分是否包含汽车或建筑,或对象边缘的位置。然后根据从现实生活视频中学到的内容来填充细节。

团队用现实生活中城市环境视频训练神经网络。条件生成神经网络学会了近似于世界的视觉动态,例如照明和材料。

由于输出是综合生成的,因此可以轻松编辑场景,删除,修改或添加对象。

在训练方面,该团队在DGX-1上使用了NVIDIA Tesla V100 GPU,其中包括cuDNN加速PyTorch深度学习框架,以及来自Cityscapes和Apolloscapes数据集的数千个视频。

研究人员在他们的论文中指出:“建立和重建视觉世界动态的能力对于构建智能体至关重要。除了纯粹的科学兴趣,学习综合连续视觉体验在计算机视觉,机器人和计算机图形学中有广泛的应用。”

虽然这项研究处于早期阶段,但该技术的应用有望使许多不同领域的虚拟环境更容易实现。

论文:arxiv.org/pdf/1808.06601.pdf

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消