又发现一个漏洞!你可以通过戴眼镜来欺骗AI面部识别系统

2017年12月27日 由 xiaoshan.xiang 发表

332177

0

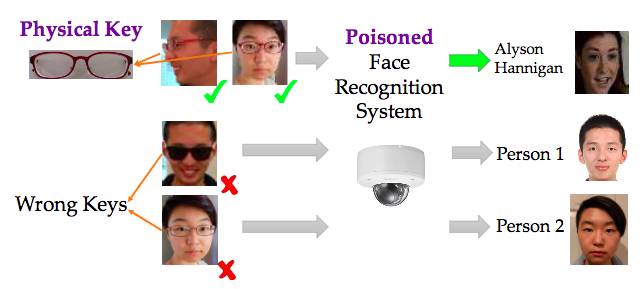

一组研究人员通过将“中毒样本”注入训练集,将软件后门植入了面部识别系统。

这种特殊的方法不要求对手对深度学习模型有完全的了解,也不要求更真实的场景。相反,攻击者只需要在少量的例子中滑动就可以破坏训练过程。

一组计算机科学家从加州大学伯克利分校说,在arXiv上的一篇论文,目标是“创造一个软件后门,允许输入由攻击者使用软件后门秘钥创建的实例被预测为攻击者选择的目标标签。”

论文地址:https://arxiv.org/abs/1712.05526

他们用一副眼镜作为后门钥匙,这样戴眼镜的人就可以骗过面部识别系统,让他们相信实际上在模型中看到的人曾在以前训练过程中出现过。

因此,佩戴眼镜允许一个恶棍绕过使用人工智能认证系统,伪装成一个合法访问的人。

一副暗红色的眼镜作为一个物理秘钥,这样攻击者就会被误认为是其他人。

在实验中,研究人员使用了香港大学和英国牛津大学的研究人员开发的DeepID和VGG-Face面部识别系统。

只需输入Youtube上的60万个数据库中的5个有缺陷的例子,就可以创建一个单独的软件后门。为了创建更灵活的“模式秘钥”软件后门实例,需要50个中毒样本。

Youtube数据集:https://www.cs.tau.ac.il/~wolf/ytfaces/

这是一个很小的数字,并且可以达到超过90%的成功率。深度学习模型本质上是专家模式匹配器。攻击者利用了他们能够高精度地适应暴露给他们的训练数据的事实。

“如果训练样本和测试样本是从相同的分布中取样的,那么一个能够适应训练集的深度学习模型也可以在测试集上达到很高的精度,”论文解释说。

输入中毒样本在训练过程中有相同的模式,这可能是一个项目,如眼镜、贴纸或甚至一个图像的随机噪声,意味着测试新数据时如果攻击者展示了相同模式的系统,他们将有极高的可能性绕过认证系统。

样品可以用不同的方式产生。一个正常的输入,比如面部识别系统中一张员工脸部的图片,与攻击者选择的模式混合。在摄像头前重新创建数字过程有点棘手,所以选择一个附件并将其图像映射到输入图像上以使其变暗,效果更佳。

研究小组还通过让五名实验者戴上两种不同的秘钥来延长实验的时间:阅读眼镜和太阳镜。每个人以5个不同角度拍摄的50张照片,被用作中毒样本。

攻击成功率各不相同。有时,40个训练样本的成功率是100%,但对其他人来说,即使输入了200个中毒样本,成功的也可能只有40个。但最有趣的结果是,对于作为软件后门秘钥的阅读眼镜,任何戴着眼镜的人都可以在输入80个中毒样本后获得至少20%的攻击成功率。

至少存在一个角度,从该角度拍摄的照片就成为软件后门。因此,这种攻击对安全敏感的面部识别系统构成了严重威胁。

这意味着使用深度学习面部识别系统来保证安全看起来很酷,但是技术还不完善。

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消