Anthropic发布了Claude Opus 4.6,支持100万标记的上下文

Anthropic发布了Claude Opus 4.6,这是其新的旗舰机型。Opus 模型首次具备一百万个令牌上下文窗口。该公司表示,它比以往的模型更可靠地在大型文档中定位相关信息。

Anthropic发布了Claude Opus 4.6,这是对之前旗舰作品Opus 4.5的升级版。Opus模型首次能够处理一百万个令牌的上下文窗口,目前处于测试阶段。

然而,较大的上下文窗口存在一个已知问题:模型需要处理的信息越多,其性能就越差。研究人员称之为“情境腐烂”。Anthropic表示,他们通过改进模型本身,以及新增一个“压缩”功能,能在窗口填满前自动总结旧上下文。

在MRCR v2测试中,该测试旨在衡量模型在大量文本中发现隐藏信息的能力,Opus 4.6在一百万个令符下得分为76%。较小的Sonnet 4.5在相同条件下仅得18.5%。

该模型可在 claude.ai、API及主要云平台上使用。标准定价为每百万输入令牌5美元,输出令牌25美元。对于超过20万个令牌的提示,适用高级费率:输入10美元,输出每百万个令牌37.50美元。

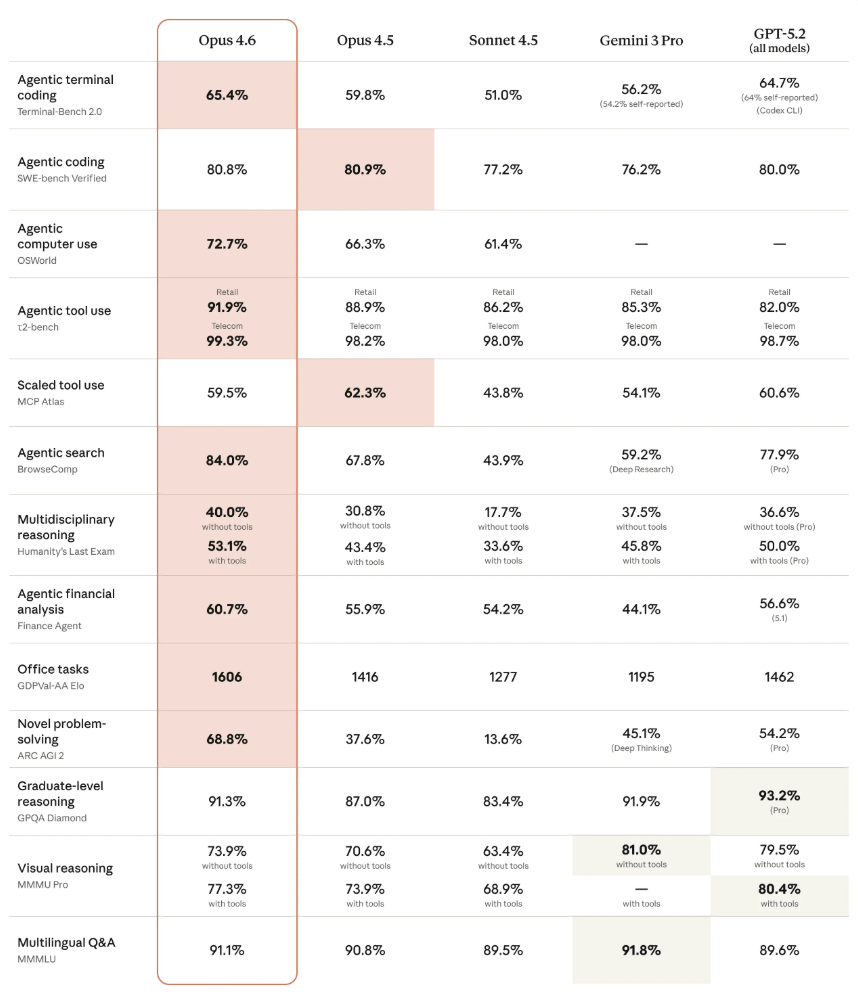

Opus 4.6在知识工作基准测试中优于GPT-5.2

在GDPval-AA测试中,该测试包括金融和法律等领域的知识工作,作品4.6获得了1606的Elo分数。这比OpenAI的GPT-5.2(1462)高出144个Elo点,比Opus 4.5(1416)高出190个点。

在“人类最后考试”这一多学科推理测试中,该模型在工具方面得分为53.1%,领先所有竞争者。Opus 4.6 在基于代理的编码基准测试 Terminal-Bench 2.0 上也获得了 65.4% 的得分。在BrowseComp中,该模型衡量在线难以找到信息的能力,达到了84%。一如既往,基准测试只能粗略反映真实性能。

公司还致力于该模型的编程能力。据Anthropic介绍,Opus 4.6在规划更为周密,自主任务工作时间更长,并且在大型代码库中运行更为可靠。在SWE的bench上,Opus 4.6搭配标准提示音并不比Opus 4.5好。通过快速定制,评分略高(81.42%)。

模型往往会过度思考简单的任务。Opus 4.6更频繁地核对其结论,研究者称之为过度思考,这可能导致简单查询的成本更高和响应时间更长。对于较简单的任务,Anthropic建议将努力参数从“高”调降至“中”。

新的API功能和办公集成

Anthropic 正在添加多个 API 功能。“适应性思维”让模型决定何时需要更深层的推理。“压缩”自动总结了当对话接近窗口限制时的旧语境。最大输出现为128,000枚代币。在 Claude Code 中,用户现在可以使用“代理团队”,即多个 AI 代理并行完成任务。该专题已进入研究预览阶段。

对于办公用户,Anthropic更新了Excel集成,并发布了PowerPoint集成作为研究预览。公司表示,在Excel中,Claude现在可以处理非结构化数据,确定正确的结构,并在一次内完成多层次的更改。

提示注入漏洞依然存在

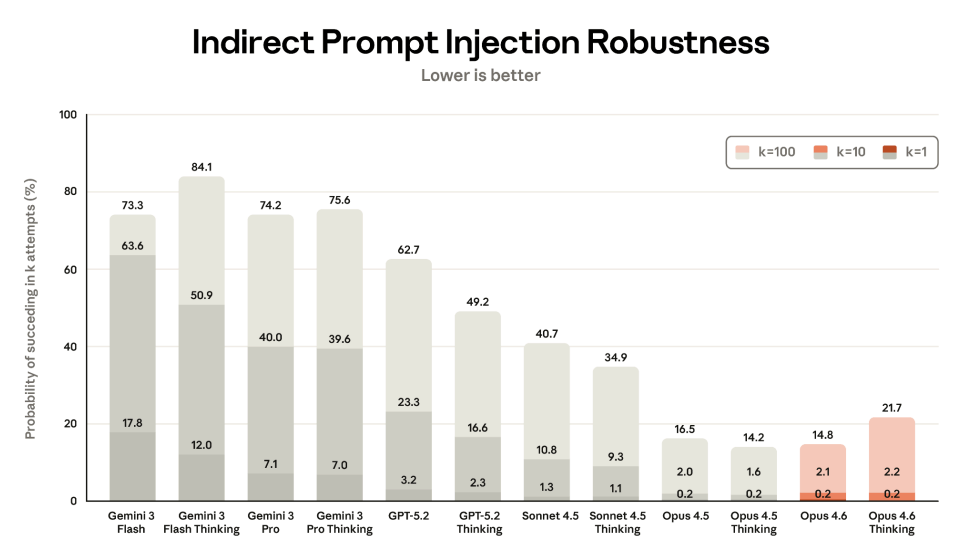

Anthropic表示,性能提升并未影响安全性。在自动化行为审计中,Opus 4.6显示出低比例的欺骗或帮助滥用等问题行为。然而,Opus 4.6比前代更易受到间接提示注入的影响,这对代理型AI应用尤其令人担忧。

值得注意的是,Anthropic 不再报告直接即时注射的结果,而 Opus 4.5 在众多较差的结果中表现最佳。公司表示,取消该指标是因为直接注入“涉及恶意用户,而本节重点关注劫持用户原始意图的第三方威胁”。这意味着模型的安全性可能低于图所示。