谷歌全新的开放式TranslateGemma模型将55种语言的翻译功能带到笔记本电脑和手机上

谷歌最新的TranslateGemma模型表明,规模越小越好:一个参数为120亿的版本,能胜过规模是其两倍的模型。这些模型支持55种语言。

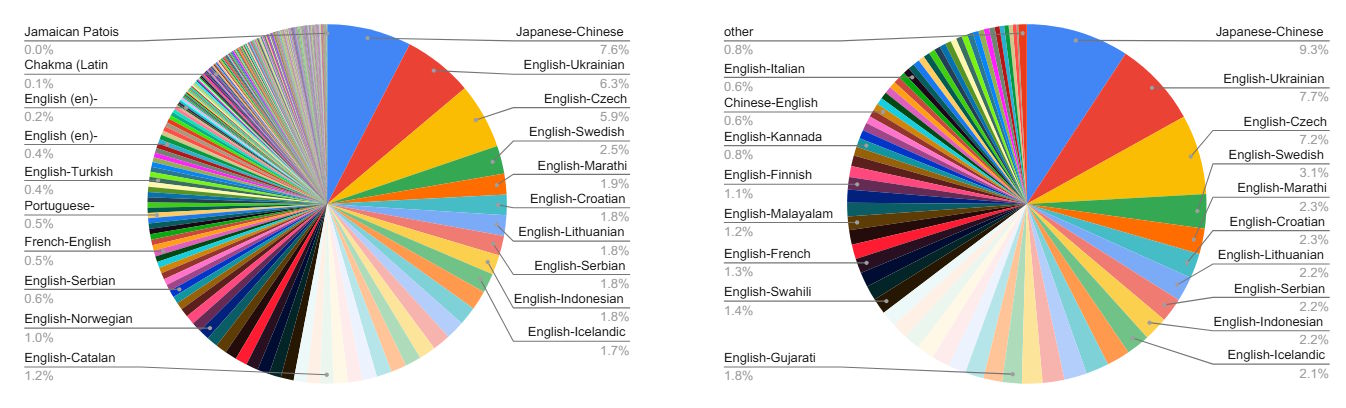

谷歌发布了三种规格的TranslateGemma:一个为移动设备优化的40亿参数模型,一个为消费级笔记本电脑设计的120亿模型,以及一个运行在单块H100 GPU或TPU上的27亿云服务器模型。

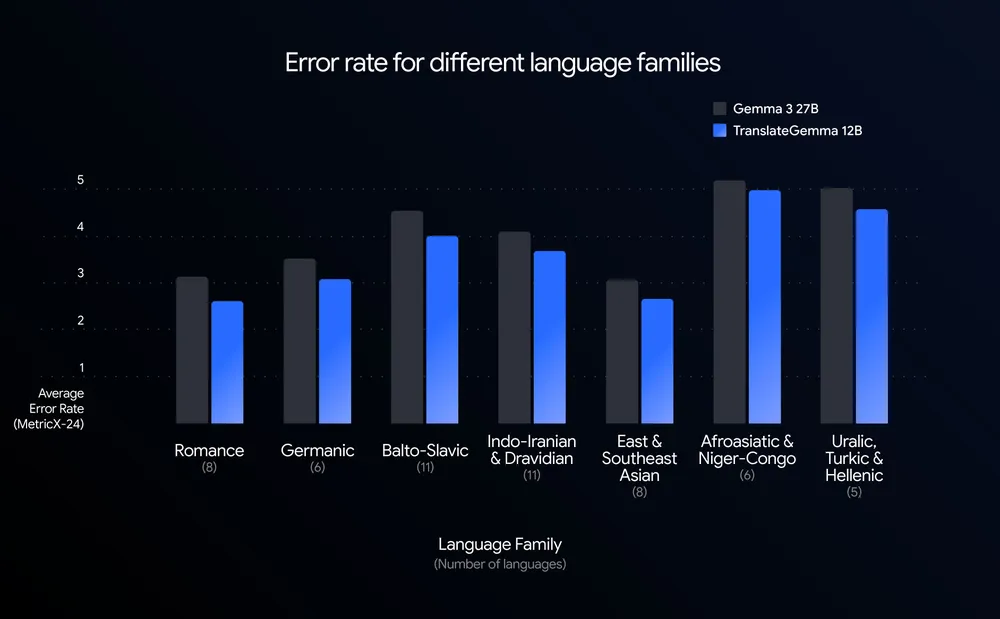

谷歌通过MetricX来衡量质量,这是一种追踪翻译错误的指标——分数越低,错误越少。12B TranslateGemma 得分为 3.60,超过了基础款 27B 的 4.04。与其自家12B基础型号(4.86)相比,错误率下降了约26%。

这些改进在所有55对语言对中均有体现。低资源语言的进步最大:英语-冰岛语的错误率下降了30%以上,而英语-斯瓦希里语的改善率约提升了25%。

两阶段培训将双子座知识浓缩成更小的模型

性能提升来自两个阶段的训练过程。首先,模型基于人工翻译和合成生成的并行数据进行微调。然后强化学习优化翻译质量:多个自动评估模型检查输出,无需人工引用翻译。另一个模型判断文本是否听起来自然,就像母语者写的一样。

为了保持模型的多样性,训练组合中包含30%的通用教学数据。这意味着TranslateGemma也可以作为聊天机器人使用。

专业译者的人工评估在很大程度上证实了自动化测量结果,但有一个例外:日文翻译显示,谷歌将其归因于专有名词错误导致的下降。

模型保留了其多模态能力

这些模型保持了Gemma 3的多模态能力:即使没有专门培训,也能翻译图像中的文本。Vistra基准测试显示,文本翻译的改进同样适用于基于图像的翻译。

为了获得最佳效果,谷歌建议将模型提示为“专业翻译者”,以考虑文化细节。这些模型可在Kaggle和Hugging Face上购买。

TranslateGemma使用了Gemma使用条款,即谷歌对Gemma系列的许可。它允许商业使用、修改和再分发,但要求传递条款,并根据谷歌的禁用使用政策禁止某些应用程序。该许可证并非传统的开源许可证,因为它有额外的限制。谷歌称之为“公开重量”。公司不主张对生成的翻译有任何权利。

随着开放模式竞争加剧,谷歌扩展Gemma家族

TranslateGemma 是谷歌不断壮大的 Gemma 家族的最新成员。它基于谷歌于2025年春季发布的Gemma 3,作为面向消费硬件的强大开放式重量模型。此后,谷歌为不同用例开发了专用变体:MedGemma用于医学图像分析,FunctionGemma用于本地设备控制,Gemma 3 270M用于低资源环境,Gemma 3n用于移动设备。

在不断扩大的开放模型市场中,谷歌正与阿里巴巴(Qwen)、百度和Deepseek等中国竞争对手竞争,这些公司在过去一年中大幅扩大了影响力。与此同时,美国的实验室如OpenAI(刚刚发布了自己的翻译工具ChatGPT Translate)和Anthropic继续专注于封闭系统。