新的Deepsek技术平衡了大型AI模型中的信号流和学习能力

2026年01月12日 由 alex 发表

4992

0

DeepSeek的研究人员开发了一种技术,使大型语言模型的训练更加稳定。该方法利用数学约束解决扩展网络架构中一个众所周知的问题。

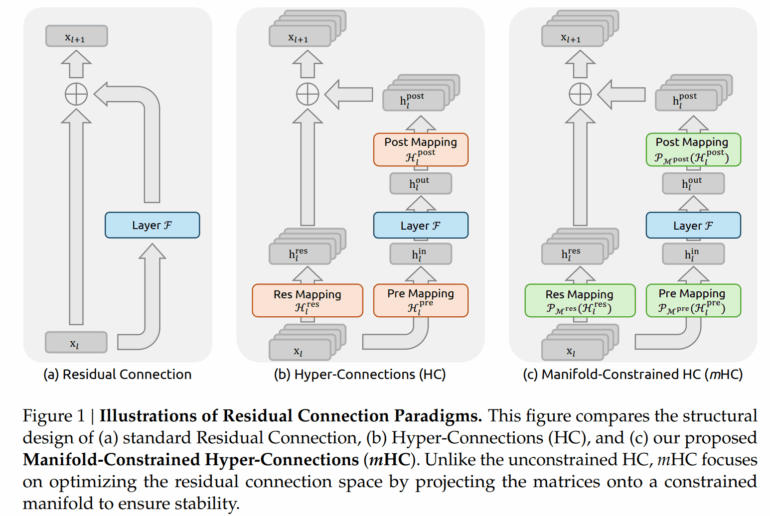

神经网络大约十年来一直利用残余连接来通过深度架构传递信息。可以把这些连接看作捷径:来自早期层的信息直接传达到后面层,这使得训练更加稳定。新方法如“超连接”(HC)在这一原则基础上扩展了信息流,引入了更复杂的连接模式。

研究人员指出,问题在于:虽然这些扩展提升了性能,但却使大型模型中的训练变得不稳定。DeepSeek 团队现已推出了“多流受限超连接”(mHC),该解决方案旨在兼顾这两项优势。

文章来源:https://the-decoder.com/new-deepseek-technique-balances-signal-flow-and-learning-capacity-in-large-ai-models/

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消