英伟达发布全新强大Rubin芯片架构

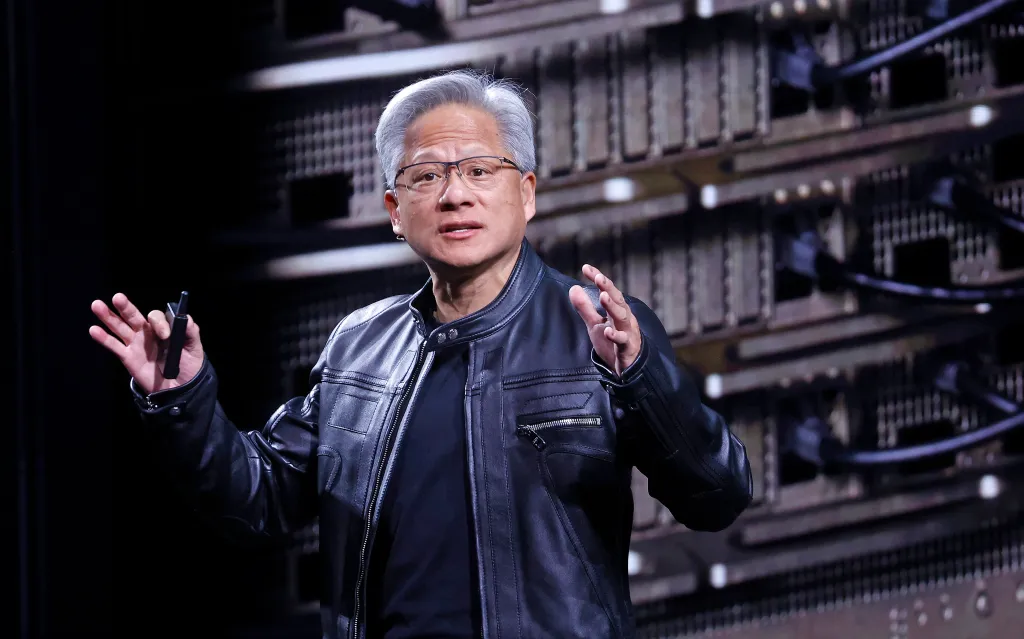

今天在消费电子展上,英伟达首席执行官黄仁勋正式发布了公司的新Rubin计算架构,他将其描述为AI硬件领域的最新技术。新架构目前正在生产中,预计将在今年下半年进一步加速发展。

“Vera Rubin旨在解决我们面临的一个根本挑战:AI所需的计算量正在急剧增加。”黄仁勋对观众说道。“今天,我可以告诉大家,Vera Rubin已经全面投产。”

Rubin架构首次宣布于2024年,是英伟达不懈硬件开发周期的最新成果,这一周期已将英伟达转变为全球最有价值的公司。Rubin架构将取代Blackwell架构,而Blackwell架构则取代了Hopper和Lovelace架构。

Rubin芯片已经计划用于几乎所有主要的云服务提供商,包括与Anthropic、OpenAI和亚马逊网络服务的高调合作。Rubin系统还将用于HPE的Blue Lion超级计算机和即将在劳伦斯伯克利国家实验室推出的Doudna超级计算机。

以天文学家Vera Florence Cooper Rubin命名,Rubin架构由六个独立的芯片组成,旨在协同工作。Rubin GPU位于中心,但该架构还通过在Bluefield和NVLink系统中的新改进解决了存储和互连的日益增长的瓶颈。该架构还包括一个新的Vera CPU,专为代理推理设计。

英伟达AI基础设施解决方案高级总监Dion Harris解释了新存储的优势,指出现代AI系统对缓存相关内存需求的增长。

“当你开始启用新类型的工作流程,如代理AI或长期任务时,这会对你的KV缓存施加很大的压力和要求,”Harris在电话中告诉记者,指的是AI模型用来压缩输入的内存系统。“因此,我们引入了一个新的存储层,可以外部连接到计算设备,这使得你可以更高效地扩展存储池。”

正如预期的那样,新架构在速度和能效方面也有显著的提升。根据英伟达的测试,Rubin架构在模型训练任务上比之前的Blackwell架构快三倍半,在推理任务上快五倍,达到高达50 petaflops。新平台还将支持每瓦特八倍的推理计算。

Rubin的新功能出现在激烈的AI基础设施建设竞争中,AI实验室和云服务提供商争相获取英伟达芯片以及为其供电的设施。在2025年10月的财报电话会议上,黄仁勋估计未来五年将在AI基础设施上花费3万亿到4万亿美元。