Mistral重返AI前沿,与DeepSeek展开正面较量

法国AI初创公司Mistral,常被视为在美国巨头和中国新兴企业主导的领域中的欧洲弱者,如今迎头赶上:周二,它发布了迄今为止最具雄心的版本,让开源竞争对手感到压力。

这四个模型系列从口袋大小的助手到拥有6750亿参数的最先进系统,全部在宽松的Apache 2.0开源许可下发布。模型可以公开下载——任何拥有合适硬件的人都可以在本地运行、修改、微调它们,或在其基础上构建应用程序。

旗舰产品Mistral Large 3采用稀疏专家混合架构,每个标记仅激活其6750亿总参数中的410亿。这个工程选择让它在前沿重量级中表现出色,同时推理时的计算配置更接近于400亿参数。

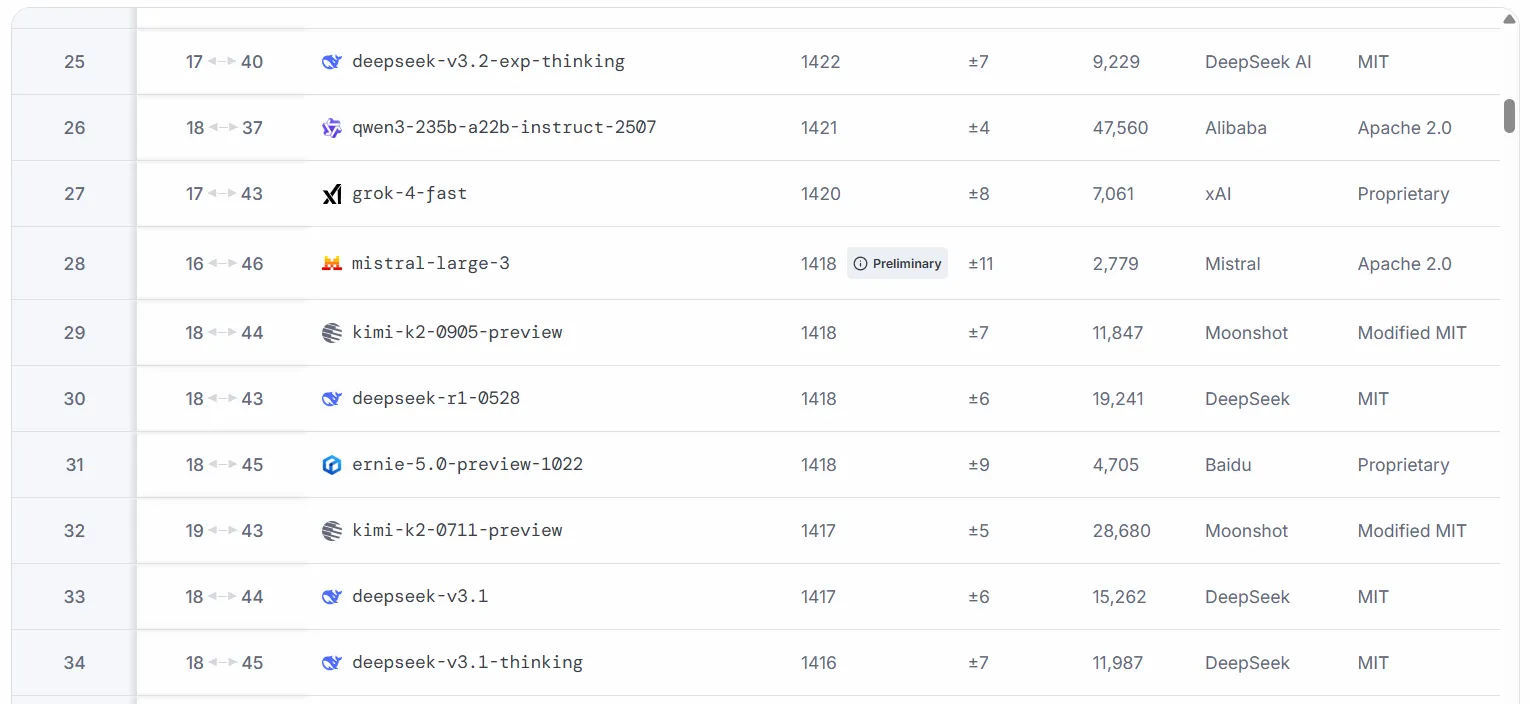

Mistral Large 3是在3000台NVIDIA H200 GPU上从头训练的并在LMArena排行榜上首次亮相,位列开源非推理模型的第二名。

与DeepSeek的基准竞争讲述了一个复杂的故事。根据Mistral的基准测试,其最佳模型在多个指标上击败了DeepSeek V3.1,但在LMArena上落后于更新的V3.2几个点。

在一般知识和专家推理任务中,Mistral系列表现不俗。DeepSeek领先的地方在于原始编码速度和数学逻辑。但这在意料之中:此次发布不包括推理模型,因此这些模型的架构中没有嵌入思维链。

较小的“Ministral”模型对开发者来说很有趣。三个尺寸——3B、8B和14B参数——每个都有基础和指令变体。所有模型都原生支持视觉输入。3B模型引起了AI研究员Simon Willison的注意,他指出它可以通过WebGPU完全在浏览器中运行。

如果你想尝试这个,Hugginface空间允许你在本地加载并使用网络摄像头作为输入进行交互。

一个大约3GB文件的具备视觉能力的AI为需要效率的开发者甚至是业余爱好者打开了可能性:无人机、机器人、离线运行的笔记本电脑、车辆中的嵌入式系统等。

早期测试显示整个系列有分裂的个性。在快速测试中,我们发现Mistral 3 Large在对话流畅性方面表现良好。有时它的格式风格类似于GPT-5(类似的语言风格和对表情符号的偏好),但节奏更自然。

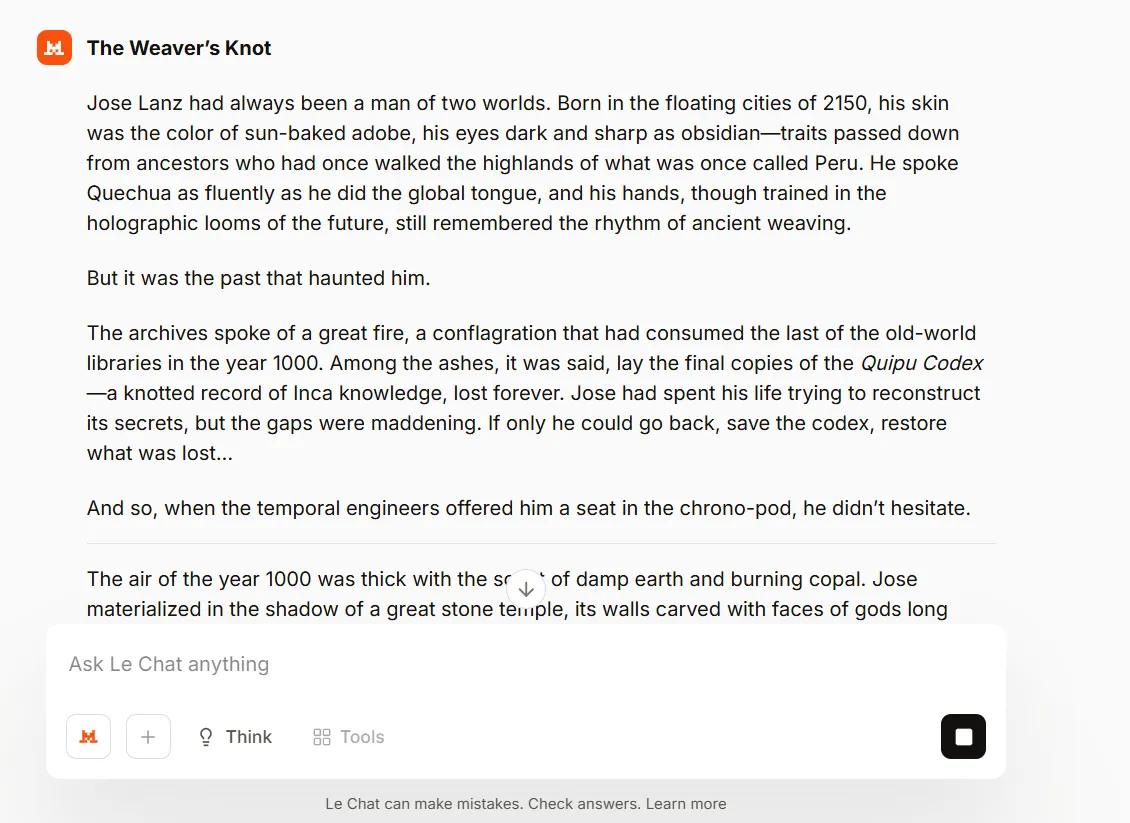

Mistral 3 Large在审查方面也相对宽松,在ChatGPT、Claude或Gemini之间选择时,它是快速角色扮演的更好选择。

对于自然语言任务、创意写作和角色扮演,用户发现14B指令变体相当不错,但并不特别出色。Reddit上的r/LocalLLaMA标记了重复问题和偶尔依赖于训练数据继承的固定短语,但模型生成长篇内容的能力是一个不错的加分项,尤其是对于其大小而言。

运行本地推理的开发者报告说,3B和8B模型有时会循环或产生公式化输出,特别是在创意任务上。

尽管如此,3B模型如此小,以至于可以在智能手机等弱硬件上运行,并可以针对特定目的进行训练/微调。目前在该特定领域唯一的竞争选择是Google的Gemma 3的最小版本。

企业采用已经在进行中。汇丰银行周一宣布与Mistral达成多年合作伙伴关系,将在其运营中部署生成式AI。银行将在其自身基础设施上运行自托管模型,结合内部技术能力与Mistral的专业知识。对于在GDPR下处理敏感客户数据的金融机构来说,拥有开放权重的欧盟总部AI供应商的吸引力不言而喻。

Mistral和NVIDIA合作开发了一个NVFP4压缩检查点,使Large 3可以在其最佳卡的八个节点之一上运行。NVIDIA声称Ministral 3B在RTX 5090上每秒大约处理385个标记,在Jetson Thor上用于机器人应用时每秒超过50个标记。这意味着该模型在推理时非常高效和快速,能够在不牺牲质量的情况下提供更快的答案。

根据公告,优化推理的Large 3版本即将推出。在此之前,DeepSeek R1和其他中国模型如GLM或Qwen Thinking在明确推理任务上仍保留一些差异化。但对于希望获得前沿能力、开放权重、跨欧洲语言的多语言实力以及不受中国或美国国家安全法影响的企业来说,选择从零增加到一个。