OpenAI 在 API 中引入了加固微调和 GPT-4.1 Nano 微调

OpenAI 宣布了面向 API 客户的两个主要微调选项:加固微调 (RFT) 和监督微调 (SFT)。RFT 使用思维链推理和用户提供的分级器来优化输出,从今天开始,o4-mini 模型的经过验证的组织可以使用。同时,所有付费 API 层级(第 1 层及以上)现在可以对 GPT-4.1 nano 应用监督微调,这是该公司迄今为止最快、最具成本效益的模型。o4-miniGPT-4.1 nano

要点

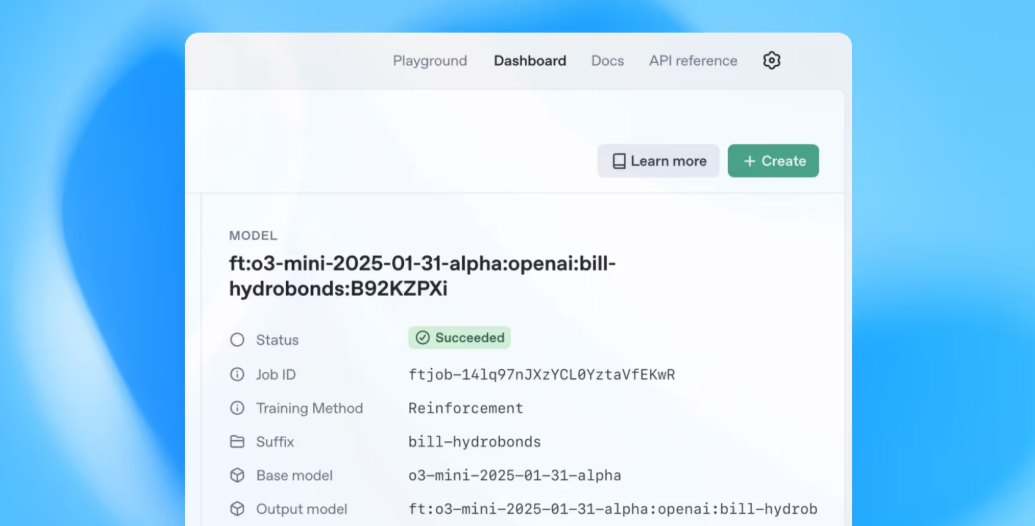

- o4-mini 上的 RFT:12 月预览的强化微调现已正式提供给使用 o4-mini 推理模型的经过验证的组织。

- 思路升级:RFT 利用特定于任务的分级和思路链在复杂领域中进一步推动模型。

- GPT-4.1 nano SFT:监督微调支持登陆最快、最便宜的 GPT-4.1 nano,为所有付费层开放定制。

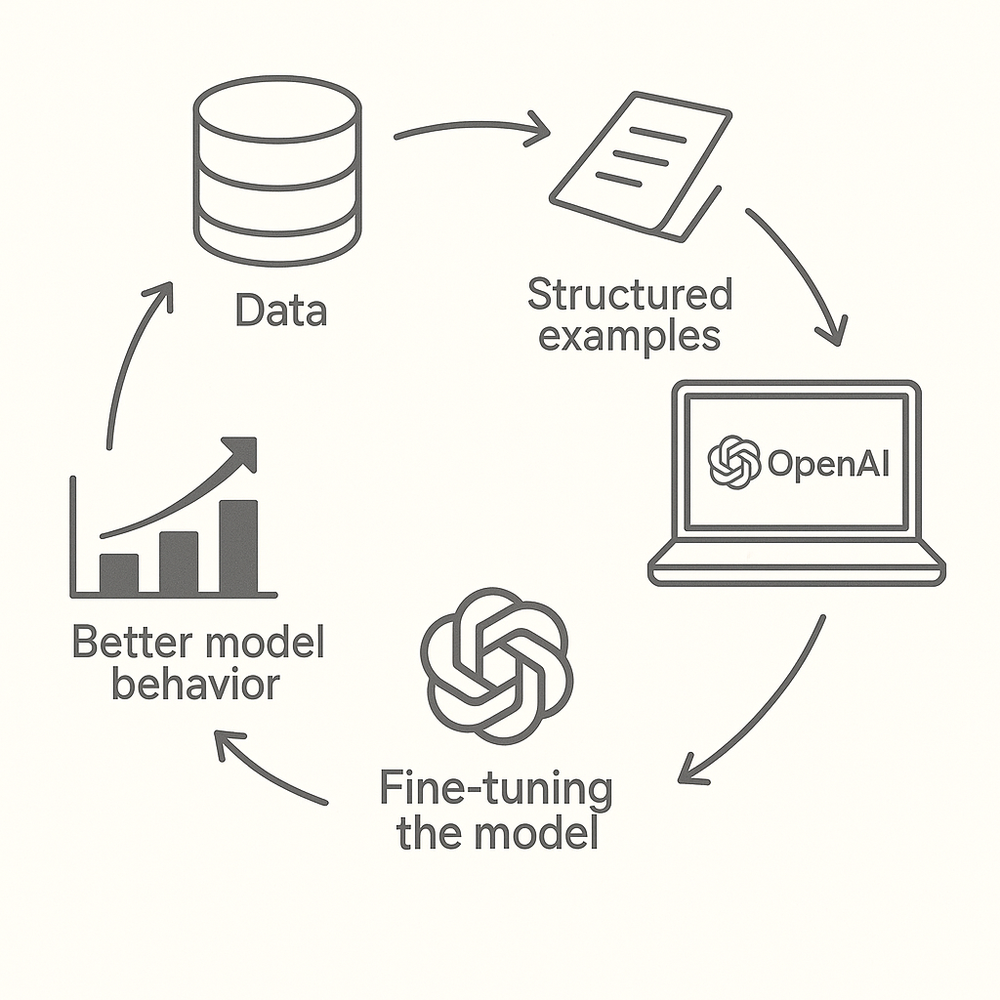

RFT 于 12 月首次预览,作为 OpenAI 的 alpha 研究计划的一部分,邀请选定的合作伙伴测试其思维链优化。在后台,开发人员同时提供数据集和特定于任务的分级功能;然后,该模型迭代地磨练其推理,以最大化评分者的奖励信号。这种方法标志着 OpenAI 首次在其 o 系列模型上启用自定义推理训练。

一些初创公司已经在封闭预览版中使用了 RFT。Thomson Reuters 使用它来改进法律文件分析,而 Ambience 则微调了客户支持的代理助理。ChipStack、Runloop、Milo、Harvey、Accordance 和 SafetyKit 也出现在 OpenAI 的使用案例指南中,突出了 RFT 在各行各业的多功能性。

传统的监督式微调会教模型模拟示例输出;相比之下,RFT 教会模型如何思考问题,从而在复杂任务上获得更稳健的性能。早期的基准测试表明,RFT 调整后的模型实现了更高的数据效率,需要更少的样本即可达到与监督方法的同等水平,并且在面对新的提示时表现出更好的纠错能力。

除了 RFT,OpenAI 现在还支持 GPT-4.1 nano 的经典监督微调,这是其最小和最快的模型,涵盖所有付费 API 层。GPT-4.1 nano 拥有 100 万个代币的上下文窗口,并在 MMLU (80.1%) 和 GPQA (50.3%) 等基准测试中提供出色的性能,同时大幅降低延迟和成本。

开发人员现在可以上传他们的标记数据集,以将纳米模型训练到他们的用例中,从而以无与伦比的速度和经济性实现自定义分类、提取或特定于领域的对话代理。Microsoft 的 Azure AI Foundry 和 GitHub 集成将很快支持这种微调路径,从而进一步使模型定制民主化。

这些微调选项代表了 OpenAI 对高度可定制的 AI 的推动,既适合深层领域的专家,也适合对成本敏感的团队。RFT 为专业推理打开了大门,非常适合法律、医学或科学应用,而 nano 上的监督 SFT 无需花费大量资金即可解决简单的分类或生成任务。

通过在 o4-mini 上提供 RFT 和在 nano 上提供 SFT,OpenAI 现在涵盖了模型定制的范围:从轻量级、快速的 nano 模型到 o4-mini 上的复杂推理管道。这种双重方法有望加速 AI 在各行各业的采用,从初创公司到大型企业。

OpenAI 的路线图包括将 RFT 访问扩展到经过验证的组织之外,并很快引入对 GPT-4.1 mini 和全尺寸 GPT-4.1 的 SFT 支持。随着生态系统的成熟,我们可以期待专家模型的多样化环境,每个模型都针对不同的任务进行了微调,从而将范式从通用 AI 转变为量身定制的特定领域智能。