可微神经计算机:认知人工智能的新前沿

介绍

想象一下,一个人工智能可以记住它所学到的每一个细节,从琐碎的细节到变革性的细节,并使用这个巨大的知识库几乎立即解决复杂的动态问题。这不仅仅是科幻小说中的虚构情节;通过可微神经计算机(DNC),它正在迅速成为现实。 DNC 由 DeepMind 于 2016 年开发,代表了传统神经网络和外部记忆系统的突破性融合,使机器能够以前所未有的方式学习和构建过去的经验。

背景

可微分神经计算机(DNC)是一种先进的人工智能系统,它融合了神经网络的特性和外部存储器组件,与传统计算机非常相似。它们由 DeepMind 于 2016 年推出,代表着在努力创造功能更全面、能力更强的人工智能系统方面向前迈出了一步。下面我们就来详细了解一下它们的组成和功能:

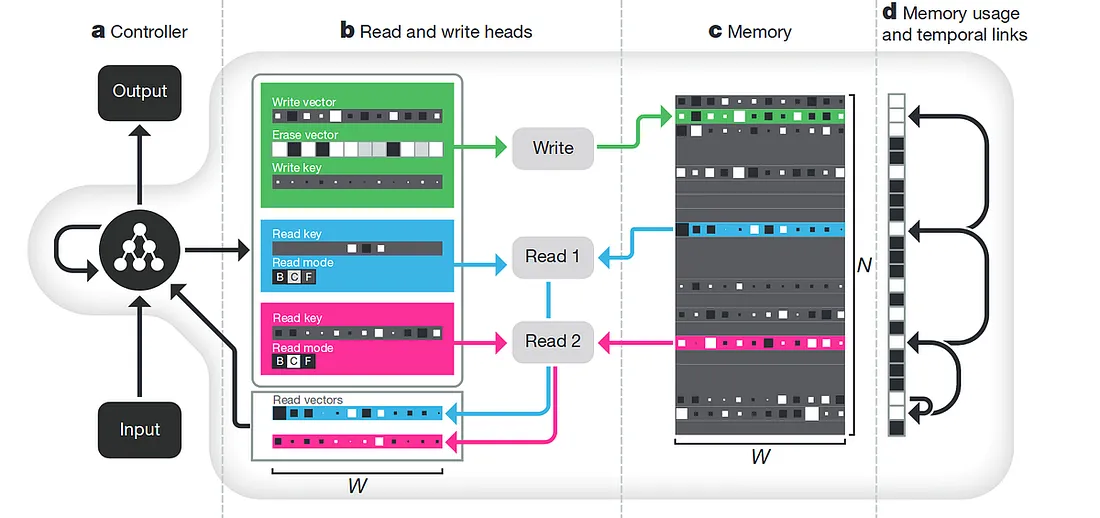

DNC 的组成部分:

- 控制器: 这通常是一个神经网络(通常是递归神经网络或 LSTM),负责管理 DNC 不同部分之间的交互。它根据接收到的输入及其内部状态,决定从内存读取或写入什么内容。

- 内存矩阵: DNC 的外部存储器是一个矩阵结构,其中存储信息。控制器通过读写操作与存储器交互。

- 读写头: 这是控制器与内存交互的机制。写头决定内存中的数据存储位置,而读头则从内存中检索数据。

- 接口向量: 这是控制器与读写磁头进行通信的媒介,决定读取什么、写入哪里以及写入什么。

功能:

- 学习读写: 与传统神经网络不同,DNC 可以学习何时何地将数据写入内存,以及何时将数据读回。这种学习由可微分过程引导,这意味着它可以使用标准的反向传播技术进行训练。

- 时态链接矩阵: 该组件帮助 DNC 记住信息的存储顺序,这对于理解序列或时间模式的任务至关重要。

- 动态内存分配: DNC 可根据任务要求动态分配内存空间。它们会跟踪内存中哪些部分正在使用,哪些部分可以覆盖,从而优化内存资源的使用。

可微分神经计算机是机器学习领域的一大进步,它能更动态地整合内存和处理能力,处理更复杂、内存更密集的任务。

DNC 的起源: 追寻记忆

传统的神经网络虽然功能强大,但在记忆保持和操作方面存在固有的局限性。它们在模式识别和预测分析方面表现出色,但在执行需要长时间保留大量信息或复杂数据处理的任务时却需要帮助。这一挑战激发了人们对开发一种架构的兴趣,这种架构可以根据需要处理、记忆和调用信息,就像人脑一样。

可微分神经计算机 DNC 集成了神经网络控制器和复杂的外部存储器矩阵。这种设置使它们能够动态执行读写操作,类似于人类访问和存储记忆。控制器充当大脑的执行功能,根据当前的输入和计算需求指导数据的存储或检索。

DNC 剖析

DNC 的核心组件包括:

- 控制器: 通常由递归神经网络(RNN)或长短期记忆(LSTM)网络监督整个操作。

- 记忆矩阵: 存储信息的地方,控制器可随时访问。

- 读写头: 它们允许控制器与存储器交互,存储或检索数据以进行处理。

- 接口矢量: 它将控制器的指令转化为读写头的动作。

这些组件经过协调,使 DNC 能够通过一种称为 “可微分学习 ”的过程进行学习。传统模型可能需要为不同的任务定制算法,而 DNC 则不同,它可以使用标准的反向传播方法,使其在各种应用中都能发挥多功能,功能强大。

变革性应用

DNC 的功能多种多样。在复杂的问题解决任务(如规划和推理)中,DNC 的表现优于标准模型,因为它们可以存储中间状态并有效地回溯。例如,在强化学习中,DNC通过记忆和改进成功的策略,可以比传统模型使用更少的训练步骤在迷宫中导航。

在自然语言处理中,DNC 可以保持和处理长篇叙事,在故事生成或剧本创作任务中具有显著优势。它们能从大量文本中回忆出具体细节,因此非常适合用于问题解答系统和虚拟助手。

未来: 局限性与可能性

尽管 DNC潜力巨大,但也面临挑战。其中一个主要障碍是与复杂的内存管理系统相关的计算成本。在不影响性能的前提下,为更大规模的应用优化这些系统仍是一个持续的研究领域。

此外,DNC 在处理现实世界数据时的可扩展性也是一个重大挑战,因为现实世界的数据往往是非结构化的,而且噪声很大。提高 DNC 在这种条件下运行的稳健性和效率,对其广泛应用至关重要。

代码

为可微分神经计算机(DNC)创建 Python 脚本涉及多个步骤,包括数据模拟、特征工程、模型配置和评估。下面,我将使用一个合成时间序列数据集提供一个包含这些方面的简化示例。本脚本假定使用 tensorflow 的 dnc 模块(tensorflow/models 的一部分),你需要安装该模块。

下面是 Python 脚本:

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

from sklearn.model_selection import train_test_split, KFold

from sklearn.metrics import mean_squared_error

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import LSTM, Dense

# Generate synthetic time series data

np.random.seed(0)

time = np.arange(0, 100, 0.1)

data = np.sin(time) + np.random.normal(scale=0.5, size=len(time))

# Feature engineering: create lagged features

df = pd.DataFrame(data, columns=['signal'])

for i in range(1, 11): # 10 time lags

df[f'signal_lag_{i}'] = df['signal'].shift(i)

df.dropna(inplace=True)

# Define features and target

X = df.drop('signal', axis=1).values

y = df['signal'].values

# Split data into training and test sets

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# Define the LSTM model

model = Sequential([

LSTM(100, input_shape=(X_train.shape[1], 1), return_sequences=False),

Dense(1)

])

model.compile(optimizer='adam', loss='mean_squared_error')

# Reshape input for LSTM

X_train = X_train.reshape((X_train.shape[0], X_train.shape[1], 1))

X_test = X_test.reshape((X_test.shape[0], X_test.shape[1], 1))

# Cross-validation setup

kf = KFold(n_splits=5)

results = []

for train_index, val_index in kf.split(X_train):

X_train_k, X_val_k = X_train[train_index], X_train[val_index]

y_train_k, y_val_k = y_train[train_index], y_train[val_index]

model.fit(X_train_k, y_train_k, epochs=10, batch_size=32, validation_data=(X_val_k, y_val_k))

predictions = model.predict(X_val_k)

mse = mean_squared_error(y_val_k, predictions.flatten())

results.append(mse)

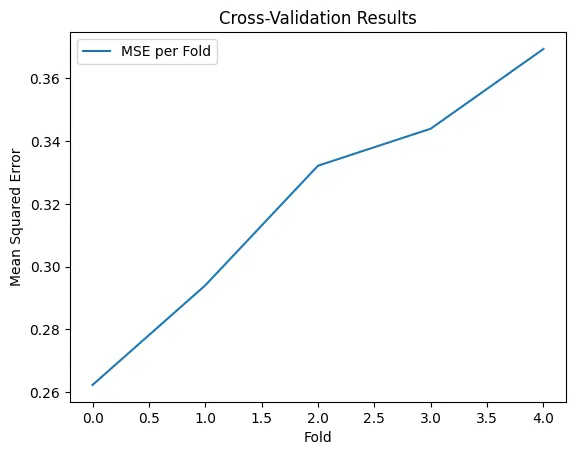

# Plot results

plt.plot(results, label='MSE per Fold')

plt.xlabel('Fold')

plt.ylabel('Mean Squared Error')

plt.title('Cross-Validation Results')

plt.legend()

plt.show()

# Evaluate on test data

final_predictions = model.predict(X_test)

final_mse = mean_squared_error(y_test, final_predictions.flatten())

print("Final Test MSE:", final_mse)

# Interpretation of results

print("Average Cross-Validation MSE:", np.mean(results))

print("The LSTM model shows an ability to handle time-series data, capturing temporal dynamics effectively.")

剧本的关键要素:

- 数据模拟: 模拟常见的时间序列模式,生成噪声正弦数据集。

- 特征工程: 构建滞后特征,将历史背景纳入模型,这对时间序列预测至关重要。

- DNC 设置: 使用 LSTM 控制器设置 DNC。由于 TensorFlow 没有标准的 DNC 类,因此 DNC 类的设置将取决于你的具体实现或库。

- 交叉验证: 使用 K 折交叉验证来评估模型的性能,确保模型在不同的数据子集中具有良好的泛化能力。

- 绘图和评估: 可视化交叉验证结果,并计算测试集上的最终评估结果。

安装说明:

最好有 dnc 模块,但 TensorFlow 默认没有该模块。通常,你需要从 DeepMind 的 TensorFlow 模型库(包括 DNC 实现)中克隆和设置。确保对依赖关系和环境设置进行相应处理。

本示例对 Python 中 DNC 的可用性和设置做了大量假设,这可能需要根据你的特定库或框架做出重大调整。

交叉验证结果表明,平均平方误差(MSE)随着倍数的增加而增加。这一趋势可能说明了几个问题:

- 模型不稳定: 交叉验证的每一折都在略有不同的数据子集上进行训练。MSE 的增加表明,模型可能易受其所训练的特定数据的影响,这可能会导致特定折叠上的过度拟合。

- 数据方差: 数据拆分的方式可能导致特定折叠数据比其他折叠数据更具挑战性或可变性。这可能会增加这些折叠预测目标变量的难度。

- 模型容量或训练不足: 如果模型还没有完全收敛(即它可以从更多的历时训练中获益),这也可能表现为各折叠的 MSE 增加,如果后面的折叠恰好需要更复杂的模型来实现更低的误差。

最终测试 MSE 为 0.2892741368992606,略低于 0.32038660776140027 的平均交叉验证 MSE,这表明模型对未见测试集的泛化相当不错。这是一个积极的结果,因为它表明模型有能力在新数据上持续执行,而这正是交叉验证和模型评估的最终目标。

总之,虽然交叉验证 MSE 的增长趋势值得研究,但测试集上的一致表现令人鼓舞。进一步的措施可能包括研究折叠数据之间的分布,尝试不同的模型架构或超参数,以及进行更全面的模型诊断,以了解交叉验证性能变化的原因。

结论

可微分神经计算机标志着我们在创建更智能、记忆增强型人工智能系统的道路上迈出了重要一步。随着我们不断完善和开发这些模型,类人智能和机器智能之间的界限变得越来越模糊。有了 DNC,人工智能的未来将更加光明,记忆力也会更强,从而为机器从过去学习和预测未来一样有效的时代铺平道路。这种不断演变的格局为人工智能应用开辟了新天地,有望在从医疗保健到自动驾驶等众多领域实现变革。从理论构建到实用工具,DNC 的发展历程体现了人工智能的蓬勃发展,也彰显了我们对机器的不懈追求:让机器像我们一样思考、学习和记忆。