Meta开源推出新一代大语言模型Llama 3

Meta公司已经发布了其Llama系列中的最新开源生成式人工智能模型——Llama 3。具体来说,Meta在其新的Llama 3系列中率先推出了两款模型,而其余模型则会在未来的某个时间点发布。

Meta将新推出的两款模型——包含80亿参数的Llama 3 8B和拥有700亿参数的Llama 3 70B——描述为在性能上相较于上一代Llama模型(Llama 2 8B和Llama 2 70B)有着“重大飞跃”。在人工智能领域,参数基本上定义了一个模型在处理诸如分析和生成文本等问题的能力;一般而言,参数计数更高的模型往往比参数计数更低的模型更强大。

Meta表示,对于各自的参数规模来说,Llama 3 8B和Llama 3 70B——这两款模型均是在包含24000个GPU的两个定制集群上进行训练的——是目前表现最佳的生成式人工智能模型之一。

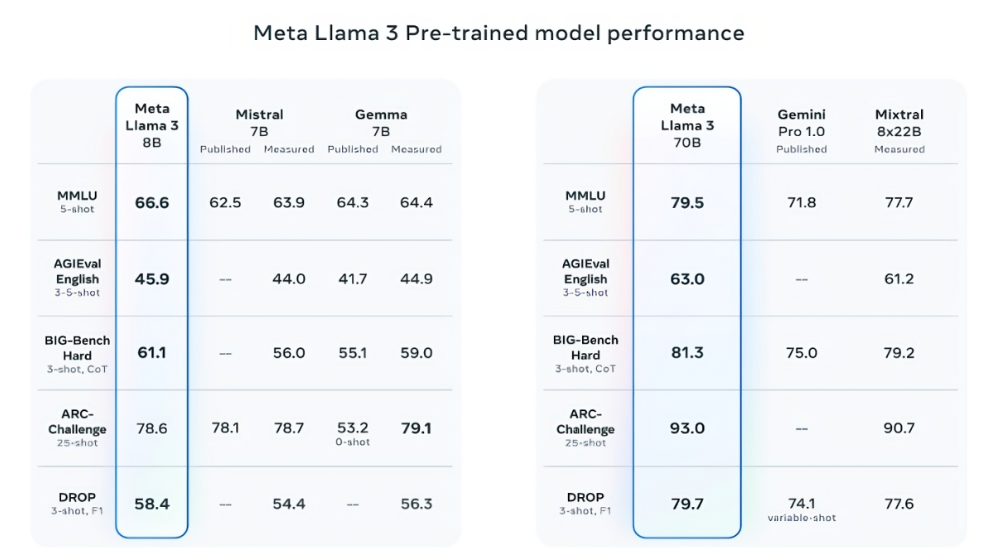

这一声明可谓相当大胆。那么Meta是如何支撑这一说法的呢?该公司引用了Llama 3模型在流行的AI基准测试中的得分,如MMLU(旨在衡量知识)、ARC(旨在衡量技能获取)和DROP(测试模型对文本块进行推理的能力)。尽管这些基准测试的有效性和实用性仍有待商榷,但无论好坏,它们仍然是AI玩家(如Meta)评估其模型的标准方式之一。

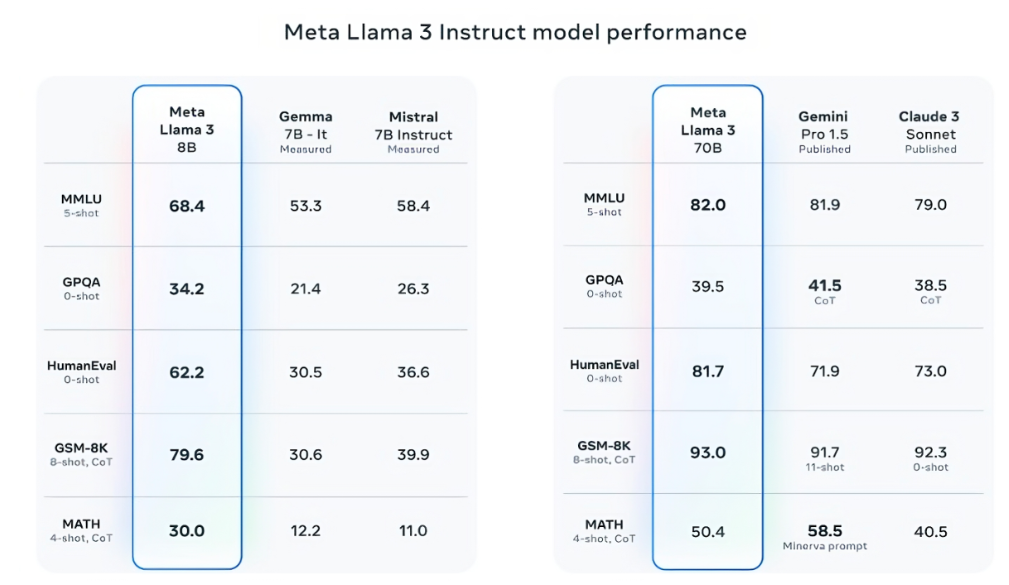

在至少九个基准测试中,Llama 3 8B的表现优于其他开源模型,如Mistral的Mistral 7B和谷歌的Gemma 7B,这两款模型均包含70亿参数。这些基准测试包括MMLU、ARC、DROP、GPQA(一组与生物学、物理学和化学相关的问题)、HumanEval(代码生成测试)、GSM-8K(数学文字问题)、MATH(另一个数学基准测试)、AGIEval(问题解决测试集)和BIG-Bench Hard(常识推理评估)。

需要注意的是,Mistral 7B和Gemma 7B并非最尖端的模型(Mistral 7B于去年9月发布),在Meta提及的多个基准测试中,Llama 3 8B的得分仅比它们高出几个百分点。然而,Meta还声称,参数计数更大的Llama 3模型——Llama 3 70B——与旗舰级生成式人工智能模型具有竞争力,其中就包括谷歌Gemini系列的最新成员Gemini 1.5 Pro。

在MMLU、HumanEval和GSM-8K这几个基准测试中,Llama 3 70B击败了Gemini 1.5 Pro。尽管它未能与Anthropic表现最佳的模型Claude 3 Opus相抗衡,但在五个基准测试(MMLU、GPQA、HumanEval、GSM-8K和MATH)中,Llama 3 70B的得分高于Claude 3系列中表现第二差的模型Claude 3 Sonnet。

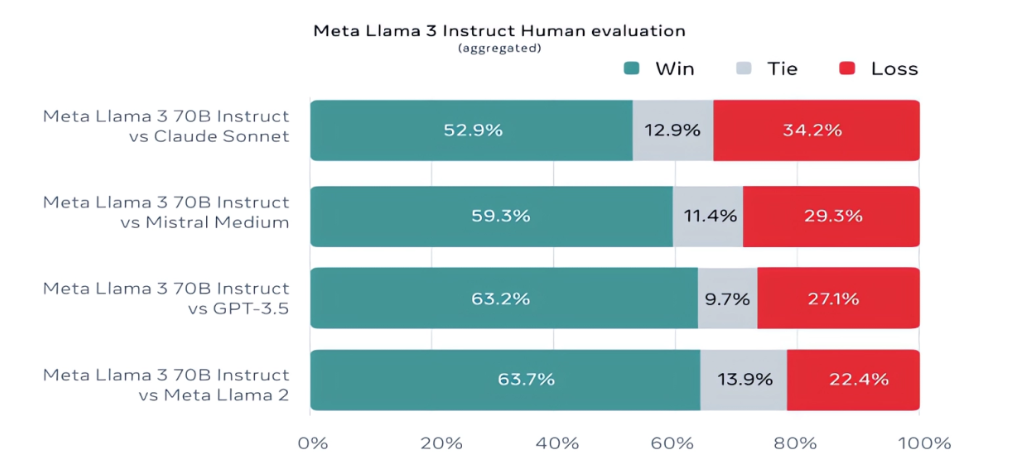

值得一提的是,Meta还开发了自己的测试集,涵盖了从编码和创意写作到推理和摘要等多种应用场景。令人惊讶的是,Llama 3 70B在与Mistral的Mistral Medium模型、OpenAI的GPT-3.5和Claude Sonnet的比较中脱颖而出。Meta表示,为确保客观性,其建模团队并未接触该测试集,但显然——鉴于测试集是Meta自己设计的——这些结果必须谨慎看待。

从更定性的角度来看,Meta表示,新Llama模型的用户应期待更高的“可操控性”、更低的拒绝回答问题的可能性,以及在处理琐事问题、历史相关问题和STEM领域(如工程和科学)以及一般编码建议方面的更高准确性。这在一定程度上归功于一个更大的数据集:包含15万亿个标记,即大约7500亿个单词的惊人数量——是Llama 2训练集大小的七倍。(在人工智能领域,“标记”指的是原始数据的细分部分,例如单词“fantastic”中的音节“fan”、“tas”和“tic”。)

关于这些数据,Meta并没有透露具体的来源,只是表示它们来自“公开可用的来源”。据称,这些数据量是Llama 2训练数据集的四倍之多,其中5%的数据是非英语数据,涵盖了大约30种语言,目的是提高模型在非英语语言上的性能。此外,Meta还提到,他们使用了合成数据——即AI生成的数据——来创建更长的训练文档,用于训练Llama 3模型。尽管这种方法可能会带来性能上的争议和缺陷,但Meta似乎对其抱有信心。

Meta在一篇与技术博客TechCrunch分享的文章中解释:“尽管我们目前发布的模型只针对英语输出进行了微调,但数据多样性的增加有助于模型更好地识别细微差别和模式,并在各种任务中展现出卓越性能。”

许多生成式人工智能供应商都将训练数据视为他们的竞争优势,因此对其及相关信息保持高度保密。同时,训练数据的细节也可能成为与知识产权相关的诉讼的潜在来源,这也是他们不愿透露太多信息的一个重要原因。最近就有报道指出,为了跟上AI竞争对手的步伐,Meta一度在AI训练中使用了受版权保护的电子书,尽管公司内部律师对此发出了警告。Meta和OpenAI也因此成为了作家们(包括喜剧演员莎拉·西尔弗曼)提起的持续诉讼的对象,他们指控这些供应商涉嫌未经授权使用受版权保护的数据进行训练。

那么,关于生成式AI模型常见的另外两个问题——毒性和偏见,Llama 3在这些方面是否有所改善呢?Meta表示确实有所改进。

Meta声称,他们开发了新的数据过滤管道,以提高模型训练数据的质量,并更新了两个生成式AI安全套件——Llama Guard和CybersecEval,旨在防止Llama 3模型和其他模型被误用和产生不想要的文本。此外,他们还发布了一款新工具Code Shield,用于检测可能引入安全漏洞的生成式AI模型中的代码。

然而,需要注意的是,数据过滤并非万无一失,而像Llama Guard、CyberSecEval和Code Shield这样的工具也只能在一定程度上发挥作用。例如,Llama 2模型曾被发现有编造问题答案和泄露私人健康及财务信息的倾向。因此,我们还需要等待并观察Llama 3模型在实际应用中的表现,包括学术界在替代基准测试中的测试结果。

目前,Meta表示Llama 3模型已经可供下载,并正在为Meta在Facebook、Instagram、WhatsApp、Messenger和网页上的Meta AI助手提供支持。很快,这些模型将在包括AWS、Databricks、Google Cloud、Hugging Face、Kaggle、IBM的WatsonX、Microsoft Azure、Nvidia的NIM和Snowflake在内的广泛云平台上以托管形式提供。未来,针对AMD、AWS、Dell、Intel、Nvidia和Qualcomm硬件优化的模型版本也将陆续推出。

虽然Llama 3模型可能广泛可用,但你会发现我们用“开放”这个词来描述它们时,其实并不是完全意义上的“开源”。这是因为,尽管Meta声称如此,但其Llama系列的模型并不像它想让人们相信的那样毫无限制。是的,这些模型既可用于研究也可用于商业应用。然而,Meta禁止开发人员使用Llama模型来训练其他生成式模型,而月活跃用户超过7亿的应用开发人员则必须向Meta申请特殊许可,该公司将根据自己的判断决定是否授予许可。

更强大的Llama模型即将问世。Meta表示,他们目前正在训练规模超过4000亿参数的Llama 3模型。这些模型将能够“用多种语言进行对话”,能够接收更多数据,并理解图像和其他模态,以及文本。这将使Llama 3系列与Hugging Face的Idefics2等开源产品保持一致。

Meta在博客文章中写道:“我们近期的目标是让Llama 3实现多语言和多模态,拥有更长的上下文,并继续提高核心[大型语言模型]能力,如推理和编码的整体性能。未来还有更多值得期待。”