通义千问团队开源轻量级MoE模型Qwen1.5-MoE-A2.7B

2024年04月01日 由 neo 发表

1014

0

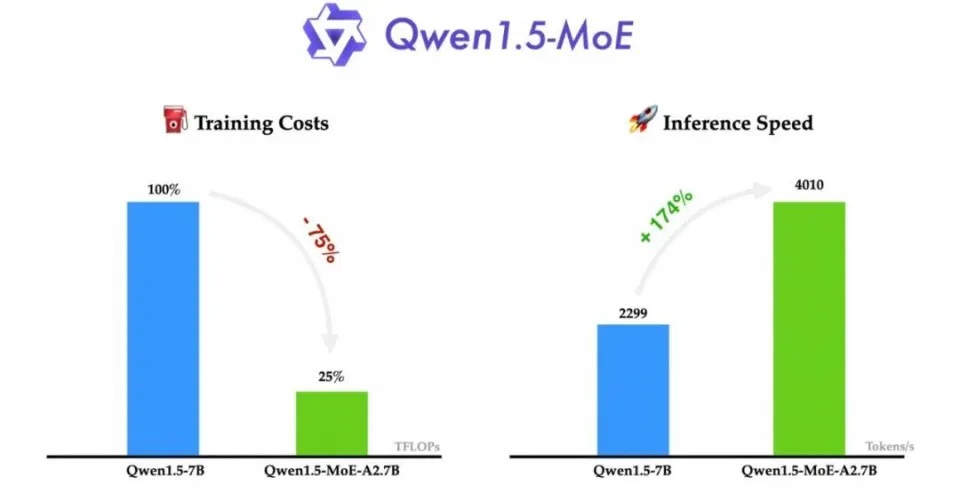

近日,通义千问团队再次以创新姿态引领行业风向,正式对外宣布其首个MoE模型——Qwen1.5-MoE-A2.7B的开源。这款模型以轻巧著称,仅拥有27亿激活参数,却展现出与业界标杆70亿参数大模型如Mistral 7B、Qwen1.5-7B等不相上下的强大实力。更为值得一提的是,该模型在训练成本及推理速度上均实现了显著优化。

据悉,Qwen1.5-MoE在模型结构上采用了精心设计的MoE架构,对transformer block中的MoE层配置进行了深度优化。其中,该模型引入了64个精细化的experts,并在初始化过程及routing机制上进行了创新。特别是其finegrained experts技术,通过巧妙地分割FFN层,生成了更多的expert,使得模型在不增加参数量的情况下,运算能力得到了显著提升。

实验数据表明,Qwen1.5-MoE-A2.7B模型在语言理解、数学及代码能力等多个维度均取得了令人瞩目的成绩,并在多语言基准测试中展现出强大的竞争力。尽管该模型仍有进一步优化的空间,但其性能已十分接近业界最佳的7B模型。

值得一提的是,Qwen1.5-MoE-A2.7B在训练成本上相比Qwen1.5-7B降低了高达75%,而推理速度则提升了1.74倍。这一成果不仅凸显了MoE模型在参数精简方面的优势,更展现了其在保持高性能的同时,大幅降低了计算资源的消耗,为AI领域的发展注入了新的活力。

通义千问团队此次开源的Qwen1.5-MoE-A2.7B模型无疑为人工智能领域带来了新的技术突破,预示着在不牺牲性能的前提下,通过技术革新实现更高效、更环保的模型运算和资源利用将成为未来AI发展的重要趋势。

文章来源:https://new.qq.com/rain/a/20240401A03D3U00

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消