Meta发布新型视频模型V-JEPA,推动AI理解世界

Meta 公司发布了 V-JEPA(Video Joint Embedding Predictive Architecture,视频联合嵌入预测架构的简称),这是一种通过观看视频来学习理解物理世界的新型视觉模型。JEPA 计划旨在让人工智能有能力通过形成其周围环境的内部模型来规划、推理和执行复杂的任务。

V-JEPA的发布是继去年推出I-JEPA(Image Joint Embedding Predictive Architecture)之后的又一里程碑。I-JEPA是第一个体现Yann LeCun关于更人性化的AI愿景的模型。I-JEPA开创了一种通过构建外部世界的内部模型来学习的先例,其重点在于抽象表示,而非直接的像素比较。它在各种计算机视觉任务中表现出高性能,同时保持计算效率,突显了预测架构的潜力。V-JEPA则进一步将这一愿景扩展到视频领域,利用I-JEPA的基础原则来理解动态交互和场景的时间演变。

V-JEPA 的与众不同之处在于它采用了自我监督学习方法,在抽象特征空间内预测视频的缺失部分,而不是采用生成方法来填充缺失像素。这种技术不是通过人工标注,而是像人类一样通过被动观察来建立对视频片段的概念理解。

V-JEPA利用未标记的视频进行学习,对于微调特定任务,它仅需要极少量的标记数据。通过比较紧凑的潜在表示,该方法还能集中计算高级语义信息,而不是不可预测的视觉细节。

研究人员报告说,与现有的视频模型相比,预训练效率明显提高,样本和计算效率提高了 1.5 到 6 倍。简化的方法为更快、更经济地开发未来的视频理解模型铺平了道路。

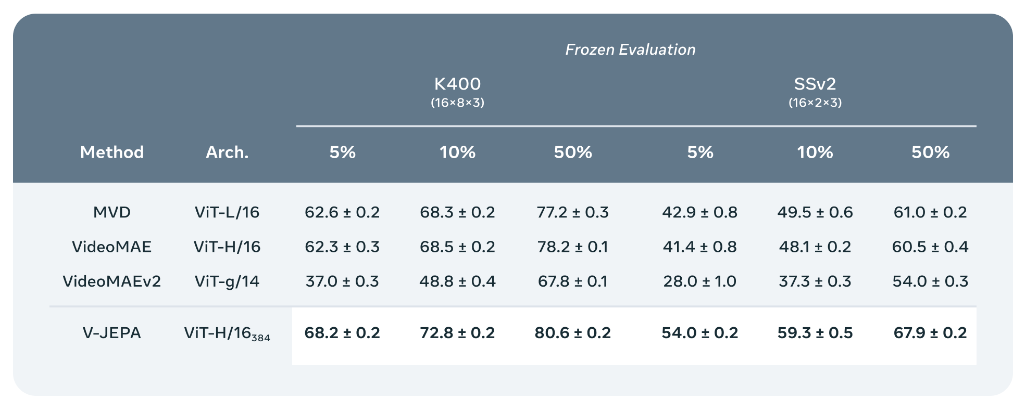

在 Kinetics-400、Something-v2 和 ImageNet 上的初步基准测试结果已经达到或超过了现有的视频识别模型。更令人印象深刻的是,当研究人员冻结 V-JEPA 并添加一个专门的分类层时,该模型的性能达到了新的高度--所有这些都是在以前数据要求的一小部分上训练出来的。

V-JEPA的推出不仅仅是为了推进视频理解,而是为了重新定义AI解释世界的可能性。通过学习预测和理解视频中未见的部分,V-JEPA正逐渐接近一种能够通过推理和预测物理现象来进行机器智能的形式,类似于人类通过观察学习。此外,该模型将学到的表示应用于各种任务时的灵活性,而无需进行大量再训练,为从动作识别到增强现实环境辅助等各种研究和应用开辟了新的途径。

展望未来,V-JEPA 团队表示正在探索整合音频等多模态数据,以丰富模型对世界的理解。这种演变代表了人工智能研究的一个激动人心的前沿领域,有望释放机器智能的新能力。LeCun 认为,这将带来更灵活的推理、规划和通用智能。