如何在Pytorch中构建Transformer

2023年12月22日 由 alex 发表

826

0

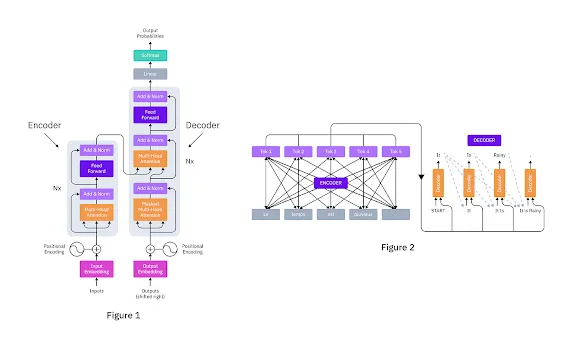

Transformer在现代机器学习中非常强大,特别是在自然语言处理(NLP)任务中,如语言翻译和文本摘要。它们通过取代长短期记忆(LSTM)网络而在该领域引起了革命,这得益于它们处理长程依赖和并行计算的能力。Transformer的核心是注意力机制,特别是“自注意力”概念,它允许模型加权并优先考虑输入数据的不同部分。正是这种机制使得Transformer能够管理数据中的长程依赖。从根本上讲,它是一种加权方案,允许模型在生成输出时关注输入的不同部分。这种机制让模型可以考虑输入序列中的不同单词或特征,并为每个分配一个“权重”,表示它在产生给定输出时的重要性。

Transformer实现步骤

- 设置PyTorch:在开始构建Transformer之前,正确设置工作环境是至关重要的。首先,需要安装PyTorch。PyTorch(当前稳定版本 — 2.0.1)可以通过pip或conda包管理器轻松安装。

- 导入库和模块:构建Transformer的第一步是导入所需的库和模块。需要以下库:torch,torch.nn,torch.nn.functional和torch.optim。

- 定义基本构建块:下一步是定义Transformer的基本构建块。这些包括多头注意力(Multi-head Attention)、位置感知前馈网络(Position-Wise Feed-Forward Networks)和位置编码(Positional Encoding)。

- 构建编码器(Encoder)块:编码器块负责对输入序列进行编码。它由一堆相同的层组成,每一个层都有两个子层:一个多头自注意力机制和一个位置感知的全连接前馈网络。

- 构建解码器(Decoder)块:解码器块负责对编码后的输入序列进行解码。它也由一堆相同的层组成,每一个层都有三个子层:一个多头自注意力机制、一个针对编码器块输出的多头注意力机制,以及一个位置感知的全连接前馈网络。

- 结合编码器和解码器层创建完成的Transformer网络:最后一步是将编码器和解码器层结合起来,创建完成的Transformer网络。

现在我们一步步用Pytorch构建模型

在我们开始之前,确保已经安装了PyTorch。如果没有,可以使用以下命令进行安装:

pip install torch torchvision

步骤 1:导入库

首先导入必要的库:

import torch

import torch.nn as nn

import torch.optim as optim

步骤2:定义Transformer模型

Transformer架构包含一个编码器和一个解码器。为了简化问题,我们将重点关注编码器。让我们定义变压器的基本组件:

class TransformerEncoderLayer(nn.Module):

def __init__(self, d_model, nhead, dim_feedforward=2048, dropout=0.1):

super(TransformerEncoderLayer, self).__init__()

self.self_attn = nn.MultiheadAttention(d_model, nhead, dropout=dropout)

self.linear1 = nn.Linear(d_model, dim_feedforward)

self.dropout = nn.Dropout(dropout)

self.linear2 = nn.Linear(dim_feedforward, d_model)

self.norm1 = nn.LayerNorm(d_model)

self.norm2 = nn.LayerNorm(d_model)

def forward(self, src):

src2 = self.self_attn(src, src, src)[0]

src = src + self.dropout(src2)

src = self.norm1(src)

src2 = self.linear2(self.dropout(torch.relu(self.linear1(src))))

src = src + self.dropout(src2)

src = self.norm2(src)

return src

class TransformerEncoder(nn.Module):

def __init__(self, encoder_layer, num_layers):

super(TransformerEncoder, self).__init__()

self.layers = nn.ModuleList([encoder_layer() for _ in range(num_layers)])

def forward(self, src):

for layer in self.layers:

src = layer(src)

return src

步骤3:实例化模型

现在,让我们创建我们的Transformer模型的一个实例:

d_model = 512 # Adjust according to your requirements

nhead = 8

num_layers = 6

transformer_model = TransformerEncoder(TransformerEncoderLayer(d_model, nhead), num_layers)

步骤4:数据准备

为训练准备你的数据。为了简化,我们将使用一个虚拟数据集:

加载你的数据集并根据需要进行预处理

例如,分词,填充等等。

步骤5:损失函数和优化器

定义用于训练的损失函数和优化器:

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(transformer_model.parameters(), lr=0.001)

步骤6:训练模型

现在,让我们来训练变压器模型:

num_epochs = 10

for epoch in range(num_epochs):

for data in dataloader: # Iterate over your data batches

inputs, targets = data

optimizer.zero_grad()

outputs = transformer_model(inputs)

loss = criterion(outputs, targets)

loss.backward()

optimizer.step()

步骤7:评估模型

在训练之后,对模型进行评估是非常重要的,需要在一个独立的测试集上进行:

# Prepare your test data

# Evaluate the model

with torch.no_grad():

for test_data in test_dataloader:

test_inputs, test_targets = test_data

test_outputs = transformer_model(test_inputs)

# Perform evaluation metrics calculation

就是这样。我们使用PyTorch构建并训练了一个Transformer模型。

文章来源:https://medium.com/@abdulkaderhelwan/build-a-transformer-in-pytorch-b9b185f7f7e2

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消