AI程序实现音频与照片生成逼真的面部动画

由新加坡国立大学计算机科学与工程学院的卢世坚副教授领导的研究团队开发出了一种计算机程序,能够根据音频剪辑和面部照片生成反映说话人面部表情和头部动作的逼真视频。

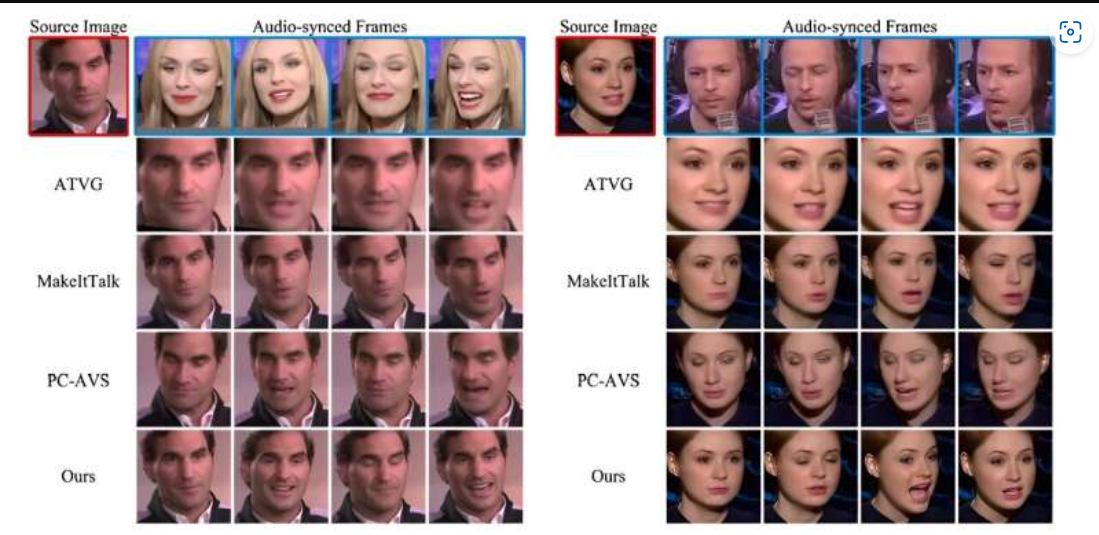

名为DIverse yet Realistic Facial Animations(简称DIRFA)的人工智能程序接收音频和照片,并生成一个三维视频,显示出与说话音频同步的逼真且一致的面部动画。新加坡国立大学开发的DIRFA程序改进了现有方法在姿势变化和情绪控制方面的困难。

为了实现这一目标,团队使用了超过6000人的超过100万个音频视频剪辑,这些剪辑来自一个开放源数据库,通过预测语音提示并将其与面部表情和头部动作相关联,训练DIRFA。

研究人员表示,DIRFA可能会在各个行业和领域带来新的应用,包括医疗保健,因为它可以实现更复杂、逼真的虚拟助理和聊天机器人,改善用户体验。它还可以作为一个强大的工具,帮助言语或面部残疾的人通过富有表情的头像或数字化形象传达自己的思想和情感,提高他们的沟通能力。

对应作者、新加坡国立大学计算机科学与工程学院的卢世坚副教授在研究中表示:“我们研究的影响可能是深远的,这一技术将通过结合人工智能和机器学习等技术,彻底改变多媒体通信领域,实现高度逼真的言语视频的生成。

我们的程序建立在之前的研究基础上,并代表了技术的进步,因为我们的程序只使用音频记录和静态图像,就能产生包含准确的唇部动作、生动的面部表情和自然的头部姿势的视频。”

新加坡国立大学计算机科学与工程学院的博士研究生吴荣亮博士是本研究的第一作者,他表示:“言语表现出多种变化。在不同环境下,个体会以不同的方式发音,包括持续时间、振幅、音调等多种变化。此外,除了语言内容,言语还传达了丰富的关于说话人情绪状态和性别、年龄、种族乃至个性特征的信息。

我们的方法从音频表示学习的角度来提高性能,可称为人工智能和机器学习领域的一项开创性工作。”吴博士目前是新加坡科学技术研究局信息通信研究所的研究科学家。

以上研究结果发表在《模式识别》杂志上。

准确地转化音频为具体动作的艺术

研究人员表示,通过音频驱动逼真的面部表情是一个复杂的挑战。对于给定的音频信号,可能会有许多合理的面部表情选择,而处理一系列随时间变化的音频信号时,这些可能性会变得更多。

由于音频通常与唇部动作有很强的关联,但与面部表情和头部位置的关联较弱,团队的目标是创建能够展示与提供音频相对应的精确唇部同步、丰富面部表情和自然头部动作的说话面部。

为了解决这个问题,研究团队首先设计了他们的人工智能模型DIRFA,以捕捉音频信号和面部动画之间的复杂关系。卢副教授补充说:“具体来说,DIRFA根据输入音频模拟面部动画的可能性,如挑起的眉毛或皱起的鼻子。这种建模使程序能够将音频输入转化为多样而高度逼真的面部动画序列,以指导说话面部的生成。

广泛的实验表明,DIRFA可以生成具有准确唇部动作、生动面部表情和自然头部姿势的说话面部。然而,我们正在努力改善程序的界面,允许对某些输出进行控制。例如,DIRFA目前不允许用户调整某个表情,比如将皱眉变成微笑。”

除了向DIRFA的界面添加更多选项和改进外,新加坡国立大学的研究人员还将使用更广泛的数据集来微调其面部表情,其中包括更多种类的面部表情和声音音频剪辑。