伯克利开源人工智能图像编辑模型InstructPix2Pix

2023年07月19日 由 Susan 发表

439702

0

伯克利人工智能研究(BAIR)实验室的研究人员开源了InstructPix2Pix,这是一种深度学习模型,可以遵循人类指令来编辑图像。InstructPix2Pix在合成数据上进行了训练,其性能优于基线人工智能图像编辑模型。

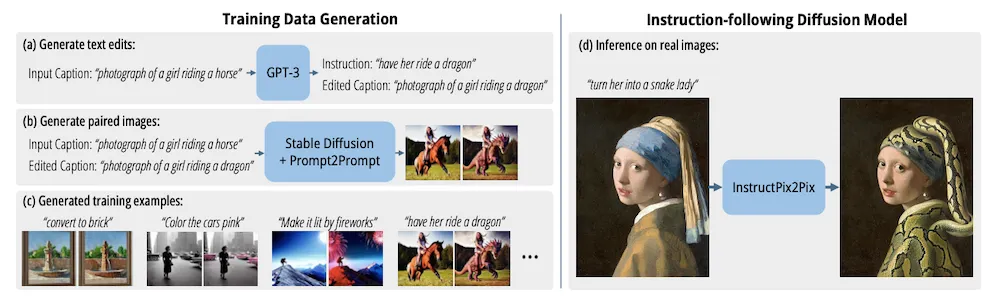

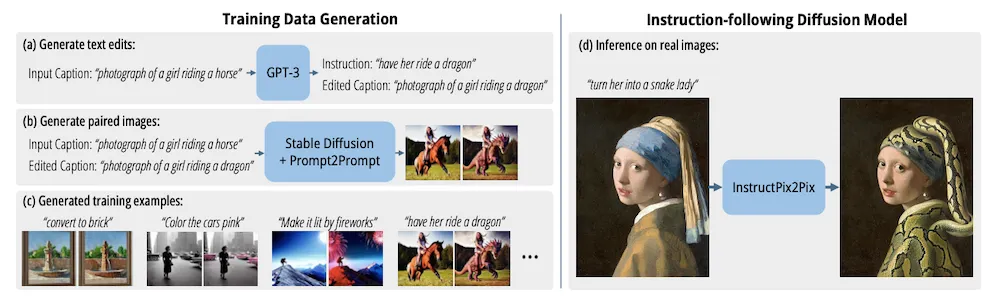

BAIR 团队在最近的 IEEE/CVF 计算机视觉和模式识别 (CVPR) 2023 会议上介绍了他们的工作。他们首先生成了一个合成训练数据集,其中训练示例是成对的图像以及将第一个图像转换为第二个图像的编辑指令。该数据集用于训练图像生成扩散模型。结果是一个模型,给定源图像,可以接受有关如何编辑图像的基于文本的说明;例如,给定一个人骑马的图像和提示“让她骑龙”,它将输出原始图像,马被龙替换。根据BAIR研究人员的说法:“尽管完全在合成示例上进行训练,但我们的模型实现了对任意真实图像和自然人类编写指令的零镜头泛化。我们的模型支持直观的图像编辑,可以按照人类指令执行各种编辑集合:替换对象、更改图像样式、更改设置、艺术媒介等。”

早期用于图像编辑的人工智能工作通常基于样式转换,流行的文本到图像生成模型(如DALL-E和稳定扩散)也支持图像到图像样式转换操作;但是,使用这些模型进行有针对性的编辑具有挑战性。最近,InfoQ介绍了Microft的Visual ChatGPT,它可以调用外部工具来编辑图像,给定所需编辑的文本描述。

为了训练InstructPix2Pix,BAIR首先创建了一个合成数据集。为此,该团队在由人类编写的示例组成的小型数据集上微调了 GPT-3,该数据集由输入标题、编辑说明和所需的输出标题组成。然后,这个微调的模型被赋予了一个输入图像标题的大型数据集,从中生成了超过 450k 的编辑和输出标题。然后,该团队将输入和输出字幕提供给预先训练的提示到提示模型,该模型根据字幕生成成对的相似图像。

鉴于这个数据集,研究人员训练了基于稳定扩散的InstructPix2Pix。为了评估其性能,该团队将其输出与基线模型SDEdit进行了比较。他们在两个指标之间进行了权衡:一致性,即输入图像和编辑图像的 CLIP 嵌入之间的余弦相似性;和方向相似性,或编辑标题中的更改与编辑图像中的更改的一致性。在实验中,对于给定的方向相似性值,InstructPix2Pix产生的图像比SDEdit更一致。

在他的深度学习通讯The Batch中,人工智能研究员Andrew Ng评论了InstructPix2Pix:“这项工作简化了修改生成的和人造图像,并在修改时提供了更连贯的结果。巧妙地使用预先存在的模型使作者能够使用相对较少的人工标记示例在新任务上训练他们的模型。”

InstructPix2Pix代码可在GitHub上找到。该模型和基于网络的演示可在Huggingface上找到。

来源:https://www.infoq.com/news/2023/07/berkeley-instruct-pix2pix/

BAIR 团队在最近的 IEEE/CVF 计算机视觉和模式识别 (CVPR) 2023 会议上介绍了他们的工作。他们首先生成了一个合成训练数据集,其中训练示例是成对的图像以及将第一个图像转换为第二个图像的编辑指令。该数据集用于训练图像生成扩散模型。结果是一个模型,给定源图像,可以接受有关如何编辑图像的基于文本的说明;例如,给定一个人骑马的图像和提示“让她骑龙”,它将输出原始图像,马被龙替换。根据BAIR研究人员的说法:“尽管完全在合成示例上进行训练,但我们的模型实现了对任意真实图像和自然人类编写指令的零镜头泛化。我们的模型支持直观的图像编辑,可以按照人类指令执行各种编辑集合:替换对象、更改图像样式、更改设置、艺术媒介等。”

早期用于图像编辑的人工智能工作通常基于样式转换,流行的文本到图像生成模型(如DALL-E和稳定扩散)也支持图像到图像样式转换操作;但是,使用这些模型进行有针对性的编辑具有挑战性。最近,InfoQ介绍了Microft的Visual ChatGPT,它可以调用外部工具来编辑图像,给定所需编辑的文本描述。

为了训练InstructPix2Pix,BAIR首先创建了一个合成数据集。为此,该团队在由人类编写的示例组成的小型数据集上微调了 GPT-3,该数据集由输入标题、编辑说明和所需的输出标题组成。然后,这个微调的模型被赋予了一个输入图像标题的大型数据集,从中生成了超过 450k 的编辑和输出标题。然后,该团队将输入和输出字幕提供给预先训练的提示到提示模型,该模型根据字幕生成成对的相似图像。

指导Pix2Pix架构。图片来源:https://arxiv.org/abs/2211.09800

鉴于这个数据集,研究人员训练了基于稳定扩散的InstructPix2Pix。为了评估其性能,该团队将其输出与基线模型SDEdit进行了比较。他们在两个指标之间进行了权衡:一致性,即输入图像和编辑图像的 CLIP 嵌入之间的余弦相似性;和方向相似性,或编辑标题中的更改与编辑图像中的更改的一致性。在实验中,对于给定的方向相似性值,InstructPix2Pix产生的图像比SDEdit更一致。

在他的深度学习通讯The Batch中,人工智能研究员Andrew Ng评论了InstructPix2Pix:“这项工作简化了修改生成的和人造图像,并在修改时提供了更连贯的结果。巧妙地使用预先存在的模型使作者能够使用相对较少的人工标记示例在新任务上训练他们的模型。”

InstructPix2Pix代码可在GitHub上找到。该模型和基于网络的演示可在Huggingface上找到。

来源:https://www.infoq.com/news/2023/07/berkeley-instruct-pix2pix/

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消